通过归一化加速模型收敛并稳定训练过程

介绍

高效训练深度学习模型是具有挑战性的。随着自然语言处理(NLP)模型的规模和架构复杂性的不断增长,这个问题变得更加困难。为了处理数十亿个参数,提出了更多的优化方法来加快收敛速度和稳定训练。其中最显著的技术之一就是归一化。

在本文中,我们将学习一些归一化技术,了解它们的工作原理以及如何在NLP深度模型中使用。

为什么不使用BatchNorm?

BatchNorm [2] 是一种早期的归一化技术,旨在解决内部协变量偏移的问题。

简单来说,当层的输入数据分布发生变化时,就会发生内部协变量偏移。当神经网络被强制适应不同的数据分布时,梯度更新在批次之间发生剧烈变化。因此,模型需要更长的时间来调整、学习正确的权重并收敛。随着模型规模的增长,这个问题变得更加严重。

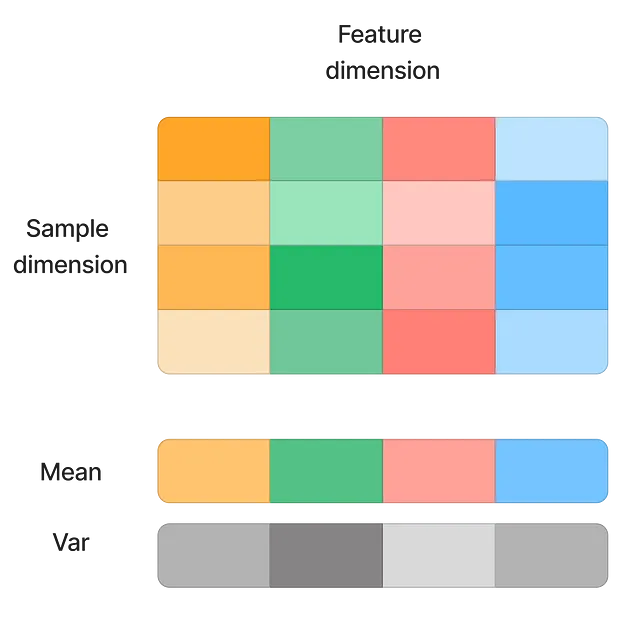

最初的解决方案包括使用较小的学习率(以减小数据分布变化的影响)和仔细的权重初始化。BatchNorm通过对特征维度上的输入进行归一化来有效解决这个问题。

这种技术显著加快了收敛速度,并允许使用更高的学习率,因为模型对异常值不太敏感。然而,它仍然存在一些缺点:

- 小批量大小:BatchNorm依赖于批量数据来计算特征的均值和标准差。当批量大小较小时,均值和方差不能代表整体数据。因此,无法使用BatchNorm进行在线学习。

- 序列输入:在BatchNorm中,每个输入样本的归一化取决于同一批次中的其他样本。这在处理序列数据时效果不佳。例如…