近年来,人工智能代理在各种复杂的游戏环境中取得了成功。例如,AlphaZero在棋类游戏中击败了世界冠军程序,尽管开始时只知道如何玩基本规则。通过强化学习(RL),这个单一系统通过不断进行游戏的循环过程来学习,通过试错的方式逐渐提高。但是AlphaZero仍然需要单独训练每个游戏,无法在不重复RL过程的情况下学习另一个游戏或任务。强化学习的其他成功案例,如Atari,Capture the Flag,StarCraft II,Dota 2和Hide-and-Seek也存在相同的问题。DeepMind的使命是解决智能问题,推动科学和人类进步,因此我们探索了如何克服这一限制,创建具有更普适和适应性行为的AI代理。这些代理不再一次学习一个游戏,而是能够适应全新的环境并玩一系列游戏和任务,包括以前从未见过的。

今天,我们发布了一篇名为“开放式学习导致普遍能力代理”的预印本,详细介绍了我们训练一个能够在许多不同游戏中玩耍而不需要人类交互数据的代理的第一步。我们创建了一个名为XLand的广阔游戏环境,其中包括许多多人游戏,这些游戏存在于一致的、与人类相关的3D世界中。这个环境使得我们能够制定新的学习算法,动态控制代理的训练和训练的游戏。随着训练中出现的挑战,代理的能力会逐步提高,学习过程会不断细化训练任务,使代理不断学习。结果是,代理能够在各种任务中取得成功,从简单的物体查找问题到隐藏和寻找和夺旗等复杂游戏,这些游戏在训练过程中从未遇到过。我们发现代理表现出一般的启发式行为,如试验,这些行为广泛适用于许多任务,而不是专门针对个别任务。这种新的方法是朝着创建更普适的代理并在不断变化的环境中快速适应迈出的重要一步。

代理玩各种测试任务。代理在广泛的游戏中接受训练,因此能够推广到训练中从未见过的测试游戏。

无限的训练任务

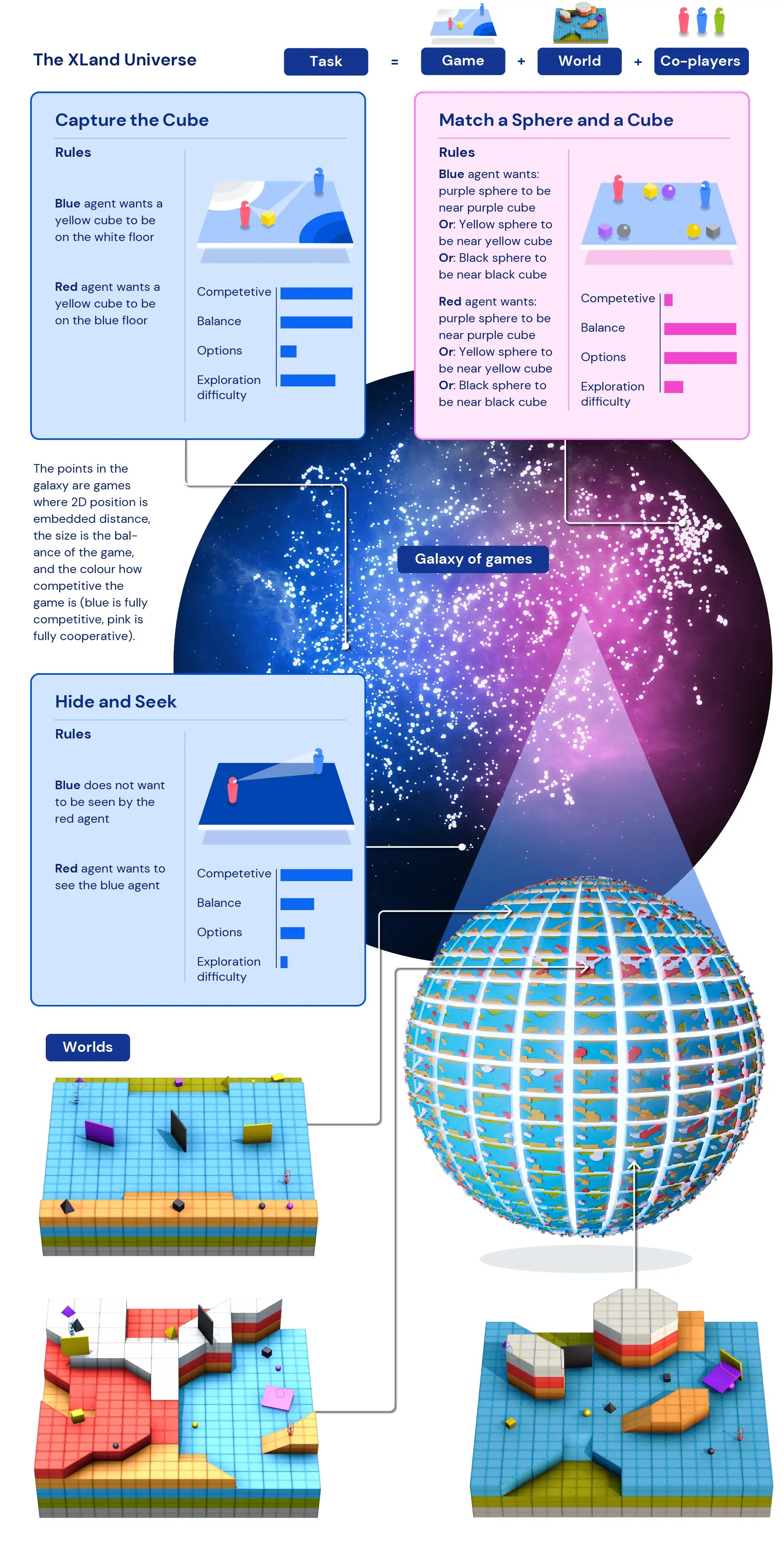

缺乏训练数据(其中“数据”点是不同的任务)是限制强化学习训练代理行为普遍性的主要因素之一。由于无法在足够多的任务集上训练代理,通过强化学习训练的代理无法将其学到的行为适应新的任务。但是通过设计一个模拟空间,允许程序生成任务,我们的团队创建了一种训练和生成经验的方法,这些任务是通过程序创建的。这使得我们可以在XLand中包含数十亿个任务,涵盖各种游戏、世界和玩家。

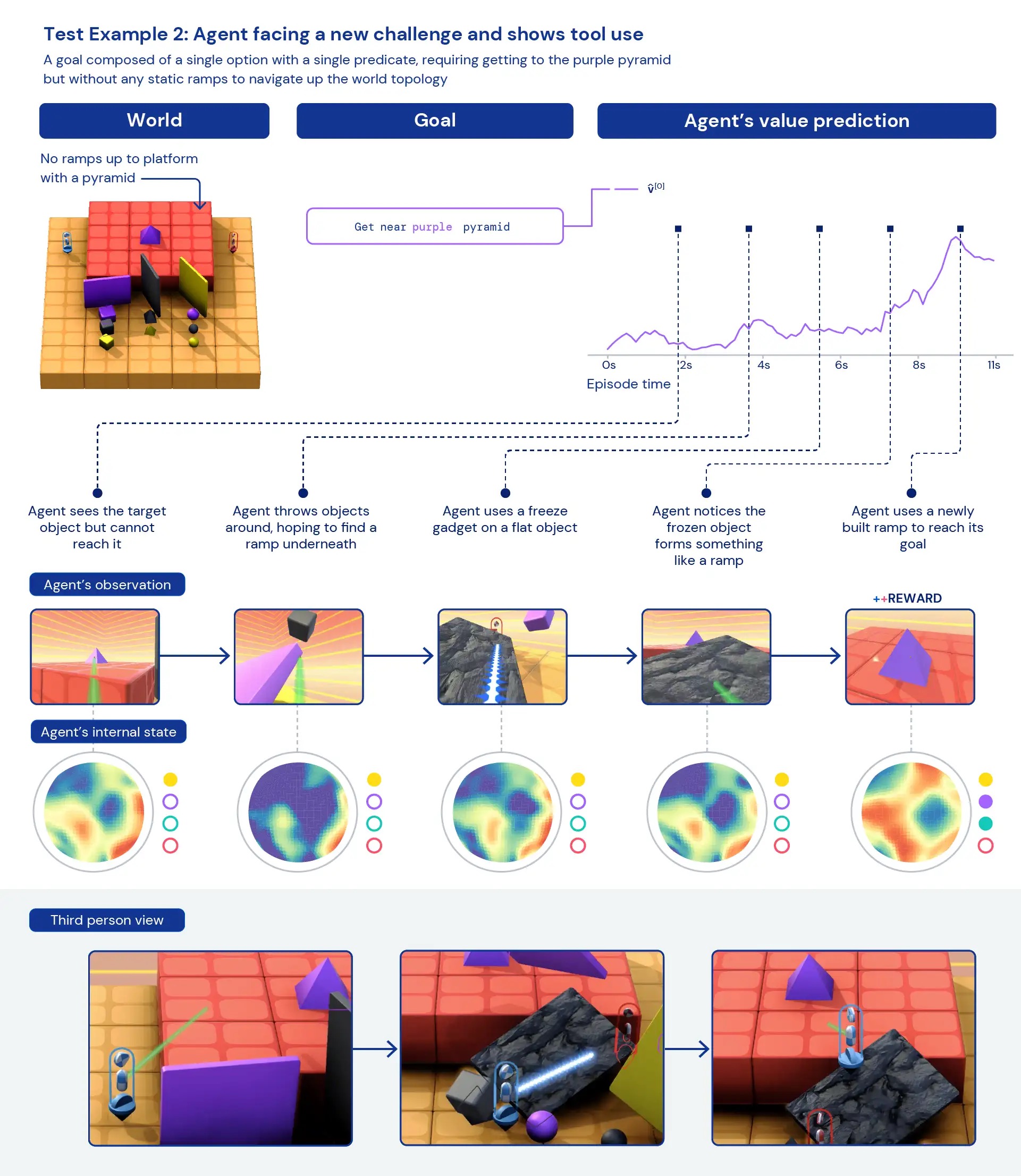

我们的AI代理在多人环境中扮演3D第一人称角色,旨在模拟物理世界。玩家通过观察RGB图像感知周围环境,并接收到关于目标的文本描述,并在一系列游戏中接受训练。这些游戏可以是简单的合作游戏,例如查找物体和导航世界,玩家的目标可能是“靠近紫色立方体”。更复杂的游戏可以基于选择多个有奖励的选项,例如“靠近紫色立方体或将黄色球放在红色地板上”,更具竞争性的游戏包括与其他玩家对战,例如对称的藏匿和搜寻游戏,每个玩家的目标是“看到对手并让对手看不到我”。每个游戏定义了玩家的奖励,每个玩家的最终目标是最大化奖励。

由于XLand可以以程序化方式指定,游戏空间可以自动和算法化地生成数据。由于XLand中的任务涉及多个玩家,合作玩家的行为极大地影响AI代理面临的挑战。这些复杂的非线性交互为训练提供了理想的数据源,因为环境成分的微小变化有时会导致代理面临巨大的挑战变化。

训练方法

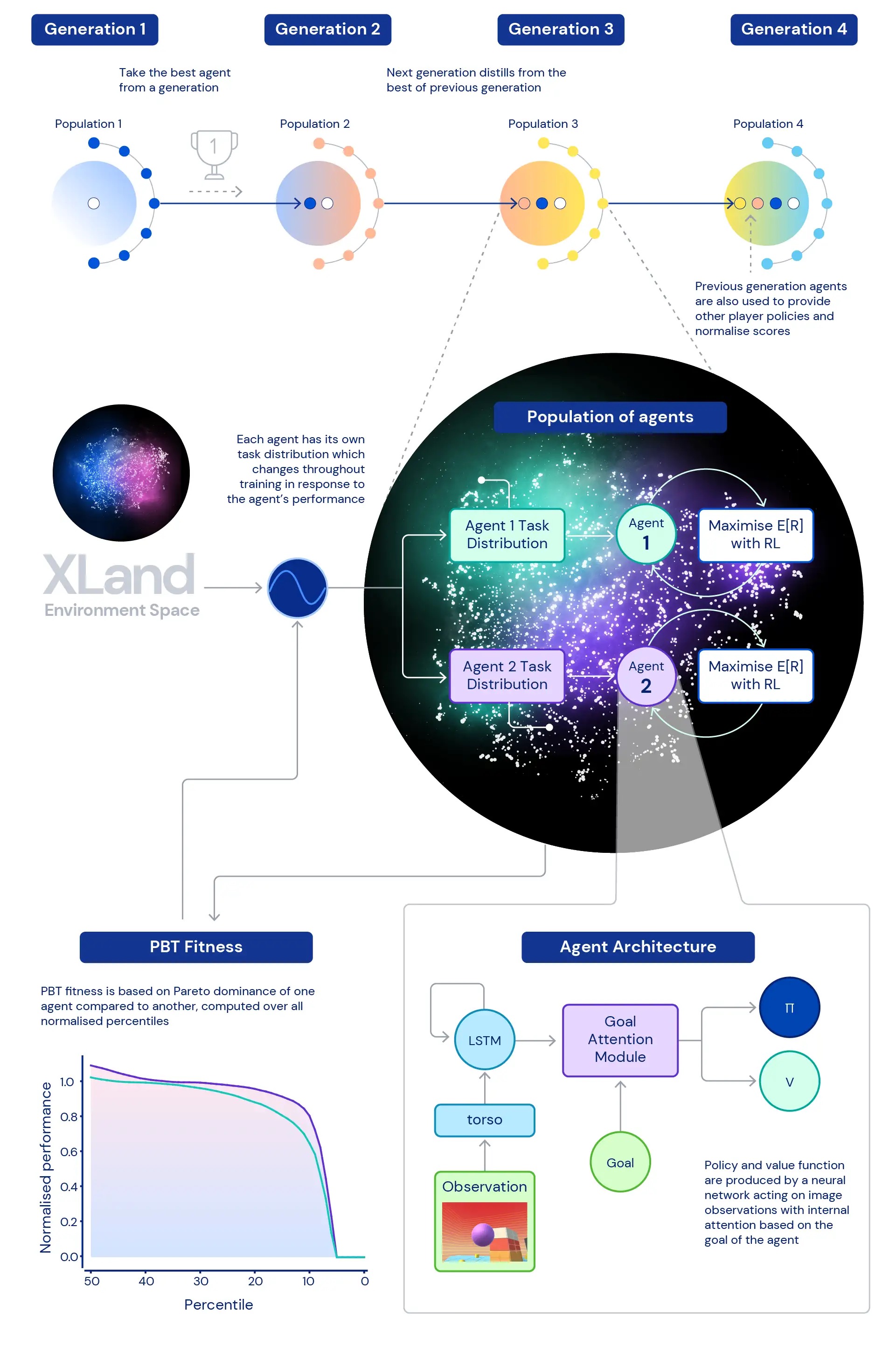

我们研究的核心是深度强化学习在训练我们代理人的神经网络中的作用。我们使用的神经网络架构提供了一个关注机制,通过估计与代理人所玩游戏独特的子目标,来引导代理人的注意力。我们发现,这种目标关注代理人(GOAT)可以学习到更具普适性的策略。

我们还探索了一个问题:什么样的训练任务分布会产生最优秀的代理人,特别是在如此广阔的环境中?我们使用的动态任务生成允许对代理人的训练任务分布进行持续变化:每个任务都生成为既不太难也不太简单,而是适合训练的。然后,我们使用基于群体的训练(PBT)来根据旨在提高代理人整体能力的适应性调整动态任务生成的参数。最后,我们将多个训练运行链接在一起,使每一代代理人可以从前一代代理人中获取启动信息。

这导致了一个最终的训练过程,其中深度强化学习在核心位置,每一步经验都会更新代理人的神经网络:

- 经验的步骤来自根据代理人行为动态生成的训练任务,

- 代理人的任务生成函数会根据代理人的相对表现和稳定性进行变异,

- 在最外层循环中,代理人的世代代之间相互启动,为多人游戏环境提供越来越丰富的合作伙伴,并重新定义进展的衡量标准。

训练过程从零开始,逐步构建复杂性,不断改变学习问题以保持代理人的学习。这种联合学习系统的迭代性质,不仅仅优化有界性能指标,而是迭代定义的普适能力谱,为代理人提供了一个潜在的无限学习过程,仅受环境空间和代理人神经网络表达能力的限制。

衡量进展

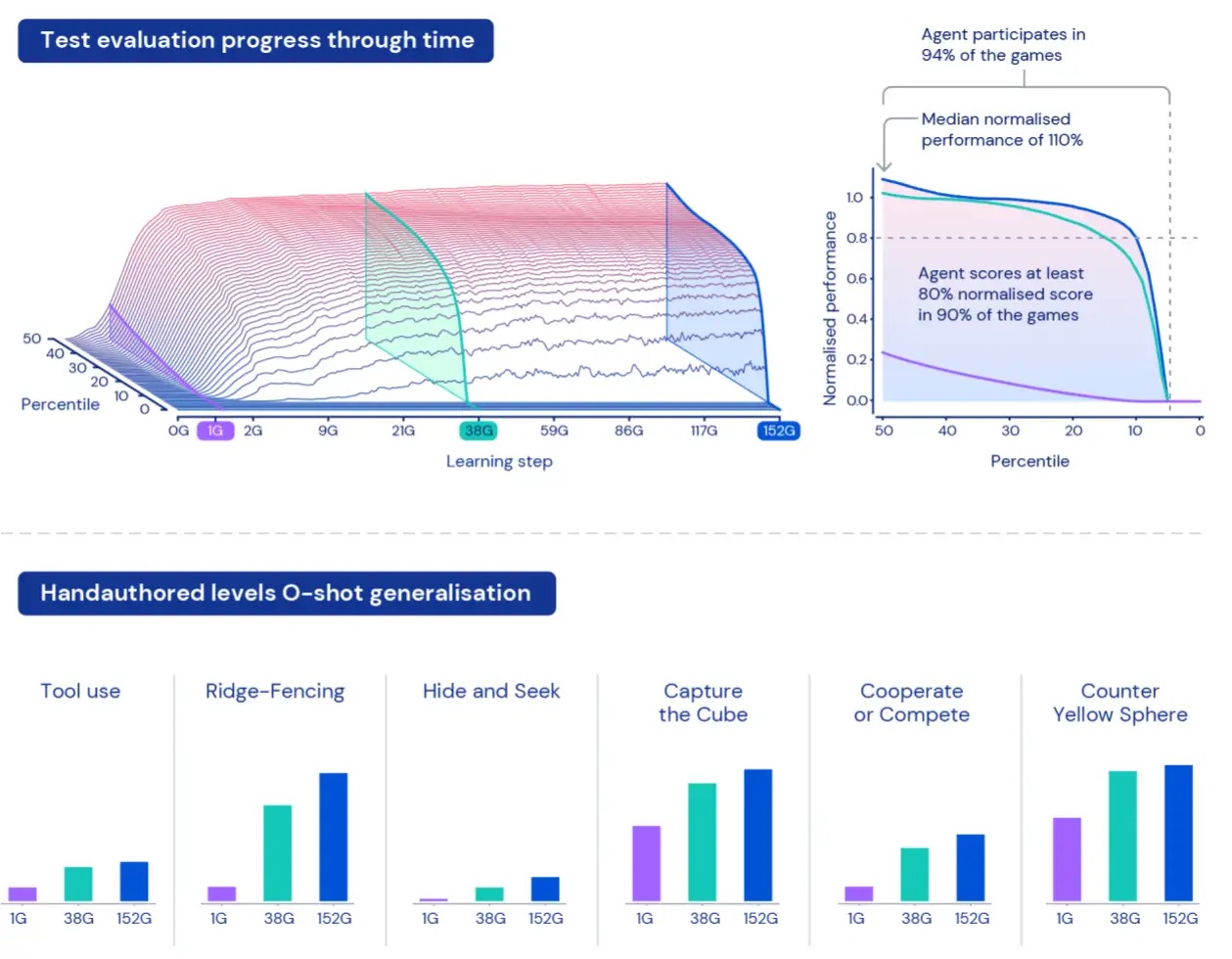

为了衡量代理人在这个广阔宇宙中的表现,我们使用游戏和世界创建了一组评估任务,这些任务与用于训练的数据保持分离。这些“保留”任务包括特定的人工设计任务,如躲猫猫和夺旗。

由于XLand的规模,理解和描述我们代理人的表现可能是一个挑战。每个任务都涉及不同层次的复杂性,可以实现的奖励规模以及代理人的不同能力,因此仅仅对保留任务的奖励进行平均处理将隐藏复杂性和奖励的实际差异,并且会将所有任务视为同样有趣,而这在程序化生成的环境中并不一定成立。

为了克服这些限制,我们采取了不同的方法。首先,我们使用我们当前训练过的玩家集合计算纳什均衡值来对每个任务的得分进行归一化。其次,我们考虑整个归一化分数的分布,而不是只看平均归一化分数,我们会关注不同百分位数的归一化分数,以及代理人在至少一个步骤的奖励中得分的任务百分比:参与度。这意味着一个代理人只有在超过所有百分位数的表现时才被认为比另一个代理人更好。这种衡量方法为我们评估代理人的表现和稳健性提供了有意义的方式。

更具普适能力的代理人

经过五代代理人的训练,我们在保留的评估空间中看到了学习和表现的持续改进。在XLand中玩了大约700,000个独特的游戏,涉及4,000个独特的世界,最终一代的每个代理人通过3.4百万个独特任务获得了2000亿个训练步骤。此时,我们的代理人已经能够参与几乎所有程序化生成的评估任务,除了一些对于人类来说也是不可能的任务。而我们所看到的结果清楚地展示了任务空间中的普遍、零-shot行为,归一化得分百分位数的前沿不断提高。

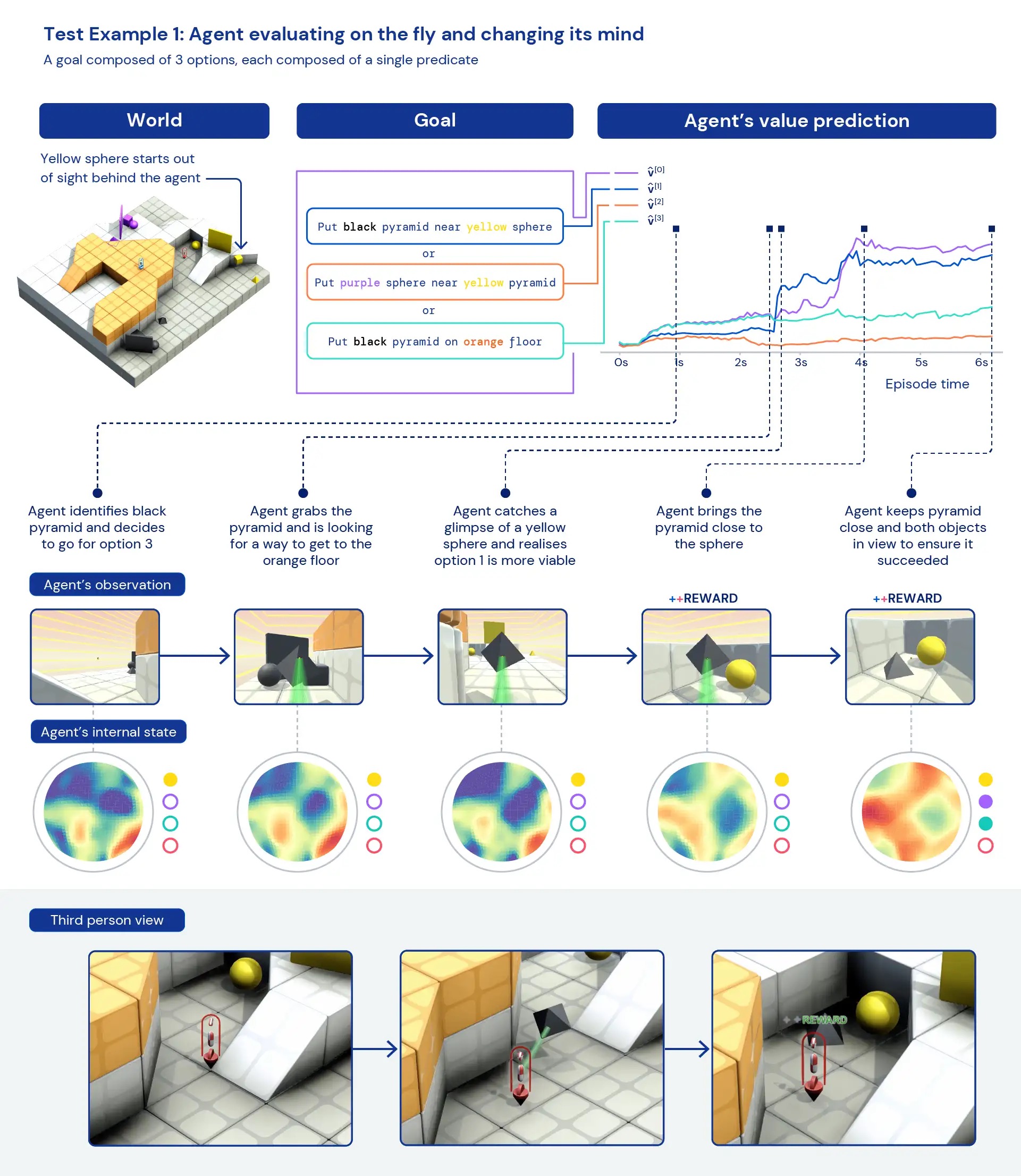

以定性的方式观察我们的智能体,我们经常看到一般的启发式行为出现——而不是针对个别任务的高度优化的特定行为。代理人不是在新的情况下准确地知道应该做什么,我们看到他们通过实验和改变世界的状态来达到有奖励的状态。我们还看到代理人依赖其他工具,包括用于遮挡能见度的物体,用于建造坡道和检索其他物体。由于环境是多人游戏,我们可以在训练期间研究代理人在保留的社交困境中的行为进展,比如在“鸡”游戏中。随着训练的进行,我们的代理人在与自己的副本玩耍时似乎表现出更多的合作行为。鉴于环境的性质,很难确定意图——我们看到的行为经常似乎是偶然的,但我们仍然看到它们一直发生。

通过分析代理人的内部表示,我们可以说,通过在广阔的任务空间中采用这种强化学习方法,我们的代理人意识到了自己的身体基本知识和时间的流逝,以及他们遇到的游戏的高层结构。更有趣的是,他们明显认识到环境中的奖励状态。这种新任务中行为的广泛性和多样性暗示了在下游任务上对这些代理人进行微调的潜力。例如,我们在技术论文中展示,只需专注训练30分钟,这些代理人就能够快速适应新出现的复杂任务,而从头开始训练的代理人则无法学习这些任务。

通过开发类似XLand的环境和支持开放式复杂性创建的新训练算法,我们已经看到了强化学习代理人的零样本泛化的明显迹象。虽然这些代理人在这个任务空间内开始变得普遍能力,但我们期待继续研究和开发,进一步提高他们的性能,创造更加适应性的代理人。

更多详情请参阅我们的技术论文预印本,以及我们所见结果的视频。我们希望这能帮助其他研究人员找到一条通向创建更适应性强、能力更全面的AI智能体的新路径。如果您对这些进展感到兴奋,请考虑加入我们的团队。