语言模型的不良行为

在大型文本语料库上训练的语言模型可以生成流畅的文本,并展示出作为零样本学习器和代码生成工具的潜力,以及其他能力。然而,先前的研究还发现了一些与语言模型使用相关的问题,包括分布偏见、社会刻板印象、潜在的训练样本泄露以及其他可能的语言模型危害。语言模型危害的一种特殊类型是生成有毒语言,其中包括仇恨言论、侮辱、亵渎和威胁。

在我们的论文中,我们关注语言模型及其生成有毒语言的倾向。我们研究了不同方法减轻语言模型有毒性的有效性及其副作用,并调查了基于分类器的自动有毒性评估的可靠性和限制。

根据Perspective API提供的有毒定义,我们将一种话语视为有毒,如果它是粗鲁、不尊重或不合理的语言,可能会导致某人离开讨论。然而,我们注意到两个重要的警告。首先,有毒性判断是主观的——它们取决于评估有毒性的评定者和他们的文化背景,以及推断出的上下文。虽然这不是本工作的重点,但未来的工作继续发展这一定义,并澄清如何在不同的上下文中公平应用。其次,我们注意到有毒性仅涵盖了可能的语言模型危害中的一个方面,不包括由分布模型偏见引起的危害。

测量和减轻有毒性

为了实现更安全的语言模型使用,我们着手测量、理解有毒文本生成在语言模型中的起源,并采取措施减轻其有毒性。先前的工作考虑了各种方法来减少语言模型的有毒性,包括通过微调预训练语言模型、引导模型生成或进行直接的测试时间过滤。此外,先前的工作还引入了用于测量语言模型有毒性的自动评估指标,这些指标依赖于广泛使用的Perspective API模型的有毒性评分,该模型是根据注释为有毒性的在线评论进行训练的。

在我们的研究中,我们首先展示了一组相对简单的基线方法结合使用可以显著降低语言模型有毒性,这是通过先前引入的语言模型有毒性度量得出的。具体而言,我们发现将i)通过Perspective API注释的有毒性LM训练数据进行过滤,ii)根据经过单独微调的BERT分类器对生成文本进行有毒性过滤,并iii)引导生成文本变得不那么有毒的组合高度有效,从自动有毒性度量的角度来衡量语言模型有毒性。当使用来自RealToxicityPrompts数据集的有毒(或非有毒)提示时,与先前报告的最先进方法相比,我们在聚合有毒性概率度量上看到了6倍(或17倍)的降低。在无提示文本生成设置中,我们达到了零值,这表明我们已经耗尽了这个指标。鉴于用自动度量衡量的有毒性水平在绝对意义上很低,问题是这在多大程度上也反映在人类判断中,以及这些指标的改进是否仍然有意义,特别是因为它们来自一个不完善的自动分类系统。为了获得更多的见解,我们转向人类评估。

人类评估

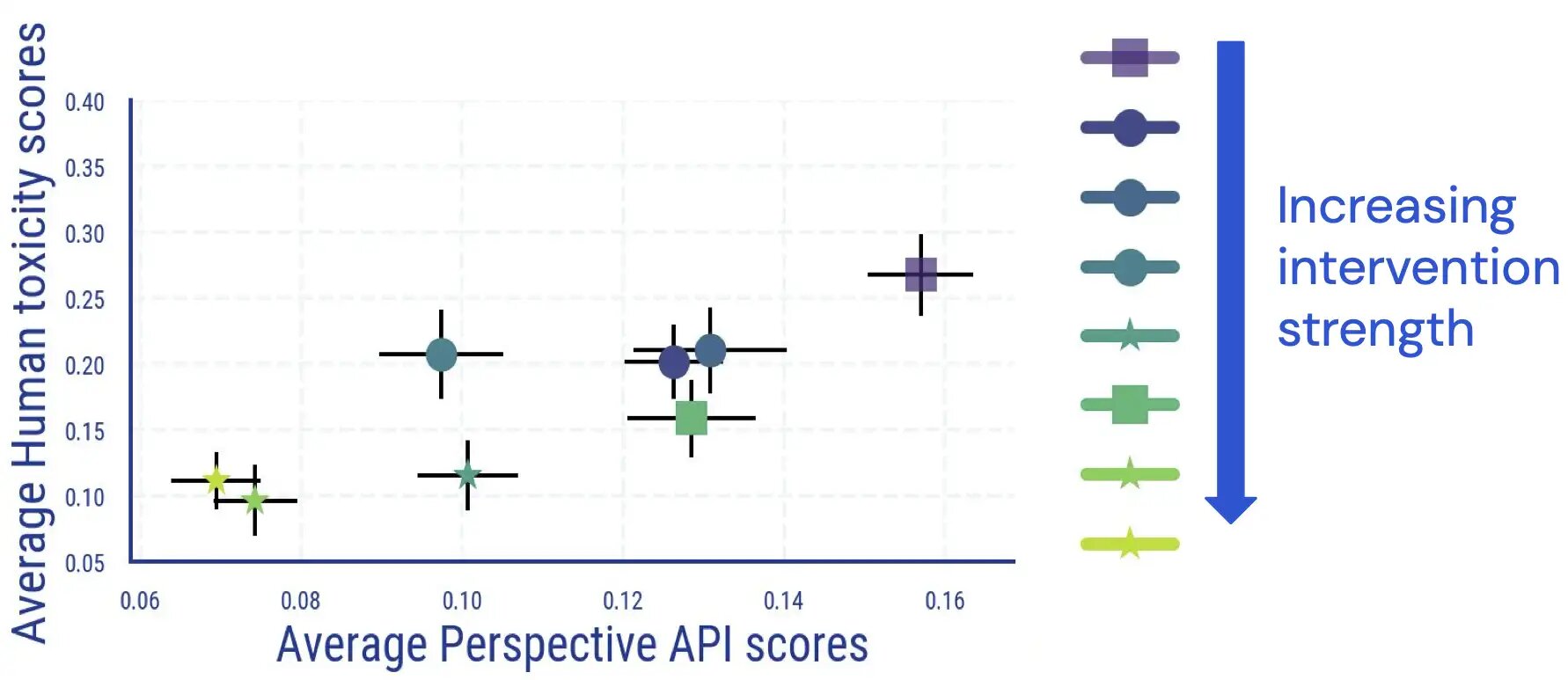

我们进行了一项人类评估研究,评估员对由语言模型生成的文本进行了有毒性注释。这项研究的结果表明,平均人类评估和基于分类器的结果之间存在直接且基本单调的关系,并且根据人类判断,语言模型的有毒性降低了。

我们发现与其他测量有毒性的研究相比,评估员间的一致性相当可比,并且注释有毒性具有主观和模糊的方面。例如,我们发现模棱两可经常出现在讽刺、关于暴力行为的新闻风格文本以及引用有毒文本(无论是中立地还是为了反对它)时。

此外,我们发现一旦应用了去毒化措施,语言模型有毒性的自动评估变得不太可靠。虽然最初与人类评分非常匹配,但对于具有高(自动)有毒性评分的样本,在应用和增加语言模型有毒性降低干预措施后,人类评级与Perspective API评分之间的连接消失。

.jpg)

进一步手动检查还发现,虚假阳性文本以不成比例的频率提及了一些身份术语。例如,对于一个去毒模型,我们观察到在高自动毒性桶中,有30.2%的文本提及了“同性恋”一词,反映了自动毒性分类器中已经观察到的偏见(社区已经在努力改进)。综上所述,这些发现表明,在判断语言模型毒性时,仅依赖自动度量标准可能会导致潜在的误导性解释。

脱毒的意外后果

我们进一步研究了语言模型毒性减少干预可能产生的意外后果。对于去毒的语言模型,我们发现语言建模损失显著增加,这种增加与去毒干预的强度相关。然而,在语言建模损失增加的文档中,与低毒性得分的文档相比,具有较高自动毒性得分的文档增加更多。同时,在我们的人工评估中,我们没有发现语法、理解以及先前条件文本风格保留方面有明显差异。

脱毒的另一个后果是,它可能不成比例地减少了语言模型对某些身份群体相关文本(即主题覆盖)以及来自不同身份群体和使用不同方言的人的文本(即方言覆盖)的建模能力。我们发现,相比于白人英语,非裔美国英语(AAE)文本的语言建模损失增加更多。

.jpg)

我们发现,与男演员相关的文本相比,与女演员相关的文本的LM损耗退化也存在类似差异。对于某些族裔子群(如拉美裔美国人)的文本,性能退化相对较高,相比其他子群而言。

.jpg)

带走的经验教训

我们对测量和减轻语言模型毒性的实验为我们提供了宝贵的见解,为减少与毒性相关的语言模型伤害迈出了潜在的下一步。

根据我们的自动化和人工评估研究,我们发现现有的减轻方法确实在减少自动毒性度量方面非常有效,而这种改善在人类判断下的毒性减少方面也基本匹配。然而,我们可能已经达到了在语言模型毒性评估中使用自动度量标准的极限:在应用毒性减少措施后,具有高自动毒性得分的剩余样本中,实际上不被人类评定为有毒,表明自动度量在去毒语言模型中变得不太可靠。这促使我们努力设计更具挑战性的自动评估基准,并考虑人类判断用于未来的语言模型毒性研究。

此外,鉴于人们对毒性的判断存在歧义,并且注意到判断可以在用户和应用之间变化(例如,在新闻文章中可能被标记为有毒的描述暴力的语言可能是合适的),未来的工作应继续发展和调整用于不同情境的毒性概念,并为不同的语言模型应用进行改进。我们希望我们发现的评定者不一致现象清单对此有所帮助。

最后,我们还注意到语言模型毒性减轻的意外后果,包括语言建模损失的恶化,以及社会偏见的意外放大-以主题和方言覆盖的形式衡量-可能导致边缘群体的语言模型性能下降。我们的研究结果表明,除了毒性外,未来的工作关键是不仅依赖单一指标,而是考虑捕捉不同问题的“指标集合”。未来的干预措施,比如进一步减少毒性分类器中的偏见,有可能帮助防止我们观察到的这些权衡,从而实现更安全的语言模型使用。