优化大数据工作流编排

介绍

在数据工程和分析的不断发展中,构建可扩展和自动化的流水线至关重要。

已经使用Airflow一段时间的Spark爱好者可能会想知道:

如何使用Airflow在远程集群上执行Spark作业?

如何使用AWS EMR和Airflow自动化Spark流水线?

在本教程中,我们将通过展示以下内容来集成这两个技术:

- 从Airflow UI中配置和获取必要的参数。

- 创建辅助函数来自动生成首选的

spark-submit命令。 - 使用Airflow的

EmrAddStepsOperator()方法构建一个任务,提交并执行一个PySpark作业到EMR。 - 使用Airflow的

EmrStepSensor()方法来监视脚本的执行。

本教程中使用的代码可以在GitHub上找到。

先决条件

- 在同一个地区(在本例中为

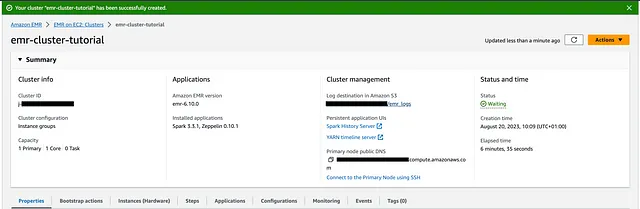

eu-north-1)上配置了一个S3存储桶和EMR集群的AWS账户。EMR集群应该是可用的并处于WAITING状态。在我们的情况下,它被命名为emr-cluster-tutorial:

- 在

S3存储桶的src/balances文件夹下已经存在一些模拟的balances数据。可以使用数据生成脚本生成并写入到该位置。 - 所需的

JAR应该已经从Maven下载并在S3存储桶中可用。 - 在本地机器上安装并运行了Docker,并分配了4-6 GB的内存。

架构

目标是将一些模拟数据以parquet格式写入到一个S3存储桶,并构建一个DAG:

- 从Airflow UI中获取所需的配置;

- 将一个

pyspark脚本上传到同一个S3存储桶;