语言模型(LMs)最近取得了许多成功,这是在“静态范式”内实现的,重点是提高在没有考虑数据时间因素的基准测试上的性能。例如,在训练期间模型可以学习的事件上回答问题,或者在与训练数据相同时间段的文本上进行评估。然而,我们的语言和知识是动态的,不断发展的。因此,为了使下一次性能的飞跃更加现实,确保当遇到新的和未知的数据时,问答模型具有灵活性和鲁棒性是至关重要的。

在2021年,我们发布了《Mind the Gap:评估神经语言模型中的时间泛化》和针对WMT和arXiv的动态语言模型基准,以促进考虑时间动态的语言模型评估。在本文中,我们强调了当前最先进的大型LMs在时间泛化方面面临的问题,并发现了知识密集型标记对性能的显著影响。

今天,我们发布了两篇论文和一个新的基准,进一步推进了这个领域的研究。在《StreamingQA:适应问题回答模型中的新知识随时间变化的基准》中,我们研究了在我们新提出的基准StreamingQA上的问题回答的下游任务:我们想要了解参数化和检索增强的半参数化问题回答模型如何适应新信息,以回答关于新事件的问题。在《通过少样本提示增强开放域问题回答的互联网增强语言模型》中,我们探索了将少样本提示的大型语言模型与Google搜索作为检索组件相结合的能力。通过这样做,我们旨在提高模型的事实性,同时确保它可以访问最新的信息,以回答各种问题。

StreamingQA:适应问题回答模型中的新知识随时间变化的基准

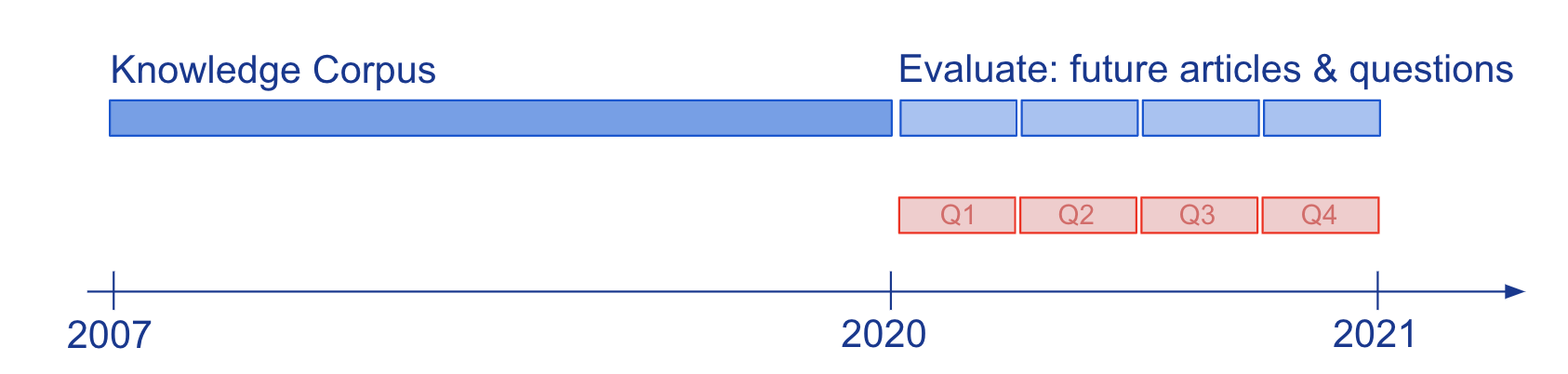

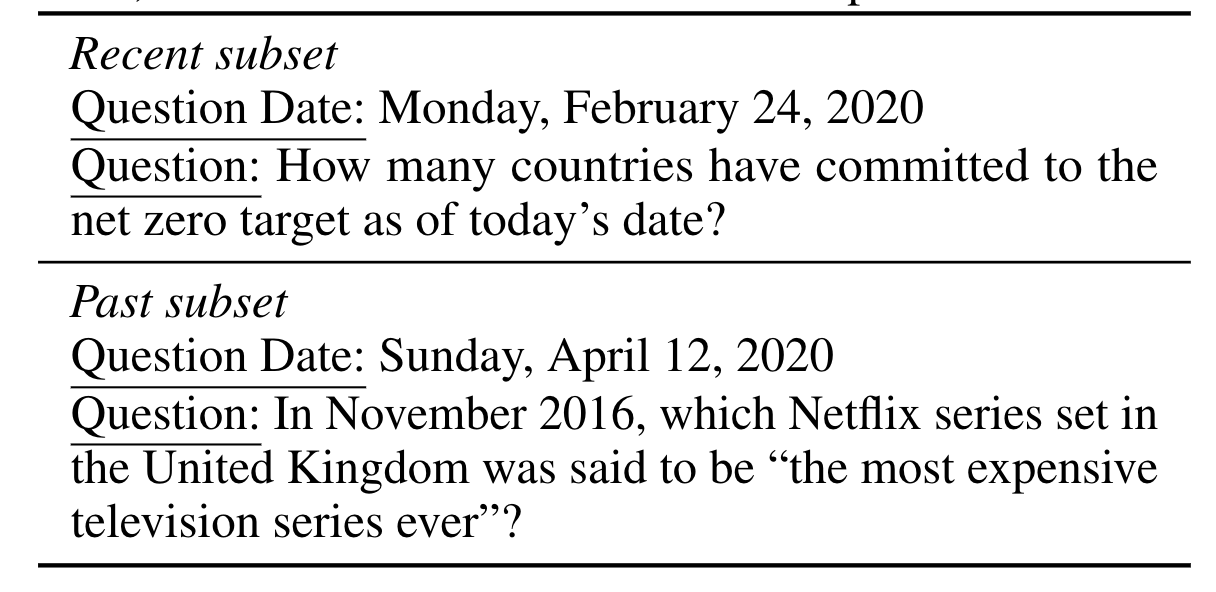

通过问题回答(QA)评估模型的知识和语言理解通常是在静态的知识快照上进行的,例如维基百科。为了研究半参数化QA模型及其基础参数化LM如何适应不断发展的知识,我们构建了新的大规模基准StreamingQA,其中包含在给定日期提出的人工编写和自动生成的问题,这些问题可以从14年的时间戳新闻文章中回答(参见图2)。我们展示了参数化模型可以进行更新而无需完全重新训练,同时避免了灾难性遗忘。对于半参数化模型,将新文章添加到搜索空间中可以实现快速适应,然而,具有过时基础LM的模型表现不如具有重新训练LM的模型。

通过少样本提示增强互联网语言模型以进行开放域问题回答

我们旨在利用大规模语言模型提供的独特少样本能力来克服它们在基于事实和最新信息的关联方面的挑战。受半参数化LM的启发,该模型将决策基于从互联网上使用Google搜索返回的信息,我们使用少样本提示来学习将LM条件化于这些信息上,Google搜索是一个广泛而不断更新的知识源。我们的方法不涉及微调或学习额外的参数,因此适用于几乎任何语言模型。事实上,我们发现基于网络条件化的LM在开放域问题回答中超过了相似或更大模型大小的闭书模型的性能。