在生物学和人工智能领域,先天性的问题对于人类智能的未来至关重要。这篇两部分的深度探讨关于这个概念及其应用可能有助于澄清问题。

作者:Vincent J. Carchidi

(这是关于生物学和人工智能中先天性的两部分文章的续篇,第一部分可以在此找到。)

人工智能中的先天性

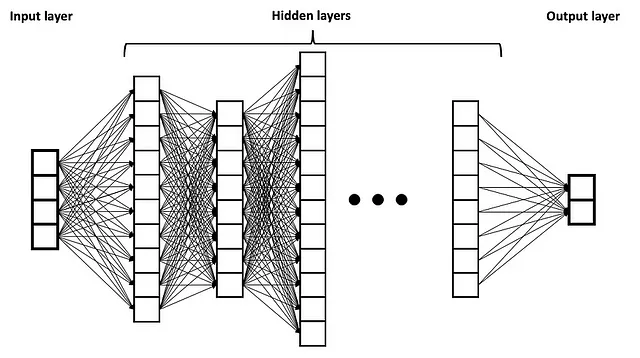

深度学习革命伴随着人工智能与人类思维研究之间关系的转变。人工神经网络(ANNs)最初受到哺乳动物大脑中神经元之间的大量互联的松散启发。虽然面向广大观众的典型ANN示例是一个简单的前馈网络,其中有一个输入层、中间的隐藏层,然后是一个只有单向信息流动的输出层,但是拥有许多隐藏层的深度神经网络(DNNs)比其较浅的前任更具“内部异质性”(如下图所示)。

来源:维基共享资源,根据知识共享署名-相同方式共享4.0国际许可证。

然而,随着时间的推移,流行的人工智能讨论中出现了一个观念的逆转:人类大脑实际上与DNNs类似。从生物启发ANNs到生物大脑与DNNs处于同一水平并不仅仅是语言上的巧合,它既表明了人类思维中先天性的复杂理解,也表明了研究人工智能的正确跨学科方法。尽管深度学习革命具有其优点,但它也带来了降低对于理解智能唯一类别的严谨标准的趋势,即生物智能(Peter Voss最近抱怨的认知框架的缺失,这是通往人工通用智能(AGI)之路上的障碍)。

因此,不足为奇的是,像Gary Marcus这样的人物对于似乎抵制构建高度结构化系统、具有一定领域特定知识水平的机器学习研究人员表达了反复的失望。毕竟,Gary Marcus本身就是一位认知心理学家。也不足为奇的是,2017年Gary Marcus和Yann LeCun之间的公开辩论集中在一个问题上:“人工智能是否需要更多的先天机制?”

但这是在大型语言模型(LLM)时代之前。最近,2022年6月,Yann LeCun和Jacob Browning在争论中声称,通过人工智能,我们可以学到关于人类智能的新东西,他们声称LLMs已经学会操纵符号,“展示了一定程度的常识推理、组合性、多语言能力、一些逻辑和数学能力,甚至具备模仿死者的可怕能力。”问题是,“它们并不总是可靠地做到。”LeCun此后表达了对LLMs在追求AGI方面的悲观态度,但至少目前还没有明确地将其与对深度学习本身的悲观态度联系起来(无论对于LeCun的立场有多少困惑,与Marcus相反,前者仍然是一位实证主义者,尽管不是激进的实证主义者)。

然而,这种不可靠性对于其他人来说并不是障碍,他们倾向于认为LLMs可以对人类先天性的辩论做出贡献。语言学家Steven Piantadosi撰写了一篇广泛传播的文章,认为LLMs的成功“削弱了生成语言学提出的关于语言先天性的几乎所有强有力的主张”(第1页)。他将LLMs描述为“自动科学家或自动语言学家,他们也在相对不受限制的空间中工作,寻找能够以最简洁的方式预测观察数据的理论”(第19页)。

如果Piantadosi的论点至少部分正确,并且LLMs在某种程度上解释了人类如何习得自然语言,那么它将直接关系到生物和人工智能中先天性的必要性(或在这种情况下的不必要性)。当然,其他人对这个论点提出了质疑。语言学家Roni Katzir在自己测试GPT-4时发现该系统未能证明它在人类语言使用的既定约束方面是“合适偏向”的(第2页),并认为它们不仅不模拟人类语言认知,而是模拟语言文本。他认为,期望LLMs解释人类语言习得是奇怪的,因为它们的设计背后有不同的目的。研究人员Jon Rawski和Lucie Baumont直接指出Piantadosi的论点是谬误的,此外,他们强调了对解释能力的优先考虑而不是预测能力。

游戏AI作为人工通用智能的窗口

在很多方面,对比于人类的AI天生与否的辩论是一种怪异的现象。虽然机器学习往往试图最小化系统成功所需的天生组件数量,但这种辩论假设深度学习时代的成功是一种经验主义的连续。天生对于追求AGI而言在领域中是重要的。问题在于,当天生成为成功系统的因素时,往往会被淡化或忽视,即使是那些最积极推动这些进展的人也未能意识到其概念上的重要性。

关于游戏AI,这一点体现得最明显。AlphaGo Zero的研究论文中最令人困惑的事情之一是作者坚称该系统从“白板状态”开始学习如何下围棋。当然,AlphaGo Zero通过自我对弈强化学习在围棋中取得了超人类的表现,但正是Gary Marcus在很大程度上解释了AlphaGo Zero在学习围棋之前拥有多少内置的东西,即在什么都不了解围棋的情况下。

实际上,AlphaGo Zero使用的领域知识如下,直接摘自2017年的研究论文(第360页):

(1)蒙特卡洛树搜索(MCTS)期间使用的游戏规则的完全知识。

(2)MCTS模拟和自我对弈训练中使用的Tromp-Taylor计分方法——这是一份由10条逻辑规则组成的清单,规定了几个游戏特征,包括19×19的棋盘、黑白棋子、什么是“清除”一种颜色等。

(3)描述位置的输入特征结构化为一个19×19的图像;“也就是说,神经网络架构与棋盘的网格结构相匹配。”

(4)“围棋规则在旋转和反射下是不变的”——这种奇怪的措辞意味着两件事:训练期间的数据集通过增加旋转和反射的位置进行了增强,“在MCTS期间对位置进行了随机旋转或反射”,并使用了特定的算法进行采样。

就像一个人不能没有从一开始就内在地建立的独特的道德能力来界定世界一样,AlphaGo Zero在没有这种内在赋予的情况下,甚至无法识别围棋棋盘、棋子、棋盘或棋子的移动以及游戏规则。正如Marcus所指出的,MCTS装置并不是从数据中学习的,而是从一开始就进行的编程,包括选择包括了哪些增强,“是基于人类的知识而不是学习的”(第8页)。

将AlphaGo Zero描述为一张白板,因为它是通过自我对弈强化学习进行训练的,这是极其误导人的,并不是经验主义的胜利。正如Marcus正确解释的那样,这是一个“展示…一开始就内置正确要素的力量…卷积是使深度学习领域取得成功的先验条件;树搜索对于游戏起着至关重要的作用。AlphaZero将这两者结合起来”(第8-9页)。实际上,就像人类的道德判断是通过从专门从道德直觉中汲取的系统主要从一个系统与其他系统的接口中进行结构化过程一样,AlphaGo Zero不能简单地通过放弃其内在组件之一来处理围棋的复杂性。正如Artur d’Avila Garcez和Luís C. Lamb所指出的,MCTS是一个符号问题解决器,使其与AlphaGo Zero的神经网络的耦合成为神经符号AI的一个元素。

正是AlphaGo Zero天生的这种组合性方面使其如此令人印象深刻,我们应该在训练之前欣赏其内置的知识以及训练本身的奇迹。

独特的、组合性的设计选择常常是许多游戏AI最大成功的原因,尽管强化学习和自我对弈等技术在评论中被夸大,却以这些选择为代价。这在Meta的“Cicero”中表现得尤为明显,这是一个在ChatGPT发布前八天发布的外交游戏代理。

Cicero是第一个在外交游戏中达到人类水平(而非超人类)表现的代理,它展示了这些组合元素的两个方面:首先,在高层次上,系统在游戏过程中结合了战略推理和自然语言交流。其次,系统的架构依赖于从战略推理、自然语言处理和博弈论等领域汲取的研究和技术的组合。正如Gary Marcus和Ernest Davis所描述的,结果是“一组高度复杂、相互作用的算法集合”。

要在外交中取得成功,玩家必须进行战略推理,以争取在地图上获得大部分供应中心。这个游戏要求玩家在每一步中运用战术技巧,为了总体目标而服务,与其他游戏如国际象棋、围棋和扑克类似,这些游戏都已经在某种程度上被人工智能掌握。与其他游戏不同的是,外交游戏中的玩家花费大量时间进行彼此之间的开放式文本或口头对话。

听起来相当简单,对吧?玩家之间进行谈判以确保有利的结果-很容易。但事实并非如此。记住,我们往往会低估我们道德判断所面临的情况的复杂性,以及这些判断本身的复杂性。如果我们不从远处看,外交可能会以类似的方式具有欺骗性。将代理人的战略推理能力与自然语言交流相结合是极其复杂的。

Cicero的体系结构可以分为一个规划引擎和一个对话代理人。规划引擎负责战略推理,而对话代理人处理自然语言交流。关键是,这两个部分通过一个高度特定的机制(“对话条件动作模型”)进行中介,并且对话代理人由规划引擎控制。这种高级结构确保规划引擎可以生成意图,然后用这些意图来构建代理人的目标。然后将这些信息输入到对话代理人中,以便Cicero与其他玩家之间的消息生成与代理人的战略目标保持一致。虽然Cicero有时会自相矛盾,但其设计者报告称,在匿名的多级锦标赛中没有人类将其视为人工智能,突显了该系统的人类成功。

较低级的结构也具有自己的独特性。有人可能会怀疑,在AlphaGo Zero通过自我对弈取得成功之后,外交代理是否也应该采用这种技术进行训练。但是,Cicero之前的研究发现,训练不依赖人类数据的外交代理会导致对人类的相对糟糕的表现。

蒙特卡洛树搜索算法在这里也不是特别有用。虽然在Cicero之前,MCTS已经在外交中进行过测试(据我所知,主要是在游戏的战略方面,而不是谈判方面),但围棋和外交之间的差异使得它的效果较差。围棋是一种异步游戏,玩家依次进行回合,因此在下一个玩家行动时,所有相关信息都传递到棋盘上。外交是同时进行的-玩家进行谈判,然后私下输入他们的行动,这些行动将同时向所有人公开。MCTS无法很好地应对这种结构。

这里是Meta AI团队所做的:在外交AI的先前研究基础上,他们构建了一个名为“piKL”(可接受地发音为“pickle”)的算法。piKL的设计是为了在搜索新策略和模仿人类之间进行“插值”。这个算法是规划引擎的基础。与为扑克玩家设计的代理程序Libratus的研究相呼应,Meta AI报告称,“piKL将外交的每一回合视为一个子游戏…”

此外,对话代理人的基础是一个生成性的大型语言模型。这个语言模型在现有游戏对话上进行了微调。但是,语言模型与外交世界的上下文脱节,因此生成的输出与代理人的战略目标不一致(除了容易被人类操纵)。为了解决这个问题,一些人类训练数据中的消息被标记为建议行动-这些行动代表玩家的意图。语言模型在这些意图上进行了调整。

我们可以开始看到这些如何结合在一起。在游戏过程中,规划引擎选择相关的意图来控制语言模型。这种控制是建立在对系统的真实行动和对通信接收者(系统为每个玩家建模行动)的互惠行动的基础上的。

影响

Cicero是一个工程上的壮举。它也是一个最引人注目的例子,证明了AI系统在具有丰富、高度结构化的领域知识的情况下实现了与人类相似的特点。这些内部组件在战略推理和自然语言交流的一致性上相对有效地进行接口。马库斯和戴维斯是为数不多的几个立即认识到这个系统在外交游戏之外的重要性的人之一:“如果Cicero是一个指南,那么机器学习可能最终证明,如果将其嵌入高度结构化的系统中,带有相当多的内在的、有时是神经符号的机器,它可能更有价值。”

然而,许多人认为这种观点忽视了问题的关键所在:是的,生物智能可能具有各种内在特征,但人工智能系统可能并不需要它们。思路是,执行智能行为的方式可能不仅限于人类的方式。只需看看AlphaGo Zero:这个系统的内部组件相对简单,但它在围棋方面比任何人类都要出色。既然这个系统已经做得这么好,为什么还要专注于在Cicero中构建更多内在的事物呢?而在这个过程中,为什么不试图将Cicero中运作的移动部件的数量最小化呢?

这个假设对话者为了琐事忽略了大局。正如马库斯在他2018年的论文中解释的那样:“虽然人类可以在没有特定内在表征特征的情况下学习许多游戏,但每个[AlphaGo Zero]的实现都天生具有特定于游戏的特征,将系统锁定在一个特定游戏的一个特定实现上,聚焦在一个特定问题上。人类在解决问题的方式上更加灵活”(第9页)。

从“狭义”AI到“通用”AI的飞跃与内在性问题直接相关。生物智能显示了为什么:虽然没有人类个体能在AlphaGo Zero的水平上玩围棋(假设没有类似KataGo对Kellin Pelrine的复制与AlphaGo Zero),但这个系统在没有高度特定的内在结构的情况下无法达到这一点,就像人类道德判断之所以具有非常具体的特征一样,是由于我们的内在结构。

从生物学到人工智能的洞察更深入。游戏AI通常以这样的方式引人注目,即它们允许研究人员在具有明确定义的目标(即,胜利的明确条件)以及稳定的约束条件(即游戏规则、棋盘、玩家数量等)的环境中测试技术。这些游戏是对人类认知能力的孤立利用,包括战术熟练度、战略推理、自然语言交流、欺骗、合作与协作、诚实与不诚实等。

问题在于AlphaGo Zero、Cicero和其他游戏AI并没有像我们玩围棋、外交或任何其他策略游戏时那样。正如对话者指出的,它们找到了不同的成功方法:AlphaGo Zero可以通过数百万次与自己对弈,并使用专门为围棋设计的精心增强的搜索算法;Cicero可以在没有被背叛的感觉误导其行动的情况下进行谈判,并具有实质性的“元游戏”知识。但是AlphaGo Zero无法在围棋之外进行战略规划,甚至无法识别不符合其天生编程要求的围棋棋盘;Cicero无法在外交之外进行谈判,因为它不知道如何阅读意图,而只是优化各方都接受的协议。

这就是问题所在:当人类在围棋中制定战略时,他们可以在任何其他游戏或情境中利用这种能力;当人类在外交中读取意图时,他们可以在游戏之外的任何地方以灵活和稳健的方式使用同样的认知能力,无论是在真正的面对面外交还是随意的对话中。

核心观点是:

AI在成功地超越人类的游戏中采用的“不同”方式,同时仍然局限于这些领域,是由于其内在结构的强大。从狭义到通用AI的飞跃将需要一种与深度学习的成功要素相结合的新型内在结构。

结论

在我的经验中,内在性的概念令人不安。但有趣的是,人们对人类的手臂、腿、循环系统或脊髓等内在性并不感到困扰 – 它们并非如此。相反,人们往往对心智的高阶能力具有内在性感到困扰 – 例如道德价值观、语言、音乐感等。

这种双重标准已被认为是认知和神经科学中的一个潜在障碍,一种隐含的偏见,我认为这可能是对AI内在性抵制的部分原因。罗德尼·布鲁克斯(Rodney Brooks)在推特上提到的“对端到端学习的痴迷”可能部分是这种奇怪的双重标准进入AI领域的结果,而不是该领域独有的。

但仅仅识别问题将提高在构建类似人类的AI或AGI方面的工程与科学之间整洁分离的难度。那种说“让我们看看什么有效,什么无效”的心态具有巨大的创造优势,但仅靠这个是无法实现类人AI的。如上所示,类人AI可能是一系列结构良好的研究问题,不能对人类或动物的生物学和认知心理做出隐含的假设。

参考文献:

[1] B. Alloui-Cros,精通笔和剑?Cicero在外交游戏中的表现(2023),Substack

[2] A. Bakhtin等,从零开始的无新闻外交(2021),ArXiv

[3] N. Brown和T. Sandholm,《超人级AI对决无限制扑克(2017年),科学》

[4] V.J. Carchidi,《潜艇能游泳吗?(2022年),AI与社会》

[5] N. Chomsky,《语言和心智研究中的自然主义和二元论(1994年),国际哲学研究杂志》

[6] D. Silver等,《无需人类知识掌握围棋(2017年),自然》

[7] G. Dupre,《深度学习对理论语言学的贡献是什么?(2021年),思维与机器》

[8] A. Garcez和L. Lamb,《神经符号AI:第三波(2023年),人工智能评论》

[9] M. Holmes,《面对面外交(2018年),剑桥大学出版社》

[10] A.P. Jacob等,《用KL正则化搜索建模强大和类似人类的游戏玩法(2021年),ArXiv》

[11] R. Katzir,《为什么大型语言模型对人类语言认知的理论很差?回复Piantadosi(2023年),LingBuzz》

[12] G. Marcus和E. Davis,《Meta AI的外交胜利者Cicero对AI意味着什么?(2022年),通信ACM》

[13] G. Marcus,《天生、AlphaZero和人工智能,ArXiv

[14] Meta Fundamental AI Research Diplomacy Team(FAIR)等,《结合语言模型和战略推理在外交游戏中达到人类水平的玩法(2022年),科学》

[15] S. Piantadosi,《现代语言模型驳斥了Chomsky关于语言的方法(2023年),LingBuzz》

[16] J. Rawski和L. Baumont,《现代语言模型并未驳斥任何东西(2023年),LingBuzz》

[17] A. Theodoridis和G. Chalkiadakis,《蒙特卡洛树搜索在外交游戏中的应用(2020年),第11届希腊人工智能会议》

[18] S. Ullman,《利用神经科学发展人工智能(2019年),科学》