欢迎来到关于V-Net的指南,它是著名的U-Net的3D图像分割表亲。你将全面了解它!

欢迎踏上深度学习架构的激动人心之旅!你可能已经熟悉U-Net,这是计算机视觉领域的一项重大创新,极大地改变了图像分割的格局。

今天,让我们把焦点转向U-Net的大哥,即V-Net。

由研究人员Fausto Milletari、Nassir Navab和Seyed-Ahmad Ahmadi发表的论文《VNet:用于体积医学图像分割的完全卷积神经网络》介绍了一种突破性的3D图像分析方法。

本文将带您走进这篇开创性的论文,揭示其独特的贡献和架构进展。无论您是经验丰富的数据科学家、初学者的人工智能爱好者,还是对最新技术趋势感兴趣的人,这里都有适合您的内容!

简要回顾U-Net

在深入探讨V-Net之前,让我们花点时间欣赏一下它的架构灵感——U-Net。如果这是您第一次接触U-Net,不用担心,我为您准备了一份关于U-Net架构的简明教程。它非常简洁,您将在不到五分钟内理解其概念!

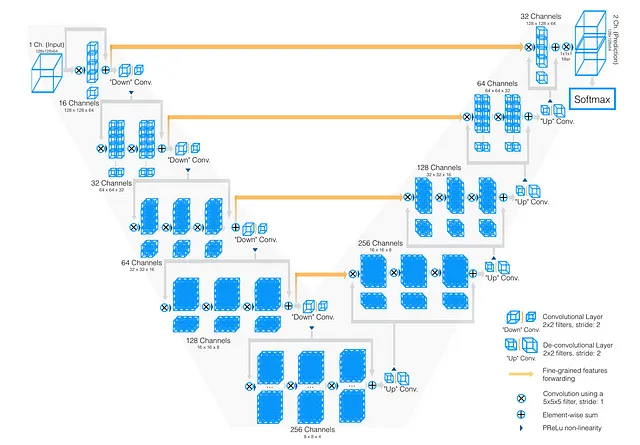

以下是U-Net的简要概述:

U-Net以其对称的结构而闻名,呈现出“U”的形状。该架构由两个不同的路径组成:

- 收缩路径(左侧):在这里,我们逐渐降低图像的分辨率,同时增加滤波器的数量。

- 扩展路径(右侧):这条路径是收缩路径的镜像。我们逐渐减少滤波器的数量,同时增加分辨率,直到与原始图像大小一致。

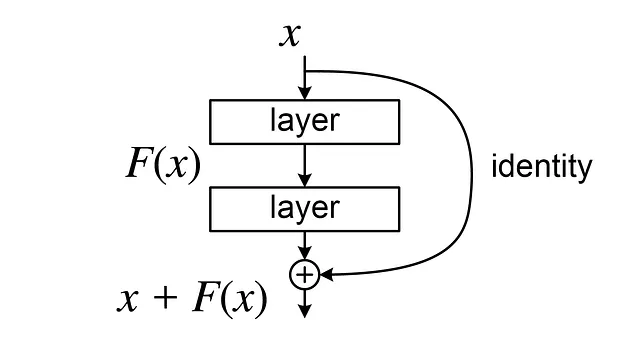

U-Net的美妙之处在于其创新性地使用了“残差连接”或“跳跃连接”。这些连接将收缩路径和扩展路径中的相应层连接在一起,使网络能够保留在收缩过程中通常丢失的高分辨率细节。

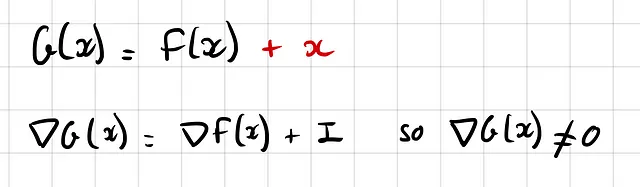

为什么这很重要?因为它在反向传播过程中减轻了梯度流动,特别是在早期层次。本质上,我们避免了梯度消失的风险——这是一种常见问题,其中梯度接近零,阻碍了学习过程:

现在,在理解U-Net的基础上,让我们进入V-Net的世界。从本质上讲,V-Net与其兄弟U-Net共享类似的编码器-解码器哲学。但正如您很快会发现的,它具有自己独特的特点,使其与U-Net区别开来。

V-Net与U-Net的区别在哪里?

让我们开始吧!

区别1:使用3D卷积而不是2D卷积

第一个区别是显而易见的。虽然U-Net专为2D图像分割而设计,但医学图像通常需要3D视角(如体积脑部扫描、CT扫描等)。

这就是V-Net的用武之地。V-Net中的“V”代表“体积”,这种维度转换需要用3D卷积替代2D卷积。

区别2:激活函数,使用PReLU而不是ReLU

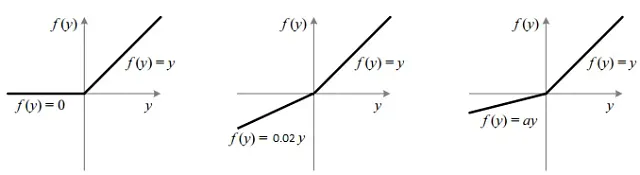

深度学习领域对ReLU函数倾心,因为它简单而高效。与sigmoid或tanh等其他函数相比,ReLU是“非饱和”的,意味着它减少了梯度消失的问题。

但是ReLU并不完美。它以“Dying ReLU问题”而声名狼藉,其中许多神经元始终输出零,成为“死神经元”。为了解决这个问题,引入了LeakyReLU,它在零的左侧具有小但非零的斜率。

进一步推理,V-Net利用了参数化ReLU(PReLU)。与硬编码LeakyReLU的斜率相比,为什么不让网络学习它呢?

毕竟,这是深度学习的核心理念,我们希望尽可能少地引入归纳偏见,让模型自己学习一切,假设我们有足够的数据。

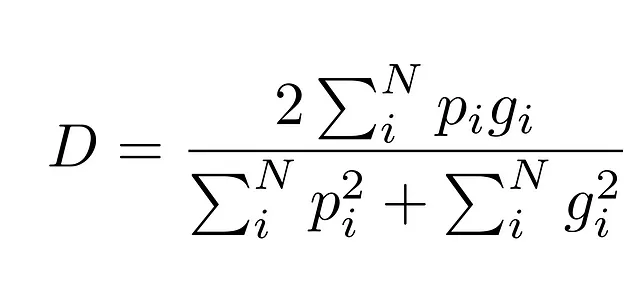

区别3:基于Dice分数的不同损失函数

现在,我们来到了V-Net可能最有影响力的贡献——损失函数的改变。与U-Net的交叉熵损失函数不同,V-Net使用了Dice损失函数。

但是,这个函数的主要问题是它对不平衡类别处理不好。在医学图像中,这个问题非常常见,因为大多数情况下,背景比感兴趣区域更常见。

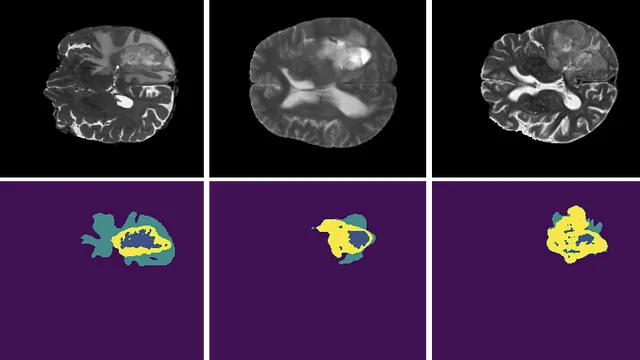

例如,考虑这张图片:

因此,一些模型可能“懒惰”地预测背景出现在任何地方,因为它们仍然会得到一个较小的损失。

因此,V-Net使用了一种更有效的损失函数:Dice系数。

它之所以更好,是因为它以“比例”的方式度量了预测区域与真实区域的重叠,因此考虑了类别的大小。

即使背景几乎无处不在,Dice分数仍然度量了预测与真实值之间的重叠程度,因此我们仍然可以得到一个介于0和1之间的数字,即使该类别占主导地位。

我说这可能是文章的主要贡献,是因为从2D到3D卷积是处理3D图像的一个非常自然的想法。然而,这个损失函数在图像分割任务中已经被广泛采用。

在实践中,混合方法通常被证明是有效的,结合交叉熵损失和Dice损失来发挥它们的优势。

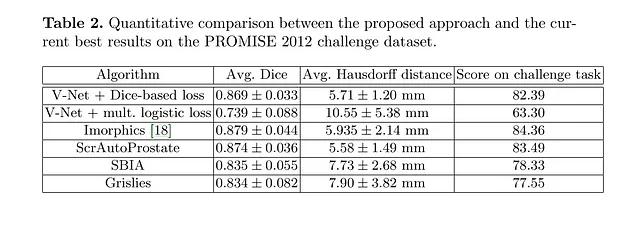

V-Net的性能

所以,我们已经了解了V-Net的独特之处,但你可能会想:“所有这些理论都很好,但V-Net在实践中真的有效吗?”好吧,让我们来测试一下V-Net!

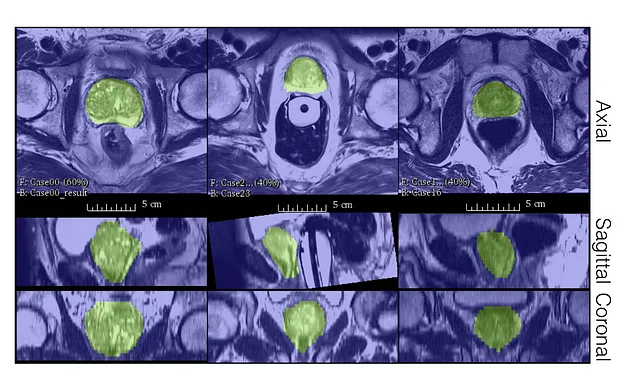

作者们在PROMISE12数据集上评估了V-Net的性能。

PROMISE12数据集是为MICCAI 2012年前列腺分割挑战赛提供的。

V-Net在50个磁共振(MR)图像上进行了训练,这并不多!

正如我们所见,即使标签很少,V-Net仍能产生良好的定性分割并获得非常好的Dice分数。

V-Net的主要限制

的确,V-Net在图像分割领域,尤其是医学影像方面,树立了新的标杆。然而,每一项创新都有改进的空间。在这里,我们将讨论一些V-Net可以改进的突出领域:

限制1:模型的大小

从2D到3D的转变导致内存消耗显著增加。这种增加的连锁效应有多重:

- 模型需要大量的内存空间。

- 它严重限制了批量大小(将多个3D张量加载到GPU内存中变得具有挑战性)。

- 医学影像数据稀疏且标记成本高,这使得很难适应具有如此多参数的模型。

限制2:不使用无监督学习或自监督学习

- V-Net仅在监督学习环境中运行,忽视了无监督学习的潜力。在一个未标记扫描远远超过注释扫描的领域中,整合无监督学习可能会改变游戏规则。

限制3:没有不确定性估计

- V-Net不会估计不确定性,这意味着它无法评估对其预测的自信程度。这是贝叶斯深度学习优势的领域。(请参考这篇文章,了解贝叶斯深度学习的简介)。

限制4:缺乏鲁棒性

- 卷积神经网络(CNN)在传统上在泛化方面存在困难。它们对于对比度变化、多模态分布或不同分辨率等变化不具有鲁棒性。这是V-Net可以改进的另一个领域。

结论

V-Net,作为U-Net的强大但鲜为人知的对应物,在计算机视觉,尤其是图像分割方面引起了革命。它从2D到3D图像的转变以及Dice系数的引入,现在已成为一种无处不在的工具,为该领域树立了新的标准。

尽管有其局限性,但对于从事3D图像分割任务的任何人来说,V-Net应该成为首选模型。为了进一步改进,探索无监督学习和整合注意力机制似乎是有前途的方向。

无论您有任何反馈、想法要分享、想与我合作还是只是想打个招呼,请填写下面的表格,让我们开始交流。

说你好 🌿

请不要犹豫,留下一个掌声或者关注我以获取更多内容!

参考资料

- 为图像分割烹饪你的第一个U-Net

- 贝叶斯深度学习的简要介绍

- Milletari, F., Navab, N., & Ahmadi, S. A. (2016). V-Net: 用于体积医学图像分割的全卷积神经网络. 在3D视觉(3DV),2016年第四届国际会议上(pp. 565–571)。 IEEE.

- Ronneberger, O., Fischer, P., & Brox, T. (2015). U-Net: 生物医学图像分割的卷积网络. 在医学图像计算与计算辅助干预国际会议上(pp. 234–241)。 Springer, Cham.