2016年,我们推出了AlphaGo,这是第一个在古老的围棋游戏中击败人类的人工智能(AI)程序。两年后,它的后继者AlphaZero从零开始学习并掌握了围棋、国际象棋和将棋。如今,在《自然》杂志上发表的一篇论文中,我们描述了MuZero,这是在追求通用算法的过程中迈出的重要一步。由于其在未知环境中制定获胜策略的能力,MuZero能够掌握围棋、国际象棋、将棋和Atari,而无需告知规则。

多年来,研究人员一直在寻求既能学习解释环境的模型,又能利用该模型规划最佳行动方案的方法。到目前为止,大多数方法在Atari等领域的有效规划方面一直存在困难,因为这些领域的规则或动态通常是未知且复杂的。

MuZero于2019年的一篇初步论文中首次提出,通过学习只关注规划中最重要方面的模型来解决这个问题。通过将这个模型与AlphaZero强大的前瞻搜索树结合起来,MuZero在Atari基准测试中取得了新的最佳成绩,同时在围棋、国际象棋和将棋等经典规划挑战中与AlphaZero的性能相匹配。通过这样做,MuZero展示了强化学习算法能力的重大飞跃。

推广到未知模型

规划能力是人类智能的重要组成部分,它使我们能够解决问题并对未来做出决策。例如,如果我们看到乌云聚集,我们可能会预测会下雨,并决定在外出前带上一把伞。人类很快就能学会这种能力,并能够推广到新的场景,我们也希望我们的算法能够具备这种特性。

研究人员尝试通过使用两种主要方法来解决AI中的这个重大挑战:前瞻搜索或模型为基础的规划。

使用前瞻搜索的系统(如AlphaZero)在国际象棋、围棋和扑克等经典游戏中取得了显著的成功,但它们依赖于获得关于环境动态的知识,例如游戏规则或准确的模拟器。这使得将它们应用于通常复杂且难以简化为简单规则的混乱真实世界问题变得困难。

模型为基础的系统旨在通过学习一个环境动态的准确模型,然后利用该模型进行规划来解决这个问题。然而,模拟环境的各个方面的复杂性使得这些算法无法在视觉丰富的领域(如Atari)中竞争。到目前为止,在Atari上取得的最佳结果来自无模型系统,例如DQN、R2D2和Agent57。顾名思义,无模型算法不使用学习的模型,而是估计下一步的最佳行动。

MuZero采用了一种不同的方法来克服以前方法的局限性。MuZero不试图对整个环境建模,而只是对对于代理决策过程重要的方面进行建模。毕竟,知道伞能让你保持干燥比知道空气中雨滴的模式更有用。

具体而言,MuZero使用深度神经网络学习了环境的三个关键要素,这对于MuZero理解采取某种行动的后果并进行相应的规划已经足够:

- 价值:当前位置有多好?

- 策略:采取哪个行动最好?

- 奖励:上一次行动有多好?

这些都是通过深度神经网络学习的,对于MuZero理解采取某种行动会发生什么以及进行规划已经足够。

这种方法还具有另一个重要优势:MuZero可以反复使用其学习的模型来改进其规划,而无需从环境中收集新数据。例如,在Atari套件的测试中,这个变种被称为MuZero Reanalyze,并且90%的时间使用学习的模型来重新规划过去的事件。

MuZero性能

我们选择了四个不同的领域来测试MuZero的能力。围棋、国际象棋和将棋被用来评估其在具有挑战性的规划问题上的性能,而我们使用Atari套件作为更复杂视觉问题的基准。在所有情况下,MuZero在强化学习算法中树立了新的技术水平,在Atari套件上超过了所有先前的算法,并与AlphaZero在围棋、国际象棋和将棋上的超人类表现相匹配。

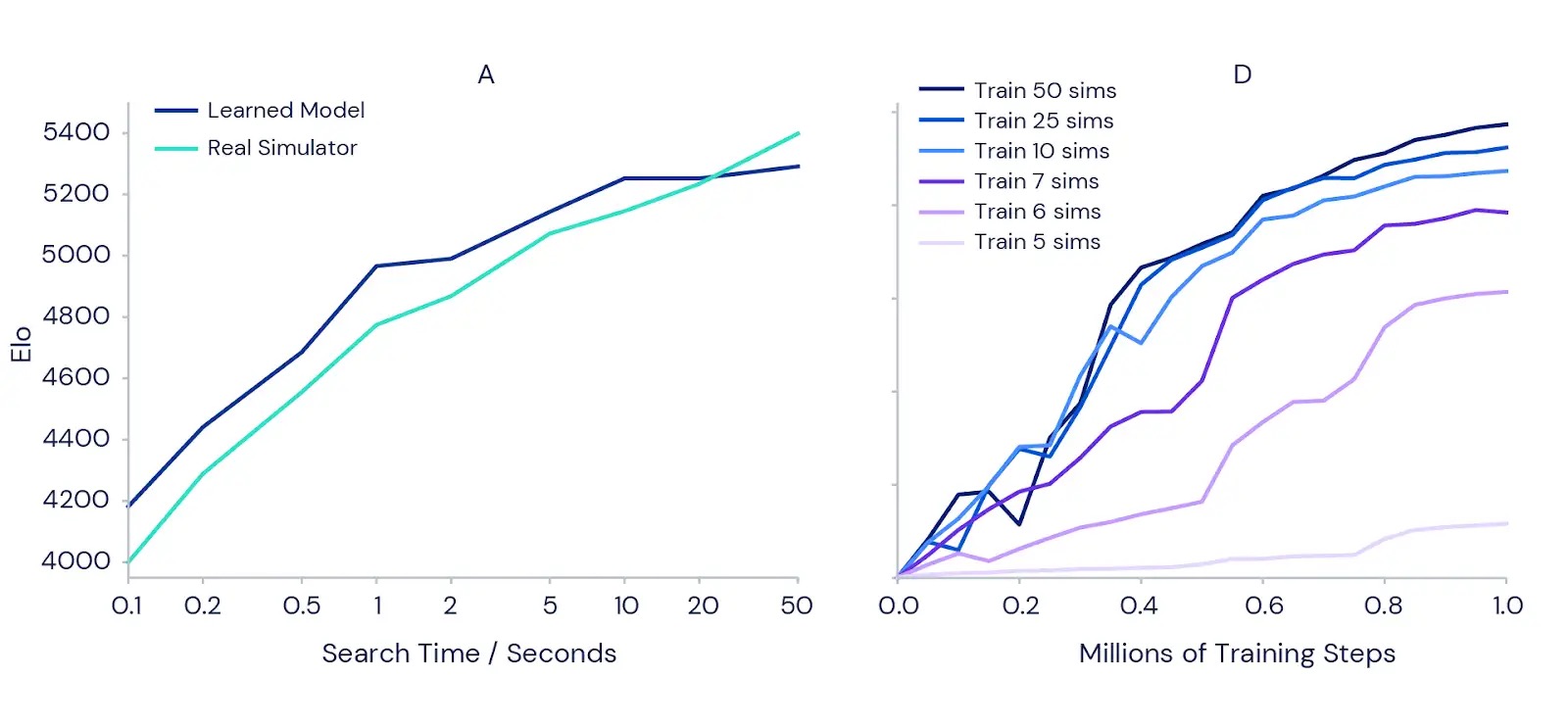

我们还详细测试了MuZero在使用其学习模型进行规划时的表现。我们从围棋中经典的精确定位规划挑战开始,其中一步棋可能意味着胜利和失败之间的差距。为了证实规划时间越长,结果越好的直觉,我们测量了完全训练的MuZero在给予每一步更多规划时间的情况下的增强程度(见下图左侧)。结果显示,当我们将每步的规划时间从0.1秒增加到50秒时,MuZero的对局实力增强了1000多个Elo(衡量棋手相对技能的指标)。这类似于强业余棋手和最强职业棋手之间的差距。

为了测试规划是否在整个训练过程中也带来了好处,我们在Atari游戏Ms Pac-Man(上方右侧的图表)上运行了一系列MuZero的实验。每个实验使用单独训练的MuZero实例,每次移动可以考虑不同数量的规划模拟,范围从五个到五十个。结果证实,增加每个移动的规划模拟次数可以让MuZero学习更快并获得更好的最终表现。

有趣的是,当MuZero每次移动只被允许考虑六个或七个模拟 – 这个数量对于覆盖Ms Pac-Man中所有可用动作来说太小了 – 它仍然能够表现出良好的性能。这表明MuZero能够在动作和情境之间进行泛化,不需要穷尽地搜索所有可能性才能有效学习。

新的视野

MuZero既能够学习环境的模型,又能够成功地利用它进行规划,这在强化学习和通用算法的追求方面是一项重大进展。它的前身AlphaZero已经在化学、量子物理学等复杂问题中得到了应用。MuZero强大的学习和规划算法背后的理念可能为解决机器人、工业系统和其他混乱的现实环境中的新挑战铺平道路,这些环境中的“游戏规则”是未知的。

相关链接:

- MuZero:Nature论文

- MuZero演讲:NeurIPS(9分钟,2019年12月),ICAPS(30分钟,2020年10月)

- MuZero:预印版 | NeurIPS 2019海报

- AlphaGo:博客 | 论文