该模型结合了语言理解和网络导航。

我最近开始了一个以人工智能为重点的教育性新闻简报,已经有超过160,000名订阅者。TheSequence是一个没有炒作、没有新闻等的面向机器学习的简报,阅读只需5分钟。其目标是让您及时了解机器学习项目、研究论文和概念。请通过以下方式订阅试试:

TheSequence | Jesus Rodriguez | Substack

这是了解机器学习、人工智能和数据发展的最佳来源…

thesequence.substack.com

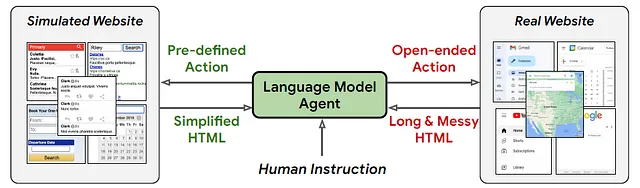

大型语言模型(LLMs)与网站之间的整合是可以开启新一波LLM驱动应用的领域之一。LLMs在各种自然语言任务中表现出了非凡的能力,从基本算术和逻辑推理到更复杂的挑战,如常识理解、问题回答甚至交互式决策。通过与网络导航相结合,可以实现非常强大的组合。最近,Google DeepMind发布了Web Agent,这是一种基于用户指令导航真实网站的LLM驱动自主智能体。

网页导航的实际实现带来了独特的挑战,包括:

(1)缺乏预定义的操作空间。

(2)与模拟器相比,HTML观察次数更多。

(3)LLMs缺乏HTML领域特定的知识。

这些障碍是由于现实世界网站的无限性和指令的复杂性而产生的,这使得事先定义适当的操作空间变得困难。尽管一些研究已经强调了指令微调或通过人类反馈进行强化学习以提高HTML理解和导航准确性的潜力,但LLM设计并不总是针对有效处理HTML文档进行优化。具体而言,大多数LLMs的上下文长度相对较短,无法处理实际网站中找到的平均标记长度,并且可能不采用处理结构化文档的关键技术。

进入WebAgent

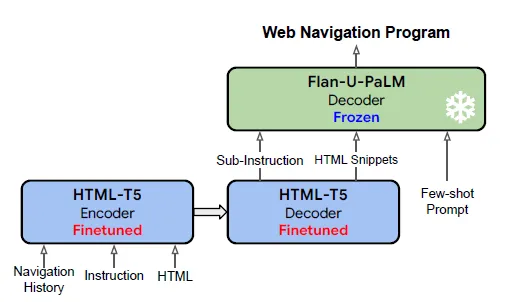

WebAgent通过为每个步骤规划子指令,根据这些子指令将长HTML页面总结为相关片段,并通过将子指令和HTML片段转化为可执行的Python代码来执行任务。为了构建WebAgent,Google DeepMind结合了两个LLMs:“Flan-U-PaLM”用于生成有基础的代码,“HTML-T5”是一个新引入的领域专家预训练语言模型,负责任务规划和有条件的HTML总结。HTML-T5采用编码器-解码器架构设计,通过利用局部和全局注意机制,出色地捕捉了冗长HTML页面的结构,并且它是自我监督预训练的,训练数据集是从CommonCrawl生成的大量HTML数据。

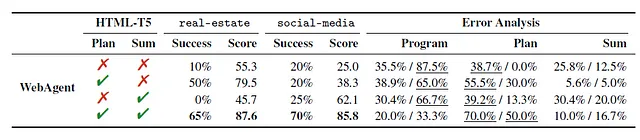

现有的LLM驱动智能体通常通过为每个角色提示不同的示例来处理决策任务。然而,对于更复杂的现实世界任务,这种方法存在不足。Google DeepMind的全面评估表明,WebAgent的综合方法,即集成插件语言模型,显著提高了HTML理解和转化的能力,从而实现更好的泛化。WebAgent在真实世界的网页导航中成功率提高了50%以上,详细分析揭示了任务规划与使用专门的语言模型进行HTML总结的关键作用,以实现成功的任务执行。此外,WebAgent在静态网站理解任务上表现出色,在问答准确性方面超越了单个LLMs,并与强基准模型竞争。

Google DeepMind的WebAgent是两个独立语言模型HTML-T5和Flan-U-PaLM的创新组合,它们共同工作,实现了涉及导航和处理HTML文档的高效网络自动化任务。

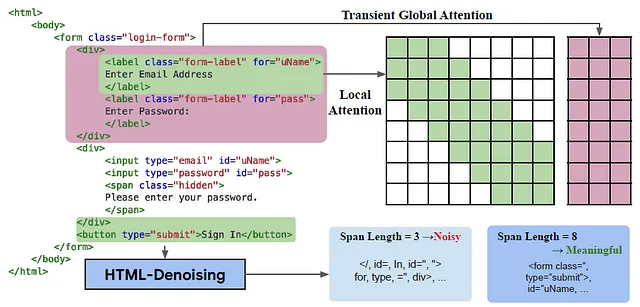

HTML-T5是一种领域专家编码器-解码器语言模型,在预测下一步程序的子指令和有条件地概括冗长的HTML文档方面发挥着关键作用。这种专门的模型在T5、Flan-T5和Instruct-GPT等语言模型的一般能力(具有强大的HTML理解能力)和先前变压器模型中发现的HTML特定归纳偏差之间取得了平衡。HTML-T5利用编码器中的局部和全局注意机制来有效处理HTML输入的分层结构。局部注意机制关注HTML中每个元素(如<input>、<label>或<button>)左右相邻的标记,而短暂的全局注意机制允许标记超出直接邻域范围,通过将输入序列分成块并通过求和和归一化计算全局标记。这种分层方法与HTML文档的结构自然对齐,其中元素在本地定义并在全局上迭代集成,如<body>、<form>或<div>。该模型在从CommonCrawl中提取的大规模HTML语料库上进行了预训练,利用了长跨度去噪目标的混合。

与传统的自然语言模型使用的稠密注意力相比,HTML-T5采用局部和全局注意机制更好地捕捉到HTML文档中存在的明确层次结构。HTML中的叶元素(如<input>、<label>等)使用局部注意力进行有效处理,而内部元素(如<body>、<form>等)则被压缩成短暂的全局注意力。这种设计选择与HTML的分层语法无缝对齐,增强了模型理解HTML元素的结构和属性的能力。

为了实现HTML-T5,Google DeepMind在LongT5的基础架构上进行了改进,该架构在解码器中采用了稠密注意力。局部和全局注意机制与解码器的稠密注意力的结合为处理Web自动化任务中的HTML文档提供了有效而全面的解决方案。

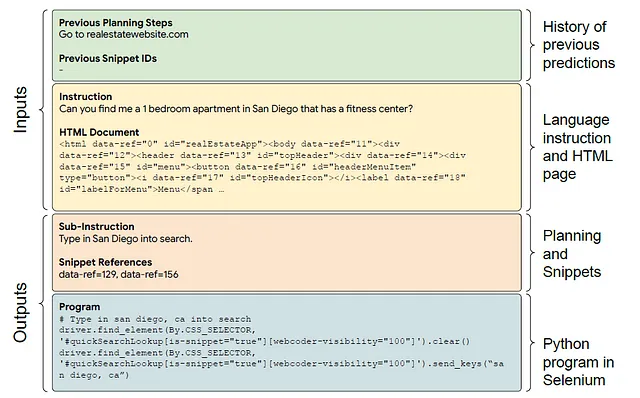

结果

为了说明Google DeepMind的WebAgent的能力,让我们以房地产网站的自动化为背景进行分析。在这个设置中,WebAgent展示了一个强大的流程,包括规划、概括和基于任务的程序综合。在这个过程中,HTML-T5发挥主导作用,通过密切分析HTML文档、黄色指令和绿色历史预测,采用迭代方法预测分解的子指令和任务相关的片段(橙色部分)。同时,受到橙色子指令和片段的触发,Flan-U-PaLM灵巧地解码蓝色表示的Python程序。

WebAgent取得的成果非常显著,在真实网站上取得了令人瞩目的70%的成功率。这一重大进展超过了单个LLM方法超过50%的表现。这一成就表明,将任务分解为由不同的语言模型处理的一系列子问题可以大大提高整体任务的成功率。

此外,Google DeepMind提出了一种创新且可扩展的方法,用于构建HTML专用的语言模型。这种方法使用长跨度去噪目标训练局部和全局注意机制。最终目标是灵活捕捉支撑HTML文档的分层结构,为更好理解和更有效地处理与HTML相关的任务铺平道路。