在快速发展的人工智能(AI)世界中,大型语言模型(LLMs)已经成为一个基石,推动创新并重塑我们与技术互动的方式。

随着这些模型变得越来越复杂,人们越来越强调使其更加民主化。尤其是开源模型在这种民主化过程中发挥了重要作用,为研究人员、开发人员和爱好者提供了深入研究其复杂性、为特定任务进行微调甚至在其基础上构建的机会。

在这篇博客中,我们将探索一些在AI社区中引起轰动的顶级开源LLMs,每个模型都带来了独特的优势和功能。

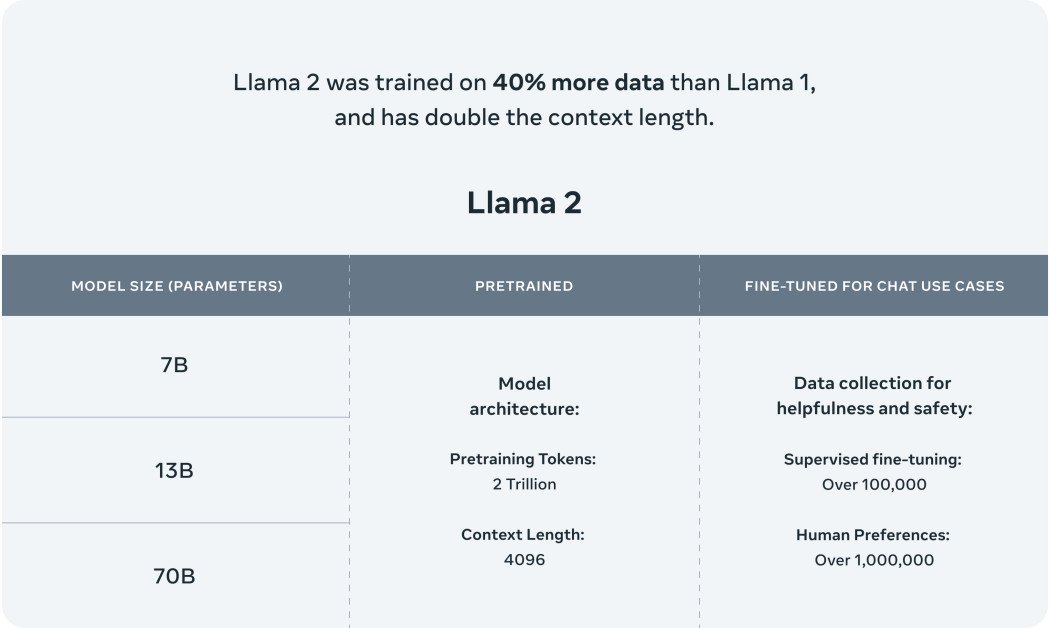

1. Llama 2

Meta的Llama 2是他们AI模型系列的一个重大突破。这不仅仅是另一个模型;它被设计用来推动一系列最先进的应用。Llama 2的训练数据广泛而多样,使其相对于其前身取得了重大进展。这种训练的多样性确保了Llama 2不仅是一种渐进式改进,而是迈向AI驱动交互未来的一大步。

Meta与Microsoft的合作扩展了Llama 2的视野。这个开源模型现在在Azure和Windows等平台上得到支持,旨在为开发人员和组织提供创建生成式AI驱动体验的工具。这种合作突显了两家公司致力于使AI更加可访问和开放的决心。

Llama 2不仅仅是原始Llama模型的继任者;它代表了聊天机器人领域的一种范式转变。虽然第一个Llama模型在生成文本和代码方面具有革命性,但为了防止滥用,其可用性受到了限制。而另一方面,Llama 2则面向更广泛的受众。它针对AWS、Azure和Hugging Face的AI模型托管平台进行了优化。此外,随着Meta与Microsoft的合作,Llama 2不仅将在Windows上留下自己的印记,还将在由高通骁龙系统芯片驱动的设备上发挥作用。

安全性是Llama 2设计的核心。由于早期的大型语言模型(如GPT)有时会产生误导性或有害内容,Meta采取了广泛措施确保Llama 2的可靠性。该模型经过了严格的训练,以最小化“幻觉”、错误信息和偏见。

LLaMa 2的顶级特点:

- 多样化的训练数据:Llama 2的训练数据既广泛又多样,确保了全面的理解和性能。

- 与Microsoft的合作:Llama 2在Azure和Windows等平台上得到支持,扩大了其应用范围。

- 开放的可用性:与其前身不同,Llama 2可供更广泛的受众使用,在多个平台上进行微调。

- 以安全为中心的设计:Meta强调安全性,确保Llama 2产生准确可靠的结果,同时减少有害输出。

- 优化版本:Llama 2有两个主要版本——Llama 2和Llama 2-Chat,后者专门设计用于双向对话。这些版本的复杂性从70亿到700亿参数不等。

- 增强的训练:Llama 2的训练使用了200万个标记,比原始Llama的1.4万亿个标记增加了很多。

2. Claude 2

Anthropic最新的AI模型Claude 2不仅仅是一个升级,而是AI模型能力的重大进步。凭借其强化的性能指标,Claude 2旨在为用户提供扩展和连贯的回答。该模型的可访问性广泛,可以通过API和其专用的测试版网站使用。用户的反馈表明,与Claude进行交互是直观的,模型提供详细的解释,并展示出扩展的记忆能力。

在学术和推理能力方面,Claude 2取得了显著的成就。该模型在法学考试的选择题部分取得了76.5%的分数,这是比Claude 1.3的73.0%有所改善。与准备研究生课程的大学生相比,Claude 2在GRE阅读和写作考试中的成绩超过了90%的百分位数,表明其在理解和生成复杂内容方面的熟练程度。

克劳德2的多功能性是另一个值得注意的特点。该模型可以处理高达100K个标记的输入,使其能够审查从技术手册到综合图书的广泛文档。此外,克劳德2还具有无缝生成从官方通信到详细叙述的扩展文档的能力。该模型的编码能力也得到了增强,克劳德2在Python编码评估Codex HumanEval上取得了71.2%的分数,在GSM8k上取得了88.0%的分数,GSM8k是一个集合了小学数学挑战的评估。

安全性始终是Anthropic关注的重点。我们努力确保克劳德2在生成潜在有害或不适当内容方面更少易受影响。通过细致入微的内部评估和先进的安全方法,克劳德2在生成良性回应方面与其前身相比展现出了显著的改进。

克劳德2:主要特点概述

- 性能提升:克劳德2响应速度更快,提供更详细的交互。

- 多种访问方式:可以通过API或专用的测试网站claude.ai进行访问。

- 学术卓越:克劳德2在学术评估中展示了令人称赞的成绩,特别是在GRE阅读和写作部分。

- 扩展的输入/输出能力:克劳德2可以处理高达100K个标记的输入,并能够一次性生成扩展文档。

- 先进的编码能力:通过编码和数学评估的分数可以看出,模型的编码能力得到了改善。

- 安全协议:通过严格评估和先进的安全技术,确保克劳德2生成良性输出。

- 扩展计划:虽然克劳德2目前仅在美国和英国可访问,但计划在不久的将来全球范围内扩大其可用性。

3. MPT-7B

MosaicML Foundations通过引入最新的开源LLM MPT-7B在这一领域做出了重大贡献。MPT-7B是MosaicML预训练变压器(MosaicML Pretrained Transformer)的缩写,是一种GPT风格的仅解码器变压器模型。该模型具有多项增强功能,包括性能优化的层实现和架构变化,以确保更高的训练稳定性。

MPT-7B的一个突出特点是它在包含1万亿个文本和代码标记的大型数据集上进行训练。这次严格的训练在MosaicML平台上进行,历时9.5天。

MPT-7B的开源性使其成为商业应用的有价值工具。它有潜力对企业和组织的预测分析和决策过程产生显著影响。

除了基础模型外,MosaicML Foundations还发布了针对特定任务的专门模型,例如用于短格式指令跟随的MPT-7B-Instruct,用于对话生成的MPT-7B-Chat,以及用于长篇故事创作的MPT-7B-StoryWriter-65k+。

MPT-7B的开发过程全面,MosaicML团队在几周内管理了从数据准备到部署的所有阶段。数据来自各种仓库,团队利用了EleutherAI的GPT-NeoX和20B标记器等工具,以确保训练组合多样且全面。

MPT-7B的主要特点概述:

- 商业许可:MPT-7B获得商业使用许可,成为企业的有价值资产。

- 广泛的训练数据:该模型在包含1万亿个标记的庞大数据集上进行了训练。

- 处理长输入:MPT-7B设计用于处理极长的输入而不会出现问题。

- 速度和效率:该模型经过优化,训练和推理速度快,确保及时结果。

- 开源代码:MPT-7B附带高效的开源训练代码,促进透明度和使用的便捷性。

- 比较优越性:MPT-7B在7B-20B范围内的其他开源模型中表现卓越,其质量与LLaMA-7B相匹配。

4. Falcon

Falcon LLM,是一种迅速崛起到LLM层次顶端的模型。Falcon LLM,具体来说是Falcon-40B,是一种具备400亿参数的基础LLM,并且已经在1万亿个标记上进行了训练。它作为一个自回归的解码器模型运作,这实际上意味着它基于前面的标记预测序列中的后续标记。这种架构类似于GPT模型。值得注意的是,Falcon的架构表现出优于GPT-3的卓越性能,仅使用了75%的训练计算资源,并且在推理期间需要更少的计算资源。

在Falcon的开发过程中,技术创新研究所的团队非常重视数据质量。他们构建了一个能够扩展到数万个CPU核心的数据管道,以快速处理并从网络上提取高质量的内容,通过广泛的过滤和去重处理实现这一目标。

除了Falcon-40B,TII还推出了其他版本,包括拥有70亿参数并在1500亿个标记上进行训练的Falcon-7B。还有像Falcon-40B-Instruct和Falcon-7B-Instruct这样的专门针对特定任务的模型。

Falcon-40B的训练是一个庞大的过程。该模型是在由TII构建的大规模英文Web数据集RefinedWeb上进行训练的。该数据集构建在CommonCrawl之上,并经过严格的筛选以确保质量。一旦模型准备好,就会对其进行验证,包括EAI Harness、HELM和BigBench等几个开源基准。

Falcon LLM的主要特点概述:

- 大量参数:Falcon-40B具备400亿参数,确保全面学习和性能。

- 自回归解码器模型:这种架构使Falcon能够根据前面的标记预测后续标记,类似于GPT模型。

- 优越性能:Falcon在仅使用75%的训练计算资源的情况下,超越了GPT-3。

- 高质量数据管道:TII的数据管道确保从网络上提取高质量的内容,这对模型的训练至关重要。

- 多种模型:除了Falcon-40B,TII还提供Falcon-7B和像Falcon-40B-Instruct和Falcon-7B-Instruct这样的专门模型。

- 开源可用性:Falcon LLM已经开源,促进了AI领域的可访问性和包容性。

Vicuna-13B

LMSYS ORG凭借Vicuna-13B在开源LLM领域取得了重要的成就。这个开源聊天机器人是通过对用户共享的来自ShareGPT的对话进行精细调优LLaMA训练的。初步评估结果表明,Vicuna-13B在GPT-4充当评委的情况下,达到了OpenAI ChatGPT和Google Bard等知名模型90%以上的质量。

令人印象深刻的是,Vicuna-13B在90%以上的情况下优于其他著名模型,如LLaMA和Stanford Alpaca。Vicuna-13B的整个训练过程的成本约为300美元。对于那些对其能力感兴趣的人,代码、权重和在线演示已经公开提供,供非商业用途使用。

Vicuna-13B模型通过70K个用户共享的ChatGPT对话进行了精细调优,使其能够生成更详细和结构良好的回复。这些回复的质量与ChatGPT可比。然而,评估聊天机器人是一项复杂的任务。随着GPT-4的进步,人们越来越好奇它在生成基准和性能评估方面的潜力。初步调查结果表明,当比较聊天机器人的回复时,GPT-4能够产生一致的排名和详细的评估。基于GPT-4的初步评估显示,Vicuna能够实现Bard/ChatGPT等模型90%的能力。

Vicuna-13B的主要特点概述:

- 开源性质:Vicuna-13B可供公众访问,促进透明度和社区参与。

- 丰富的训练数据:该模型已经在7万个用户共享的对话中进行了训练,确保对多样化互动的全面理解。

- 竞争力表现:Vicuna-13B的表现与ChatGPT和Google Bard等行业领先者媲美。

- 成本效益的训练:Vicuna-13B的整个训练过程仅花费约300美元。

- 在LLaMA上进行微调:该模型已经在LLaMA上进行了微调,确保了更好的性能和响应质量。

- 在线演示可用性:用户可以使用交互式在线演示来测试和体验Vicuna-13B的功能。

庞大语言模型的扩展领域

庞大语言模型的领域广阔且不断扩展,每个新模型都在推动可能性的界限。本文讨论的开源LLM不仅展示了人工智能社区的合作精神,还为未来的创新铺平了道路。

从Vicuna令人印象深刻的聊天机器人能力到Falcon卓越的性能指标,这些模型代表着当前LLM技术的顶峰。随着该领域的快速发展,开源模型将在塑造人工智能的未来中扮演关键角色。

无论您是经验丰富的研究人员、初学者的人工智能爱好者,还是对这些模型的潜力感到好奇的人,现在都是深入探索它们所提供的广阔可能性的最佳时机。