当少样本学习不够用时,应该怎么办…

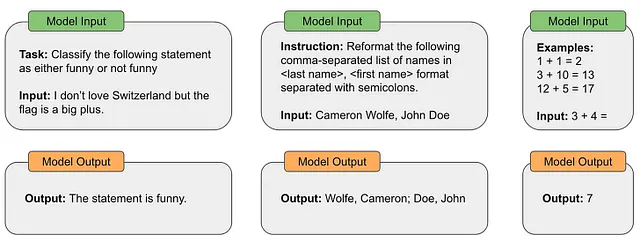

大型语言模型(LLMs)的普及彻底改变了我们作为人类解决问题的方式。在过去的几年中,使用计算机解决任何任务(例如重新格式化文档或分类句子)都需要创建一个程序(即根据某种编程语言精确编写的一组命令)。使用LLMs,解决这些问题只需要一个文本提示。例如,我们可以通过类似下面显示的提示来要求LLMs重新格式化任何文档。

如上面的示例所示,LLMs的通用文本到文本格式使我们能够轻松解决各种各样的问题。我们最初通过GPT-3[18]的提案看到了这个潜力的一瞥,它表明足够大的语言模型可以使用少样本学习以惊人的准确性解决许多任务。然而,随着LLMs周围的研究进展,我们开始超越这些基本的(但仍然非常有效!)提示技术,如零/少样本学习。

指令跟随LLMs(例如InstructGPT和ChatGPT)引导我们探索语言模型是否能够解决真正困难的任务。换句话说,我们希望能够利用LLMs解决更多不仅仅是玩具问题的问题。为了有实际用途,LLMs需要能够遵循复杂的指令并进行多步推理以正确回答人类提出的困难问题。不幸的是,使用基本的提示技术通常无法解决此类问题。要从LLMs中获取复杂的问题解决行为,我们需要更复杂的方法。

![高级提示工程 四海 第3张-四海吧 (来自[1, 2, 4, 7])](https://miro.medium.com/v2/resize:fit:640/format:webp/0*Us3E8pXbNELSXwOK.png)

扩大可能性的范围…

在之前的一篇文章中,我们了解了更基础的LLMs提示方法,例如…