强化学习(RL)近年来在解决实际问题方面取得了巨大进展,离线RL使其更加实用化。现在,我们可以从单个预先录制的数据集中训练许多算法,而不是直接与环境进行交互。然而,当评估手头的策略时,我们失去了离线RL在数据效率方面的实际优势。

例如,在训练机器人操纵器时,机器人资源通常是有限的,通过离线RL在单个数据集上训练许多策略相比在线RL给我们带来了很大的数据效率优势。评估每个策略是一个昂贵的过程,需要与机器人进行成千上万次的交互。当我们选择最佳算法、超参数和训练步骤数量时,问题很快变得棘手。

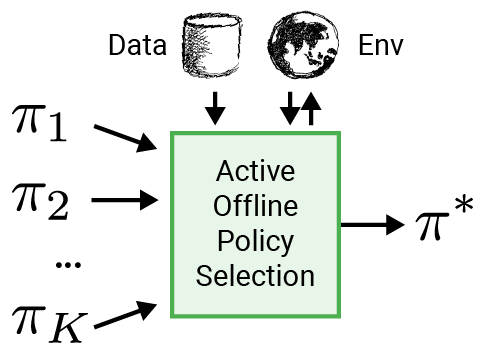

为了使RL更适用于机器人等实际应用领域,我们提出使用智能评估过程来选择部署策略,称为主动离线策略选择(A-OPS)。在A-OPS中,我们利用预先录制的数据集,并允许有限的与真实环境的交互来提高选择质量。

为了最小化与真实环境的交互,我们实施了三个关键特性:

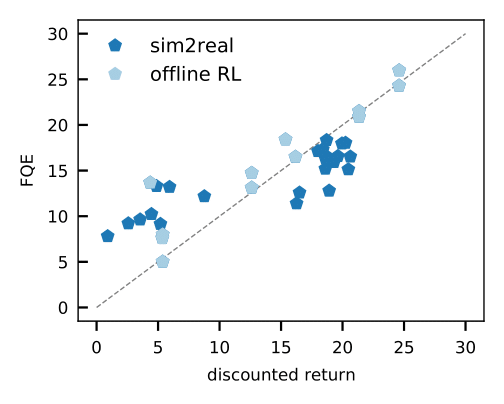

- 离策略评估,例如拟合Q评估(FQE),允许我们根据离线数据集对每个策略的性能进行初步估计。在包括实际机器人在内的许多环境中,它与实际性能的真实情况相关性很好,这是首次应用。

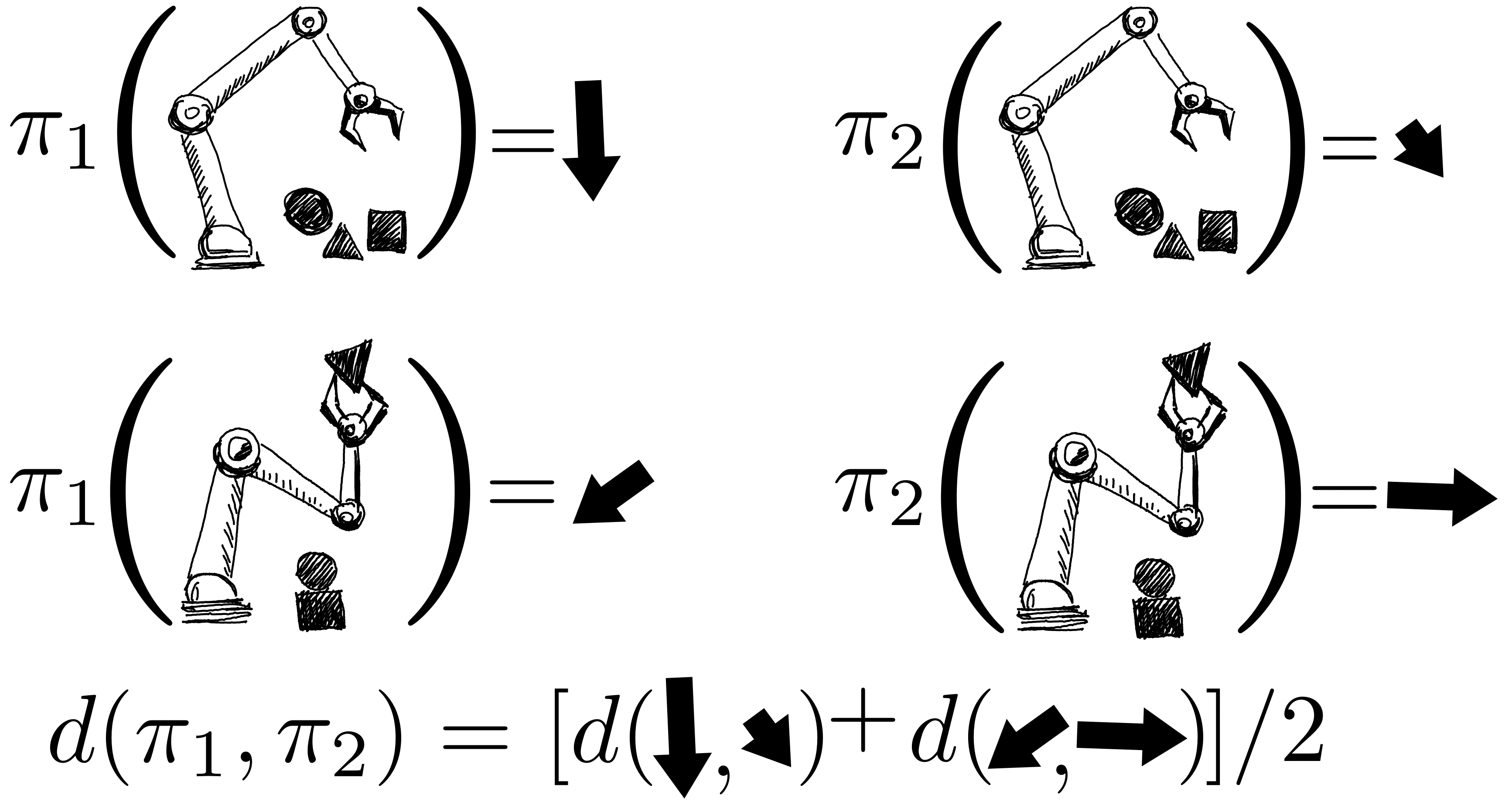

策略的回报使用高斯过程进行联合建模,其中观测结果包括FQE分数和机器人收集的少量新的回报。在评估一个策略之后,我们就对所有策略有了了解,因为它们的分布通过策略对之间的内核相关。内核假设如果策略采取相似的行动,例如将机器人夹爪移动到相似的方向,它们往往具有相似的回报。

- 为了更具数据效率,我们应用贝叶斯优化,并优先评估更有前景的策略,即预测性能高且方差大的策略。

我们在几个领域的多个环境中演示了这个过程:dm-control、Atari、模拟和真实机器人。使用A-OPS可以快速减少遗憾,并在适度数量的策略评估中找到最佳策略。

我们的研究结果表明,通过利用离线数据、特殊的内核和贝叶斯优化,仅仅通过少量的环境交互,就可以进行有效的离线策略选择。A-OPS的代码是开源的,并且可在GitHub上获取,还附带有一个示例数据集供尝试。