上个月,我们推出了Secure AI Framework(SAIF),旨在帮助解决AI系统的风险,并以负责任的方式推动技术的安全标准。

为了进一步推动这一势头,今天,我们发布了一份新报告,探讨了我们部署以支持SAIF的一个关键能力:红队演练。我们相信红队演练将在准备组织应对对AI系统的攻击方面起到决定性作用,并期待与大家共同努力,帮助每个人以安全的方式利用AI。该报告研究了我们成立专门的AI红队的工作,并包括三个重要领域:1)红队演练在AI系统背景下的含义及其重要性;2)AI红队模拟的攻击类型;和3)我们从中学到的可以与他人分享的经验教训。

红队演练是什么?

Google红队由一组黑客组成,模拟各种对手,从国家到知名的高级持久性威胁(APT)组织,再到骇客活动分子、个人犯罪分子甚至恶意内部人员。这个术语来自军队,用来描述一个指定团队扮演对抗角色(“红队”)与“主队”对抗的活动。

10:25

10:25

想要更详细了解Google的安全红队,请观看上面的视频。

在过去的十年中,我们已经将红队演练的概念与包括AI在内的最新技术创新相结合。AI红队与传统红队紧密配合,但也具备进行复杂技术攻击AI系统所需的AI专业知识。为了确保他们模拟了真实的对手活动,我们的团队利用来自世界一流的Google威胁情报团队(如Mandiant和威胁分析组(TAG))、内容滥用红队在信任与安全方面的经验教训以及来自Google DeepMind的最新攻击研究的最新见解。

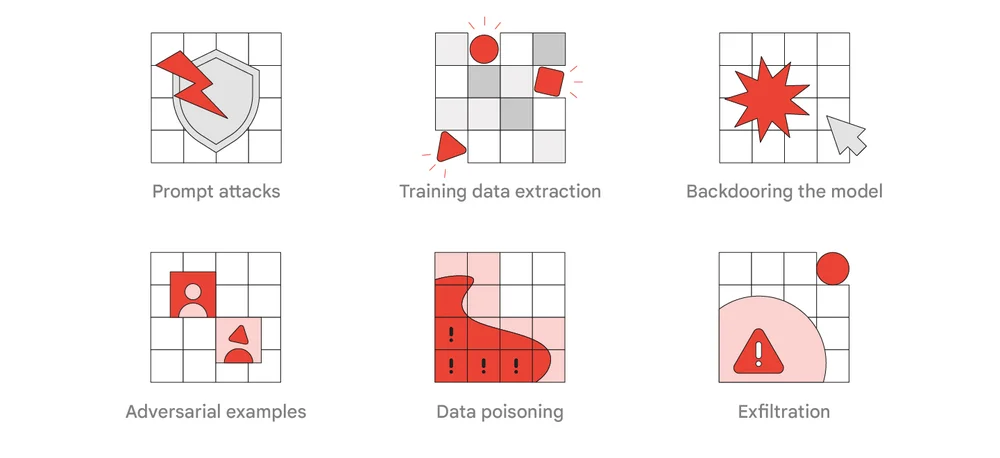

红队对AI系统的常见攻击类型

Google的AI红队的一个主要职责是将相关研究转化为针对使用AI的真实产品和功能的攻击,以了解它们的影响。根据技术的部署位置和方式,这些演习可能会涉及安全、隐私和滥用等多个领域。为了识别这些改进安全性的机会,我们利用攻击者的战术、技术和程序(TTP)来测试一系列系统防御措施。在今天的报告中,列出了一些我们认为对真实世界对手和红队演习最相关和最真实的TTP,包括即时攻击、训练数据提取、在模型中设置后门、对抗性示例、数据污染和外泄。

经验教训

我们已经看到早期迹象表明,在AI专业知识和对抗模拟方面的投资非常成功。例如,红队演习突出了潜在的漏洞和弱点,帮助我们预测现在在AI系统上看到的一些攻击。以下是报告中列出的关键经验教训。

- 传统红队是一个很好的起点,但对AI系统的攻击很快变得复杂,并且将从AI专业知识中受益。

- 解决红队发现可能会带来挑战,而且一些攻击可能没有简单的解决方法,因此我们鼓励组织将红队演练纳入他们的工作流程,以帮助推动研究和产品开发工作。

- 诸如确保系统和模型被适当地锁定之类的传统安全控制措施可以显著降低风险。

- 许多对AI系统的攻击可以像对待传统攻击一样被检测到。

展望未来

自十年前成立以来,Google的红队已经适应了不断变化的威胁形势,并成为Google各个防御团队可靠的对手。我们希望这份报告能帮助其他组织了解我们如何利用这个关键团队来保护AI系统,并成为一项共同行动的呼吁,共同推进SAIF并提高每个人的安全标准。我们建议每个组织定期进行红队演习,以确保大型公共系统中的关键AI部署的安全性。您可以查阅更多关于SAIF实施、保护AI流程的信息,还可以查看我在今年DEF CON AI Village上的演讲。