正如英国数学家卡尔·皮尔逊曾经说过的那样,统计学是科学的语法,尤其适用于计算机与信息科学、物理科学和生物科学。当您开始进入数据科学或数据分析的旅程时,具备统计知识将有助于您更好地利用数据洞察。

“统计学是科学的语法。”卡尔·皮尔逊

统计学在数据科学和数据分析中的重要性不可低估。统计学提供了寻找结构和提供深入数据洞察的工具和方法。统计学和数学都喜欢事实,厌恶猜测。了解这两个重要学科的基础知识将使您在使用数据解决业务问题和做出数据驱动决策时能够进行批判性思考,并且具备创造力。在本文中,我将涵盖以下与数据科学和数据分析相关的统计学主题:

- 随机变量

- 概率分布函数(PDF)

- 均值、方差、标准差

- 协方差和相关性

- 贝叶斯定理

- 线性回归和普通最小二乘法(OLS)

- 高斯-马尔科夫定理

- 参数特性(偏差、一致性、效率)

- 置信区间

- 假设检验

- 统计显著性

- 第一类和第二类错误

- 统计检验(学生t检验、F检验)

- p值及其限制

- 推断统计学

- 中心极限定理和大数定律

- 降维技术(PCA、FA)

如果您没有先前的统计知识,并且希望从头开始了解和学习基本的统计概念,以便为您的工作面试做好准备,那么本文适合您。本文也适合任何想要复习统计知识的人阅读。

在我们开始之前,欢迎来到LunarTech!

欢迎来到LunarTech.ai,我们了解在数据科学和人工智能这个充满活力的领域中,就业搜索策略的力量。我们深入探讨了在竞争激烈的就业搜索过程中所需的策略和技巧。无论是明确职业目标、定制应聘材料,还是利用职位招聘网站和人脉网络,我们的见解都为您提供了所需的指导,帮助您实现梦想工作的目标。

准备进行数据科学面试?不要害怕!我们为面试过程的复杂性提供了详细解析,为您提供了增加成功机会所需的知识和准备。从初步电话筛选到技术评估、技术面试和行为面试,我们无所不包。

在LunarTech.ai,我们不仅限于理论。我们是您在技术和数据科学领域取得非凡成功的跳板。我们的全面学习之旅根据您的生活方式量身定制,让您在个人和职业承诺之间取得完美平衡,同时获得前沿技能。通过我们对您职业发展的承诺,包括就业援助、专家简历建立和面试准备,您将成为一个行业准备就绪的强大力量。

加入我们这个充满雄心壮志的社区,一起踏上这个激动人心的数据科学之旅。在LunarTech.ai的帮助下,未来充满希望,您拥有开启无限机会的钥匙。

随机变量

随机变量的概念是许多统计概念的基础。它的正式数学定义可能难以理解,但简单地说,随机变量是一种将随机过程的结果(例如抛硬币或掷骰子)映射到数字的方法。例如,我们可以通过随机变量X定义抛硬币的随机过程,如果结果是正面,则取值为1,如果结果是反面,则取值为0。

在这个例子中,我们有一个抛硬币的随机过程,这个实验可以产生两种可能的结果:{0,1}。这个所有可能结果的集合被称为实验的样本空间。每次重复随机过程,都可以称之为一个事件。在这个例子中,抛硬币并得到反面作为结果是一个事件。该事件发生的机会或可能性被称为该事件的概率。一个事件的概率是随机变量取特定的值x的可能性,可以用P(x)来描述。在抛硬币的例子中,得到正面或反面的可能性是相同的,即0.5或50%。因此我们有以下设置:

在这个例子中,事件的概率只能在[0,1]范围内取值。

统计学在数据科学和数据分析中的重要性不可低估。统计学提供了找到结构和提供更深入数据洞察的工具和方法。

均值,方差,标准差

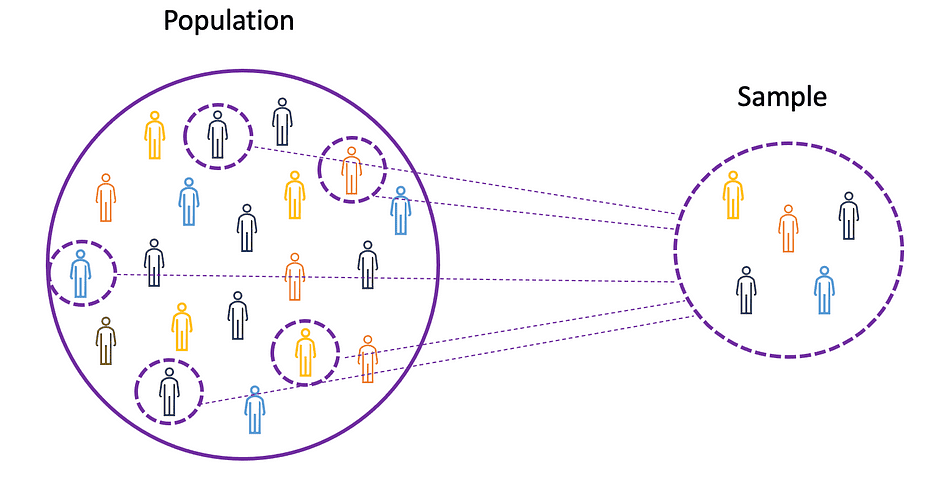

要理解均值、方差和许多其他统计主题的概念,学习总体和样本的概念非常重要。 总体是所有观察(个体、对象、事件或过程)的集合,通常非常庞大且多样化,而样本是总体中的一部分观察值,理想情况下是总体的真实表示。

鉴于对整个总体进行实验要么是不可能的,要么是太昂贵的,研究人员或分析师在实验或试验中使用样本而不是整个总体。为了确保实验结果可靠且适用于整个总体,样本需要是总体的真实表示。也就是说,样本需要是无偏的。为此,可以使用统计抽样技术,例如随机抽样、系统抽样、集群抽样、加权抽样和分层抽样。

均值

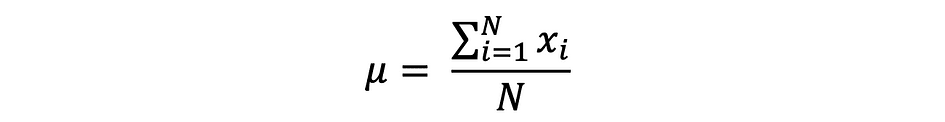

均值,也称为平均值,是有限数字集合的中心值。假设数据中的随机变量X具有以下值:

其中N是样本集中的观察次数或数据点数,也就是数据频数。然后,可以表示为以下形式的样本均值来近似表示总体均值:

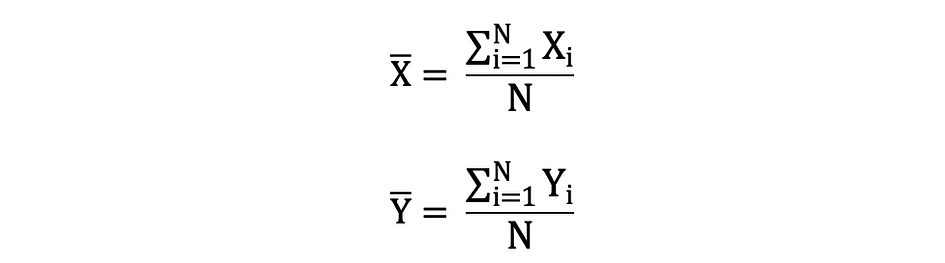

均值也被称为期望值,通常由E()或有上划线的随机变量定义。例如,随机变量X和Y的期望值,即E(X)和E(Y),可以表示为以下形式:

import numpy as np

import math

x = np.array([1,3,5,6])

mean_x = np.mean(x)

# 如果数据包含NaN值

x_nan = np.array([1,3,5,6, math.nan])

mean_x_nan = np.nanmean(x_nan)

方差

方差衡量数据点与平均值(均值)之间差异的程度,并等于数据值与平均值之间差异的平方和。此外,总体方差可以表示为以下形式:

x = np.array([1,3,5,6])

variance_x = np.var(x)

# 这里需要指定自由度(df),即最大逻辑独立数据点的数量,这些数据点具有变动的自由度

x_nan = np.array([1,3,5,6, math.nan])

mean_x_nan = np.nanvar(x_nan, ddof = 1)

要了解不同流行概率分布函数的期望和方差,请查看此Github存储库。

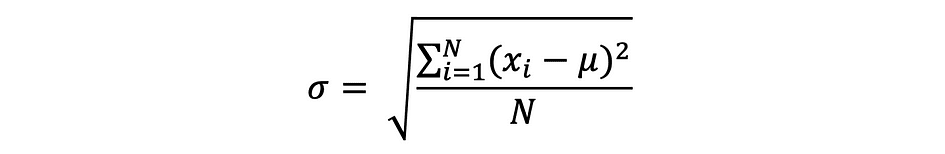

标准差

标准差是方差的平方根,它衡量数据与其均值之间的差异程度。标准差由sigma定义,可以表示为:

标准差通常比方差更受青睐,因为它与数据点具有相同的单位,这意味着您可以更容易地解释它。

x = np.array([1,3,5,6])

variance_x = np.std(x)

x_nan = np.array([1,3,5,6, math.nan])

mean_x_nan = np.nanstd(x_nan, ddof = 1)

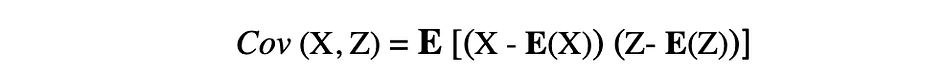

协方差

协方差是两个随机变量的联合变异性的度量,描述了这两个变量之间的关系。它被定义为两个随机变量与其均值的偏差乘积的期望值。两个随机变量X和Z的协方差可以用以下表达式描述,其中E(X)和E(Z)分别表示X和Z的均值。

协方差可以取负值、正值或零值。正值的协方差表示两个随机变量倾向于以相同的方向变动,而负值则表示这些变量以相反的方向变动。最后,值为0表示它们不一起变动。

x = np.array([1,3,5,6])

y = np.array([-2,-4,-5,-6])

#这将返回包含x方差、y方差和x、y协方差的协方差矩阵

cov_xy = np.cov(x,y)

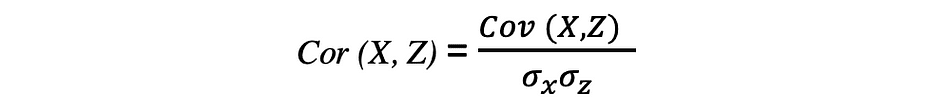

相关性

相关性也是一种关系度量,它同时衡量了两个变量之间的线性关系的强度和方向。如果检测到相关性,则意味着两个目标变量的值之间存在关系或模式。两个随机变量X和Z之间的相关性等于这两个变量的协方差除以这两个变量的标准差的乘积,可以用以下表达式描述。

相关系数的取值范围在-1到1之间。请记住,变量与自身的相关性始终为1,即Cor(X, X) = 1。在解释相关性时要记住的另一件事是不要将其与因果关系混淆,因为相关性不意味着因果关系。即使两个变量之间存在相关性,也不能得出一个变量导致另一个变量发生变化的结论。这种关系可能是巧合的,或者可能有第三个因素导致这两个变量都发生变化。

x = np.array([1,3,5,6])

y = np.array([-2,-4,-5,-6])

corr = np.corrcoef(x,y)

概率分布函数

描述随机变量在给定范围内可能取值的全部可能值、样本空间和相应的概率的函数称为概率分布函数(pdf)或概率密度。每个概率分布函数都需要满足以下两个条件:

其中第一个条件表示所有概率应该是介于[0,1]范围内的数字,第二个条件表示所有可能概率的总和应该等于1。

概率函数通常分为两类:离散分布和连续分布。离散分布函数描述具有可数样本空间的随机过程,例如抛硬币的例子只有两种可能的结果。连续分布函数描述具有连续样本空间的随机过程。离散分布函数的例子有伯努利分布、二项分布、泊松分布、离散均匀分布。连续分布函数的例子有正态分布、连续均匀分布、柯西分布。

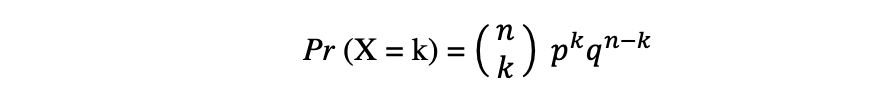

二项分布

二项分布是n次独立实验中成功次数的离散概率分布,每次实验的结果是布尔值:成功(概率为p)或失败(概率为q = 1 – p)。假设随机变量X服从二项分布,则在n次独立试验中观察到k次成功的概率可以用以下概率密度函数表示:

二项分布在分析重复独立实验的结果时很有用,特别是如果对于特定的错误率,对达到特定阈值的概率感兴趣。

二项分布的均值和方差

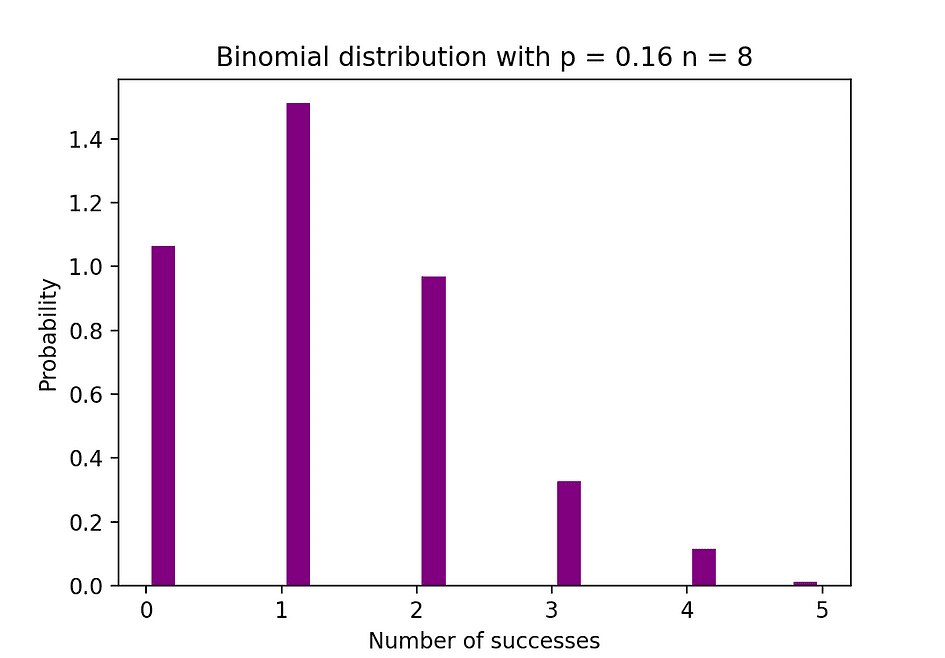

下图展示了一个二项分布的例子,其中独立试验的次数为8,每次试验的成功概率为16%。

图片来源:作者

图片来源:作者

# 生成1000个独立二项分布样本

import numpy as np

n = 8

p = 0.16

N = 1000

X = np.random.binomial(n,p,N)

# 二项分布的直方图

import matplotlib.pyplot as plt

counts, bins, ignored = plt.hist(X, 20, density = True, rwidth = 0.7, color = 'purple')

plt.title("二项分布 p = 0.16 n = 8")

plt.xlabel("成功次数")

plt.ylabel("概率")

plt.show()泊松分布

泊松分布是在指定时间段内事件发生次数的离散概率分布,给定事件在该时间段内出现的平均次数。假设随机变量X服从泊松分布,则在一段时间内观察到k个事件的概率可以用以下概率函数表示:

其中e是自然对数的底数,? lambda是到达率参数,是X的期望值。泊松分布函数在模拟在给定时间间隔内发生的可计数事件方面非常流行。

泊松分布的均值和方差

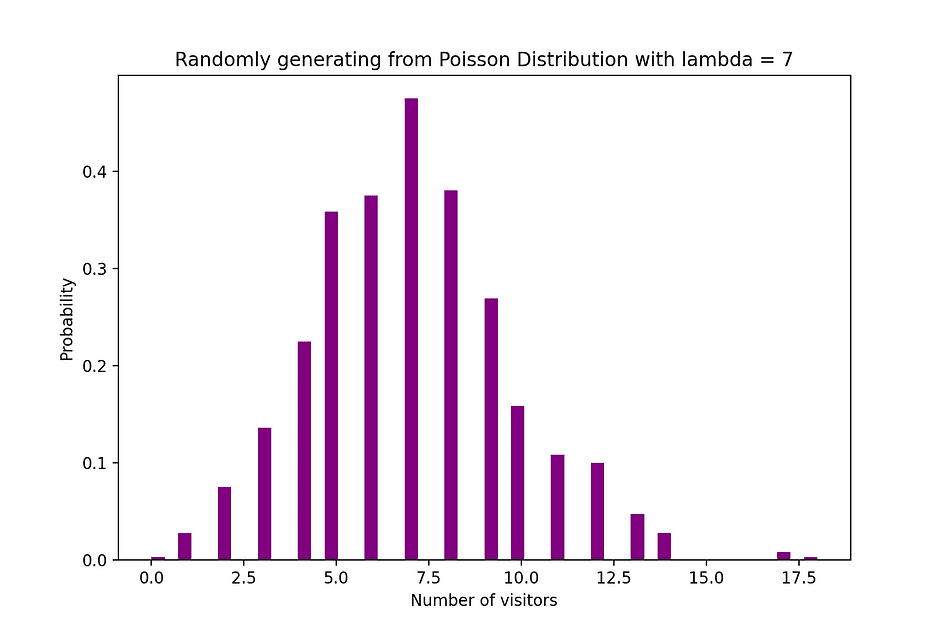

例如,泊松分布可以用来模拟晚上7点到10点间商店中到达的顾客数量,或者模拟晚上11点到12点间急诊室中到达的患者数量。下图展示了一个泊松分布的例子,其中统计了到达网站的访问者数量,到达率lambda假设为7分钟。

图片来源:作者

图片来源:作者

# 1000个独立泊松样本的随机生成

import numpy as np

lambda_ = 7

N = 1000

X = np.random.poisson(lambda_,N)

# 泊松分布的直方图

import matplotlib.pyplot as plt

counts, bins, ignored = plt.hist(X, 50, density = True, color = 'purple')

plt.title("从泊松分布中随机生成,λ = 7")

plt.xlabel("访客数量")

plt.ylabel("概率")

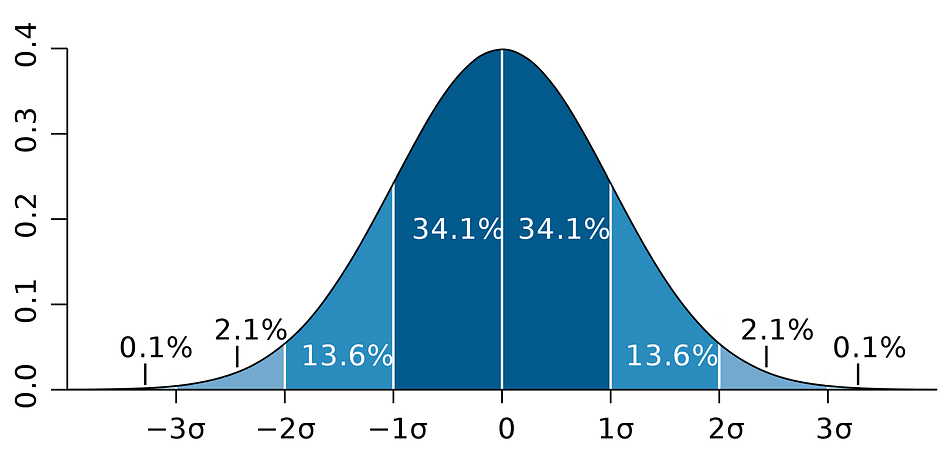

plt.show()正态分布

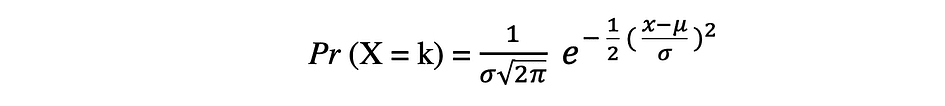

正态概率分布是实值随机变量的连续概率分布。正态分布,也称为高斯分布,是社会科学和自然科学中常用的最流行的分布函数之一,用于建模人们的身高或考试成绩等。假设随机变量X服从正态分布,则其概率密度函数可以表示如下。

其中参数μ(mu)是分布的均值,也称为位置参数,参数σ(sigma)是分布的标准差,也称为尺度参数。数学常数π(pi)约等于3.14。

正态分布的均值和方差

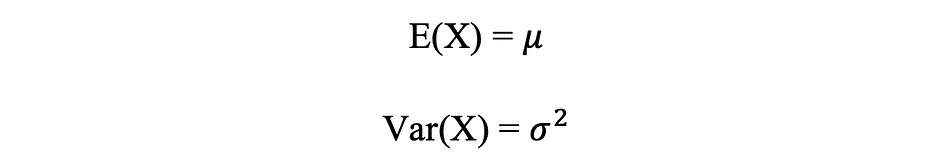

下图展示了均值为0(μ = 0)和标准差为1(σ = 1)的正态分布示例,被称为标准正态分布,是对称的。

图片来源:作者

图片来源:作者

# 1000个独立正态样本的随机生成

import numpy as np

mu = 0

sigma = 1

N = 1000

X = np.random.normal(mu,sigma,N)

# 总体分布

from scipy.stats import norm

x_values = np.arange(-5,5,0.01)

y_values = norm.pdf(x_values)

# 带有总体分布的样本直方图

import matplotlib.pyplot as plt

counts, bins, ignored = plt.hist(X, 30, density = True,color = 'purple',label = '抽样分布')

plt.plot(x_values,y_values, color = 'y',linewidth = 2.5,label = '总体分布')

plt.title("从正态分布中随机生成1000个观测,μ = 0,σ = 1")

plt.ylabel("概率")

plt.legend()

plt.show()贝叶斯定理

贝叶斯定理,通常称为贝叶斯法则,是概率和统计学中最强大的规则,以英国著名的统计学家和哲学家托马斯·贝叶斯命名。

图片来源:Wikipedia

图片来源:Wikipedia

贝叶斯定理是一种强大的概率法则,将“主观性”的概念引入了统计学和数学的世界,而这个世界一切都是事实。它描述了一个事件的概率,基于可能与该事件相关的先前条件信息。例如,如果感染冠状病毒或Covid-19的风险随年龄增加而增加,那么贝叶斯定理允许更准确地通过对年龄进行条件处理来确定已知年龄的个体的风险,而不仅仅是假设该个体是整个人群的普通成员。

条件概率的概念,在贝叶斯理论中起着核心作用,它是在另一个事件已经发生的情况下,事件发生的概率的度量。贝叶斯定理可以用以下表达式描述,其中X和Y分别代表事件X和Y:

- Pr (X|Y):在事件或条件Y已发生或为真的情况下,事件X发生的概率

- Pr (Y|X):在事件或条件X已发生或为真的情况下,事件Y发生的概率

- Pr (X)和 Pr (Y):分别是观察到事件X和Y的概率

以前面的例子为例,当处于某个年龄时得到冠状病毒(事件X)的概率是 Pr (X|Y),它等于得到冠状病毒的概率 Pr (Y|X) 乘以得到冠状病毒的概率 Pr (X),再除以处于某个年龄的概率 Pr (Y)。

线性回归

之前介绍了变量之间的因果关系的概念,当一个变量对另一个变量有直接影响时,就会发生因果关系。当两个变量之间的关系是线性的时,线性回归是一种统计方法,可以帮助建模一个变量(独立变量)的单位变化对另一个变量(因变量)的值产生的影响。

因变量通常被称为响应变量或解释变量,而独立变量通常被称为回归变量或解释变量。当线性回归模型基于单个独立变量时,该模型被称为简单线性回归,当模型基于多个独立变量时,则被称为多元线性回归。简单线性回归可以用以下表达式描述:

其中Y是因变量,X是独立变量,属于数据的一部分,?0是截距,未知且常数,?1是斜率系数或与变量X相对应的参数,也是未知且常数。最后,u是当估计Y值时模型产生的误差项。线性回归的主要思想是找到最佳拟合的直线(回归线),通过一组成对的(X,Y)数据。线性回归应用的一个例子是模拟Flipper Length对企鹅的Body Mass的影响,如下所示。

图片来源:作者

图片来源:作者

# 用于绘图的R代码

install.packages("ggplot2")

install.packages("palmerpenguins")

library(palmerpenguins)

library(ggplot2)

View(data(penguins))

ggplot(data = penguins, aes(x = flipper_length_mm,y = body_mass_g))+

geom_smooth(method = "lm", se = FALSE, color = 'purple')+

geom_point()+

labs(x="Flipper Length (mm)",y="Body Mass (g)")

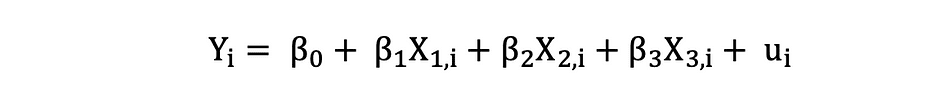

具有三个独立变量的多元线性回归可以用以下表达式描述:

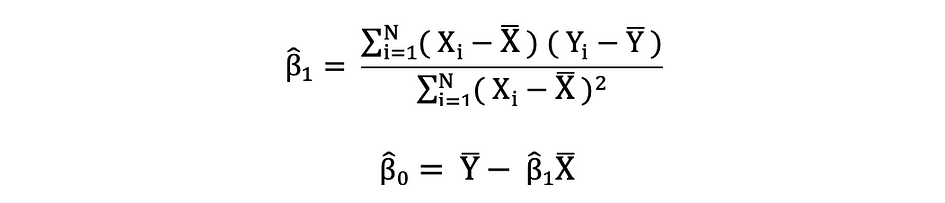

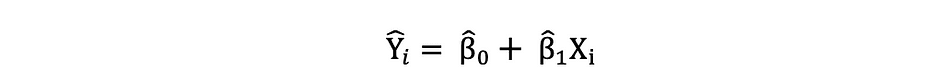

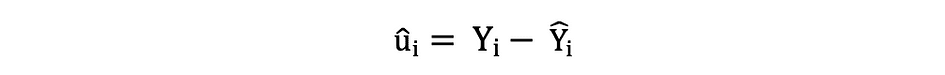

普通最小二乘法

普通最小二乘法(OLS)是一种估计线性回归模型中未知参数(如?0和?1)的方法。该模型基于最小二乘法的原理,最小化观测到的因变量与由独立变量的线性函数预测的值之间的差异的平方和,通常称为拟合值。因变量Y的实际值与预测值之间的差异被称为残差,OLS所做的就是最小化残差的平方和。这个优化问题的结果是对未知参数?0和?1的OLS估计,也称为系数估计。

一旦估计出简单线性回归模型的这些参数,就可以计算响应变量的拟合值如下:

标准误差

可以通过以下方式确定残差或估计的误差项:

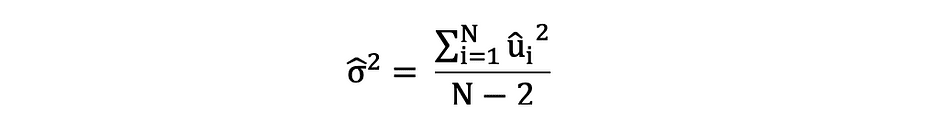

重要的是要注意误差项和残差之间的区别。误差项从未被观察到,而残差是从数据中计算出来的。OLS为每个观测值估计误差项,但不估计实际的误差项。因此,真实的误差方差仍然未知。此外,这些估计值受抽样不确定性的影响。这意味着我们将永远无法从经验应用的样本数据中确定这些参数的确切估计值。然而,我们可以通过使用残差计算样本残差方差来估计它,如下所示。

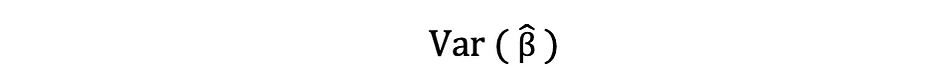

这个样本残差方差的估计有助于估计估计参数的方差,通常表示如下:

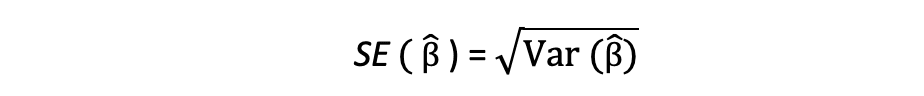

这个方差项的平方根称为估计的标准误差,它是评估参数估计的准确性的关键组成部分。它用于计算检验统计量和置信区间。标准误差可以表示如下:

重要的是要注意误差项和残差之间的区别。误差项从未被观察到,而残差是从数据中计算出来的。

OLS假设

OLS估计方法做出了以下假设,需要满足才能获得可靠的预测结果:

A1:线性假设指的是模型在参数上是线性的。

A2:随机样本假设指的是样本中的所有观测值是随机选择的。

A3:外生性假设指的是自变量与误差项不相关。

A4:同方差性假设指的是所有误差项的方差是恒定的。

A5:无完美多重共线性假设指的是没有任何自变量是恒定的,且自变量之间没有精确的线性关系。

def runOLS(Y,X):

# OLS估计 Y = Xb + e --> beta_hat = (X'X)^-1(X'Y)

beta_hat = np.dot(np.linalg.inv(np.dot(np.transpose(X), X)), np.dot(np.transpose(X), Y))

# OLS预测

Y_hat = np.dot(X,beta_hat)

residuals = Y-Y_hat

RSS = np.sum(np.square(residuals))

sigma_squared_hat = RSS/(N-2)

TSS = np.sum(np.square(Y-np.repeat(Y.mean(),len(Y))))

MSE = sigma_squared_hat

RMSE = np.sqrt(MSE)

R_squared = (TSS-RSS)/TSS

# 估计的标准误差:估计的方差的平方根

var_beta_hat = np.linalg.inv(np.dot(np.transpose(X),X))*sigma_squared_hat

SE = []

t_stats = []

p_values = []

CI_s = []

for i in range(len(beta)):

#标准误差

SE_i = np.sqrt(var_beta_hat[i,i])

SE.append(np.round(SE_i,3))

#t统计量

t_stat = np.round(beta_hat[i,0]/SE_i,3)

t_stats.append(t_stat)

#t统计量的p值 p[|t_stat| >= t-treshhold two sided]

p_value = t.sf(np.abs(t_stat),N-2) * 2

p_values.append(np.round(p_value,3))

#置信区间 = beta_hat -+ 误差边界

t_critical = t.ppf(q =1-0.05/2, df = N-2)

误差边界 = t_critical*SE_i

CI = [np.round(beta_hat[i,0]-误差边界,3), np.round(beta_hat[i,0]+误差边界,3)]

CI_s.append(CI)

return(beta_hat, SE, t_stats, p_values,CI_s,

MSE, RMSE, R_squared)参数特性

在假设OLS准则A1-A5得到满足的前提下,OLS系数估计值β0和β1是BLUE(最佳线性无偏估计)和Consistent(一致性)。

Gauss-Markov定理

这个定理强调了OLS估计的特性,其中术语BLUE表示最佳线性无偏估计。

偏差

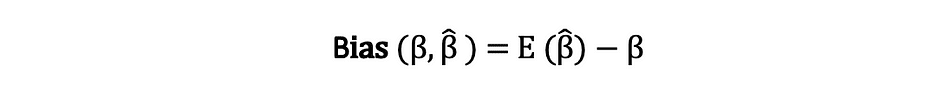

估计量的偏差是指其期望值与被估计参数的真实值之间的差异,可以表示为:

当我们说估计量是无偏的时,意味着偏差等于零,这意味着估计量的期望值等于真实参数值,即:

无偏性并不保证特定样本得到的估计值等于或接近真实参数。它的意思是,如果从总体中重复地随机抽取样本,并计算每次的估计值,那么这些估计值的平均值将等于或非常接近β。

效率

Gauss-Markov定理中的最佳一词与估计量的方差有关,被称为效率。一个参数可能有多个估计量,但方差最低的估计量被称为高效的。

一致性

一致性这个术语与样本大小和收敛性密切相关。如果估计量在样本大小变得非常大时收敛于真实参数,则该估计量被称为一致的,即:

在假设OLS准则A1-A5得到满足的前提下,OLS系数估计值β0和β1是BLUE(最佳线性无偏估计)和Consistent(一致性)。Gauss-Markov定理

所有这些特性都适用于OLS估计,如Gauss-Markov定理所总结的那样。换句话说,OLS估计具有最小的方差,它们是无偏的、线性的,并且是一致的。这些特性可以通过使用之前提出的OLS假设进行数学证明。

置信区间

置信区间是包含真实总体参数的范围,具有一定的预先指定的概率,称为实验的置信水平,并通过使用样本结果和误差限来获得。

误差限

误差限是样本结果与如果使用整个总体时的结果之间的差异。

置信水平

置信水平描述了实验结果的确定性水平。例如,95%置信水平意味着如果重复进行100次相同的实验,那么其中95次会得到类似的结果。需要注意的是,置信水平在实验开始之前定义,因为它将影响实验结束时误差限的大小。

OLS估计的置信区间

正如前面提到的,简单线性回归的OLS估计,即截距项 ?0 和斜率系数 ?1 的估计值,受到抽样不确定性的影响。然而,我们可以构建这些参数的置信区间,其中95%的样本中都包含这些参数的真实值。也就是说,95%的置信区间可以解释为:

- 置信区间是一组值,对于这些值,无法以5%的显著性水平拒绝假设检验。

- 置信区间有95%的概率包含参数的真实值。

OLS估计的95%置信区间可以按以下方式构建:

该置信区间基于参数估计值、该估计值的标准误差以及表示5%拒绝规则的误差限1.96。这个值是使用正态分布表确定的,稍后在本文中将讨论。同时,下图说明了95%置信区间的概念:

图片来源:维基百科

图片来源:维基百科

请注意,置信区间也取决于样本大小,因为它是使用基于样本大小的标准误差进行计算的。

置信水平在实验开始之前就确定了,因为它将影响实验结束时的误差限大小。

统计假设检验

在统计学中,假设检验是一种测试实验或调查结果的方式,以确定结果的意义。基本上,通过计算结果发生的概率来测试结果是否有效。如果结果是偶然发生的,那么结果就不可靠,实验也是如此。假设检验是统计推断的一部分。

零假设和备择假设

首先,您需要确定要测试的论点,然后需要制定零假设和备择假设。测试可以有两种可能的结果,根据统计结果,您可以拒绝或接受所述假设。作为经验法则,统计学家倾向于将需要被拒绝的假设的版本或制定放在零假设下,而可接受和期望的版本则在备择假设下进行说明。

统计显著性

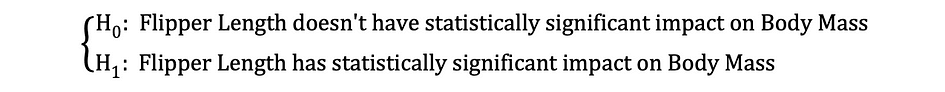

让我们看一下前面提到的例子,其中线性回归模型用于研究企鹅的翼长(独立变量)对体重(因变量)是否有影响。我们可以用以下统计表达式来形式化这个模型:

然后,一旦估计出系数的OLS估计值,我们可以制定以下零假设和备择假设,以测试翼长是否对体重产生统计显著影响:

其中H0和H1分别表示零假设和备择假设。拒绝零假设意味着翼长的增加对体重有直接影响。给定参数估计值?1描述了独立变量翼长对因变量体重的影响。这个假设可以重新表述如下:

其中H0表明参数估计的?1等于0,即Flipper Length对Body Mass的影响在统计上不显著,而H0表明参数估计的?1不等于0,暗示Flipper Length对Body Mass的影响在统计上显著。

第一类错误和第二类错误

在进行统计假设检验时,需要考虑两种概念上的错误:第一类错误和第二类错误。第一类错误发生在错误地拒绝原假设时,而第二类错误发生在错误地未拒绝原假设时。混淆矩阵可以帮助清晰地可视化这两种错误的严重性。

作为经验法则,统计学家倾向于将版本假设放在需要被拒绝的原假设下,而可接受和期望的版本则在备择假设下陈述。

统计检验

一旦原假设和备择假设被陈述并定义了检验假设,下一步是确定哪种统计检验是适当的,并计算检验统计量。拒绝还是不拒绝原假设可以通过将检验统计量与临界值进行比较来确定。这种比较显示观察到的检验统计量是否比定义的临界值更极端,并且可能有两种可能的结果:

- 检验统计量比临界值更极端 – 可以拒绝原假设

- 检验统计量不如临界值极端 – 不能拒绝原假设

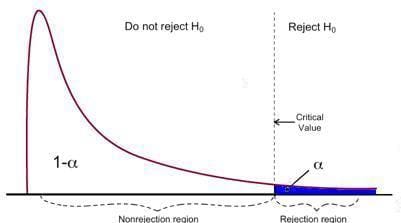

临界值基于预先指定的显著性水平(通常选择为5%)和检验统计量遵循的概率分布类型。临界值将此概率分布曲线下的区域分为拒绝区域和非拒绝区域。有许多用于测试各种假设的统计检验。统计检验的例子包括学生t检验、F检验、卡方检验、Durbin-Hausman-Wu内生性检验、White异方差检验。在本文中,我们将介绍其中两个统计检验。

第一类错误发生在错误地拒绝原假设时,而第二类错误发生在错误地未拒绝原假设时。

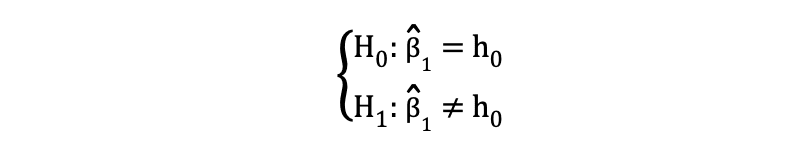

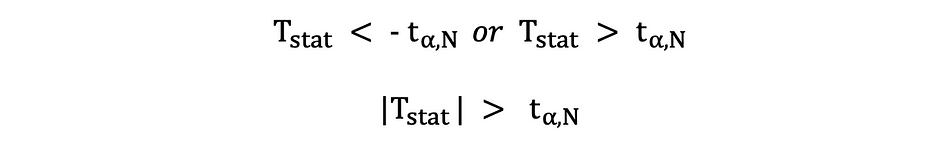

学生t检验

最简单和最流行的统计检验之一是学生t检验。它可以用于测试各种假设,特别是当涉及到主要关注的假设是寻找对单个变量的统计显著影响的证据时。t检验的检验统计量遵循学生t分布,可以确定如下:

其中分子中的h0是正在测试的参数估计相对于的值。因此,t检验统计量等于参数估计减去假设值除以系数估计的标准误差。在前面提到的假设中,我们想要测试Flipper Length是否对Body Mass有统计显著影响。可以使用t检验进行此测试,而h0在这种情况下等于0,因为斜率系数估计相对于值0进行测试。

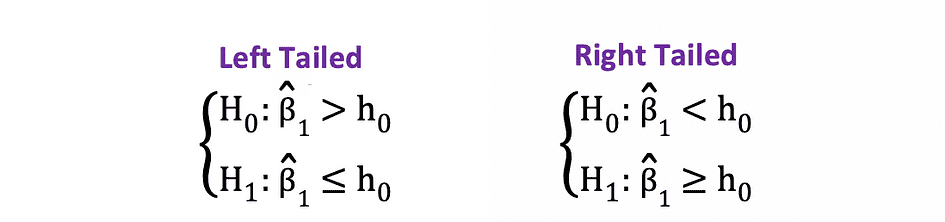

t检验有两个版本:一个是双侧t检验,一个是单侧t检验。您需要哪个版本的检验取决于您要测试的假设。

当假设在原假设和备择假设下测试相等与不相等的关系时,可以使用双侧t检验,如以下示例:

双侧t检验在下图中可视化为两个拒绝区域:

图片来源:Hartmann, K., Krois, J., Waske, B. (2018): E-Learning Project SOGA: Statistics and Geospatial Data Analysis. Department of Earth Sciences, Freie Universitaet Berlin

图片来源:Hartmann, K., Krois, J., Waske, B. (2018): E-Learning Project SOGA: Statistics and Geospatial Data Analysis. Department of Earth Sciences, Freie Universitaet Berlin

在这个版本的t检验中,如果计算出的t统计量过小或过大,就会拒绝零假设。

这里,将测试统计量与基于样本大小和选择的显著性水平的临界值进行比较。为了确定截断点的确切值,可以使用双侧t分布表。

当假设在零假设和备择假设下测试阳性/阴性与阴性/阳性关系时,可以使用单侧或单尾t检验,类似于以下示例:

单侧t检验有一个单个的拒绝区域,取决于假设方向,拒绝区域要么在左侧,要么在右侧,如下图所示:

图片来源:Hartmann, K., Krois, J., Waske, B. (2018): E-Learning Project SOGA: Statistics and Geospatial Data Analysis. Department of Earth Sciences, Freie Universitaet Berlin

图片来源:Hartmann, K., Krois, J., Waske, B. (2018): E-Learning Project SOGA: Statistics and Geospatial Data Analysis. Department of Earth Sciences, Freie Universitaet Berlin

在这个版本的t检验中,如果计算出的t统计量小于/大于临界值,就会拒绝零假设。

F检验

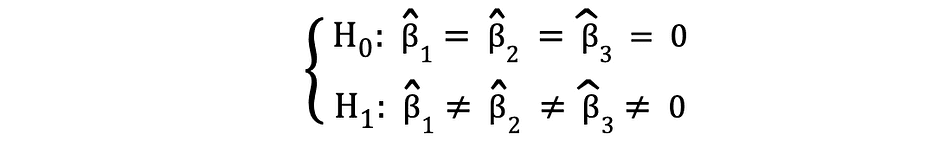

F检验是另一种非常流行的统计检验,常用来测试多个变量的联合统计显著性。当您想要测试多个独立变量对一个因变量是否有统计显著影响时,可以使用F检验。以下是一个可以使用F检验进行测试的统计假设示例:

其中,零假设表示与这些系数对应的三个变量在统计上是不显著的,备择假设表示这三个变量在统计上是显著的。F检验的测试统计量遵循F分布,可以通过以下方式确定:

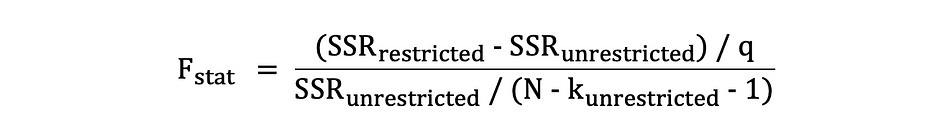

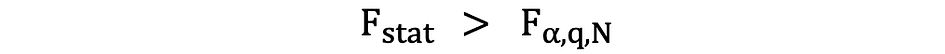

其中,SSRrestricted是受限制模型的平方残差和,该模型从数据中排除了在零假设下被认为是不显著的目标变量,SSRunrestricted是不受限制模型的平方残差和,该模型包括所有变量,q表示在零假设下被联合测试的变量数量,N是样本大小,k是不受限制模型中的变量总数。运行OLS回归后,参数估计旁边提供了SSR值,F统计量也是如此。以下是一个MLR模型输出的示例,其中标有SSR和F统计量的值。

图片来源:Stock and Whatson

图片来源:Stock and Whatson

F检验有一个单个的拒绝区域,如下图所示:

图片来源:密歇根大学

图片来源:密歇根大学

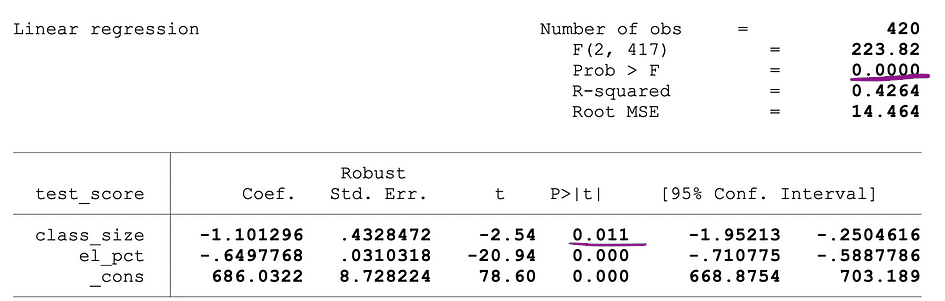

如果计算得到的F统计量大于临界值,则可以拒绝原假设,这意味着独立变量在统计上是显著的。拒绝规则可以表达如下:

P-值

另一种确定是否拒绝或支持原假设的快速方法是使用p-值。p-值是在原假设下发生条件的概率。换句话说,p-值是在假设原假设为真的情况下,观察到至少与检验统计量一样极端结果的概率。p-值越小,对原假设的证据越强,表明可以拒绝原假设。

p-值的解释取决于选择的显著性水平。通常使用1%、5%或10%的显著性水平来解释p-值。因此,可以使用这些检验统计量的p-值来测试相同的假设,而无需使用t检验和F检验。

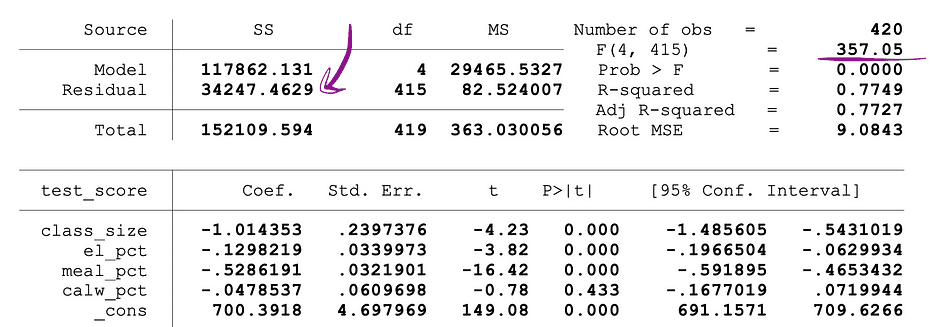

下图显示了具有两个独立变量的OLS回归的样本输出。在这个表格中,下划线表示t检验的p-值,用于测试class_size变量参数估计的统计显著性,以及F检验的p-值,用于测试class_size和el_pct变量参数估计的联合统计显著性。

图片来源:Stock and Whatson

图片来源:Stock and Whatson

与class_size变量对应的p-值为0.011,将该值与显著性水平1%或0.01、5%或0.05、10%或0.1进行比较,可以得出以下结论:

- 0.011 > 0.01 ? 无法在1%的显著性水平下拒绝t检验的原假设

- 0.011 < 0.05 ? 可以在5%的显著性水平下拒绝t检验的原假设

- 0.011 < 0.10 ? 可以在10%的显著性水平下拒绝t检验的原假设

因此,这个p-值表明在5%和10%的显著性水平上,class_size变量的系数在统计上是显著的。与F检验对应的p-值为0.0000,由于0小于所有三个截断值0.01、0.05、0.10,我们可以得出结论:在这三种情况下,可以拒绝F检验的原假设。这表明class_size和el_pct变量的系数在1%、5%和10%的显著性水平上是联合统计显著的。

p-值的限制

尽管使用p-值有很多好处,但它也有一些限制。 即,p-值取决于关联程度和样本大小。如果效应的大小很小且在统计上不显著,p-值可能仍然显示出显著影响,因为样本大小很大。相反,如果样本大小很小,即使效应很大,也可能无法满足p<0.01、0.05或0.10的标准。

推断统计学

推断统计学使用样本数据对产生样本数据的总体进行合理的判断。它用于研究样本内变量之间的关系,并预测这些变量与更大的总体之间的关系。

大数定律(LLN)和中心极限定理(CLM)在推断统计学中起着重要作用,因为它们表明实验结果在数据足够大的情况下是成立的。收集的数据越多,统计推断越准确,因此生成的参数估计越准确。

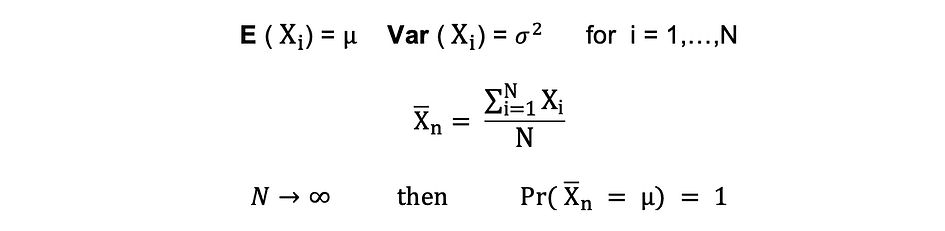

大数定律 (LLN)

假设X1, X2, . . . , Xn都是具有相同基本分布的独立随机变量,也称为独立同分布(i.i.d),其中所有X的均值为?,标准差为?。随着样本大小的增长,所有X的平均值等于均值?的概率趋近于1。大数定律可以总结如下:

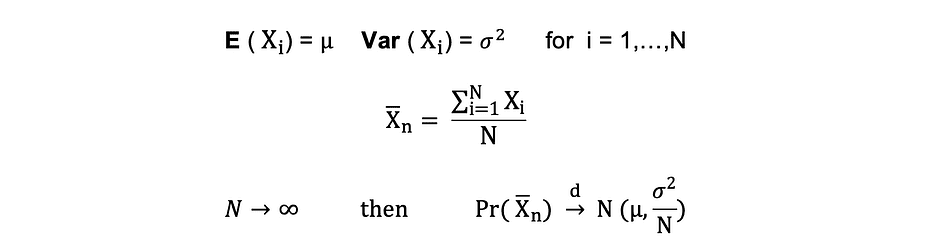

中心极限定理 (CLM)

假设X1, X2, . . . , Xn都是具有相同基本分布的独立随机变量,也称为独立同分布(i.i.d),其中所有X的均值为?,标准差为?。随着样本大小的增长,随机变量X的概率分布趋近于均值为? ,方差为?-的正态分布。中心极限定理可以总结如下:

换句话说,当你有一个均值为?,标准差为?的总体,并且从该总体中进行足够大的、带有替换的随机样本时,样本均值的分布将近似服从正态分布。

降维技术

降维是将数据从一个高维空间转换为一个低维空间的过程,使得这个低维表示仍然尽可能地保留原始数据的有意义特性。

随着大数据的流行,对这些降维技术的需求也越来越高,因为它们可以减少不必要的数据和特征。一些常见的降维技术包括主成分分析(PCA)、因子分析(Factor Analysis)、规范相关分析(Canonical Correlation)和随机森林(Random Forest)。

主成分分析 (PCA)

主成分分析(PCA)是一种常用的降维技术,用于将大数据集的维度降低,通过将一组大量变量转换为一个较小的集合,仍然包含原始大数据集中的大部分信息或变异。

假设我们有一个具有p个变量的数据X;X1, X2, …., Xp具有特征向量e1, …, ep和特征值?1,…, ?p。特征值显示特定数据字段解释的总方差。PCA的思想是创建新的(独立的)变量,称为主成分,它们是现有变量的线性组合。第i个主成分可以表示如下:

然后,使用拐点法则或Kaiser法则,可以确定最佳汇总数据的主成分数量,同时又不会损失太多信息。还要注意计算每个主成分解释的总变异比例(PRTV),以决定是否有益于包含或排除它。第i个主成分的PRTV可以使用特征值计算如下:

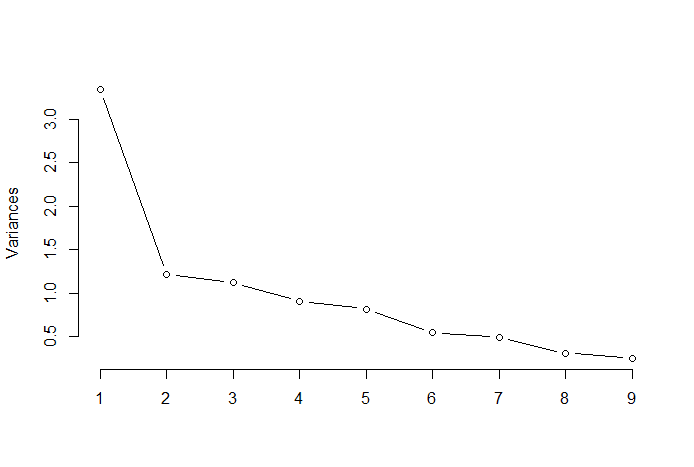

拐点法则

拐点法则或拐点方法是一种启发式方法,用于确定PCA结果中最佳主成分的数量。该方法的思想是将解释的变异作为主成分数量的函数进行绘制,并选择曲线的拐点作为最佳主成分的数量。下面是一个这样的散点图示例,其中PRTV(Y轴)以主成分数量(X轴)作为函数进行绘制。拐点对应于X轴值为2,这表明最佳主成分的数量为2。

图片来源:Multivariate Statistics Github

图片来源:Multivariate Statistics Github

因子分析(FA)

因子分析(Factor Analysis,FA)是另一种降维的统计方法。它是最常用的相互依赖技术之一,在相关变量集显示系统相互依赖且目标是找出创建共同性的潜在因子时使用。假设我们有一个包含p个变量(X1,X2,…,Xp)的数据X。FA模型可以表示如下:

其中,X是一个[p x N]的矩阵,代表p个变量和N个观测值,µ是[p x N]的总体均值矩阵,A是[p x k]的公共因子载荷矩阵,F [k x N]是公共因子矩阵,u [pxN]是特定因子矩阵。因此,换句话说,因子模型可以看作是一系列多元回归,用未观测到的公共因子fi的值来预测每个变量Xi:

每个变量有k个自己的共同因子,这些因子通过因子载荷矩阵与观测值相关联。在因子分析中,通过最大化组间方差和最小化组内方差来计算因子。它们被称为因子,因为它们将底层变量分组。与主成分分析(PCA)不同,FA要求对数据进行归一化处理,因为FA假设数据集服从正态分布。

Tatev Karen Aslanyan 是一位经验丰富的全栈数据科学家,专注于机器学习和人工智能。她还是在线技术教育平台LunarTech的联合创始人和The Ultimate Data Science Bootcamp的创建者。Tatev Karen拥有经济计量学和管理科学的学士和硕士学位,并在机器学习和人工智能领域取得了长足的发展,专注于推荐系统和自然语言处理,并支持她的科学研究和发表的论文。在教学五年后,Tatev现在将她的热情投入到LunarTech中,帮助塑造数据科学的未来。

原文。获得授权转载。