随着人工智能融入我们的日常生活,偏见模型对用户可能产生严重后果

2021年,普林斯顿大学信息技术政策中心发布了一份报告,他们发现机器学习算法可以从训练数据中学习类似于人类的偏见。这种效应的一个显著例子是关于亚马逊的AI招聘工具的研究[1]。该工具是基于亚马逊在前一年收到的简历进行训练的,并对不同的候选人进行排名。由于过去十年技术职位中存在巨大的性别失衡,算法学会了与女性相关的语言,如女子运动队,并降低了此类简历的排名。这个例子突显了不仅公平准确的模型,而且数据集也必须消除训练过程中的偏见的必要性。在ChatGPT等生成模型快速发展和人工智能融入我们的日常生活的当前背景下,一个有偏见的模型可能会产生严重后果,破坏用户的信任和全球接受度。因此,从商业角度来看,解决这些偏见是必要的,数据科学家(广义上的定义)必须意识到这些偏见,以减轻它们并确保与他们的原则一致。

生成模型中的偏见示例

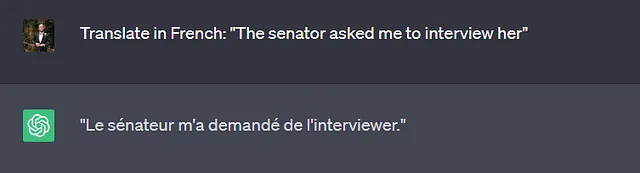

我首先想到的一种广泛使用生成模型的任务类型是翻译任务。用户输入语言A的文本,期望得到语言B的翻译。不同的语言不一定使用相同类型的性别代词,例如英语中的“参议员”既可以是女性也可以是男性,而在法语中,则是“La sénatrice”或“Le sénateur”。即使在句子中指定了性别(下面的例子),生成模型在翻译过程中也经常强化性别刻板印象。

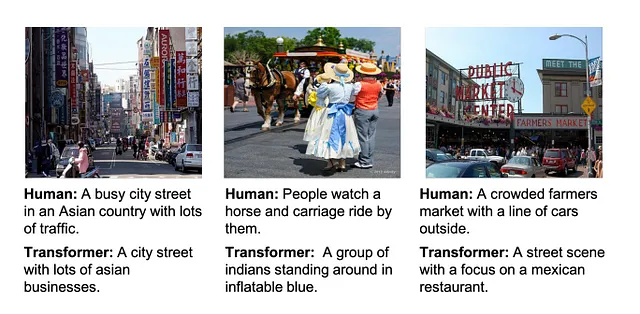

与翻译任务类似,字幕生成任务要求模型根据某些输入生成新的文本,例如从图像到文本的翻译。最近的一项研究[2]分析了生成变压器模型在通用上下文对象数据集上进行字幕生成任务的性能(下图)。

尽管这些描述词只是由更新的生成模型学习到的,并且在所有图像中并不适用,但生成模型为字幕分配了各种种族和文化的描述。值得注意的是,对于这个数据集,变压器模型也表现出性别偏见,通过识别一个人是否是女性,取决于房屋/房间的背景等因素,加剧了男女不平衡比例。

为什么会出现偏见?

生成模型的概念阶段为模型内部产生偏见提供了充足的空间。这些偏见可能来自数据本身、标签和注释、内部表示甚至模型本身(参见https://huggingface.co/blog/ethics-soc-4,其中有一份专注于文本到图像模型的广泛列表)。

生成模型的训练所需的数据来自多种来源,通常是在线的。为了确保训练数据的完整性,人工智能公司通常使用知名的新闻网站和类似网站来构建他们的数据库。基于这个数据集训练的模型将会因为考虑到的限制性人口统计数据(通常是白人、中年人、中上阶层)而延续偏见关联。

标签偏见(https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3994857/)可能更明确,因为它导致了引入偏见,通常是无意识地,到标记数据中。生成模型的训练目标是复制/近似其训练数据集,因此标签中的偏见将对模型的输出表示产生重大影响。值得庆幸的是,使用多个版本的标签并进行交叉检查可以减轻偏见。

最后两种偏见,即内部表示和模型偏见,都来自建模的特定步骤。第一种是在预处理阶段引入的,可以是手动或算法的。这个阶段容易引入偏见和文化细微差异的损失,特别是如果原始数据集缺乏多样性。模型偏见仅仅源于基于歧视性特征的目标函数和偏见的放大,以提高模型的准确性。

检测生成模型中的偏见

正如本文所强调的,生成模型中的偏见以各种形式在不同条件下观察到。检测它们的方法必须与它们试图检测的偏见一样多样。

语言模型中偏见的主要度量之一是词嵌入关联性测试。这个分数衡量了嵌入空间(内部表示)中两组单词之间的相似性。高分表示强烈的关联性。更具体地说,它计算了目标词组与两个输入词组之间的相似性差异,例如以[home, family]为目标,以[he, man]/[she, woman]为输入。分数为0表示一个完全平衡的模型。这个度量被用来证明RoBERTa是最具偏见的生成模型之一(https://arxiv.org/pdf/2106.13219.pdf)。

一种衡量生成模型偏见的创新方法(对事实进行评估),尤其是性别偏见,是交换单词的性别并观察预测准确性的变化。如果修改后的准确性和原始准确性不同,这就突显了模型中存在偏见的存在,因为一个没有偏见的生成模型应该在输入的性别上准确无误。这个度量的主要缺点是它只捕捉到性别偏见,因此必须通过其他度量来全面评估偏见来源。类似的想法,可以使用双语评估助手(一个经典的翻译度量)来比较从性别交换输入得到的输出与原始输出之间的相似性。

当前的生成模型基于使用注意力特征来根据输出预测输出的变压器模型。研究通过直接使用模型的注意力分数(https://arxiv.org/abs/2110.15733)来调查性别和角色之间的关系。这允许比较模型中的不同部分,以检测哪个模块对偏见的贡献更大。虽然通过这个度量表明生成模型在维基百科数据集上引入了性别偏见,但这个度量的一个缺点是注意力值不代表直接效果和概念之间的相似性,需要进行深入分析才能得出任何结论。

如何克服生成模型中的偏见?

研究人员已经开发出各种技术来提供更少偏见的生成系统。大多数情况下,这些技术包括建模中的额外步骤,例如设置一个控制变量,根据先前的信息来确定性别,或者添加另一个模型来提供上下文信息。然而,所有这些步骤不一定解决了使用固有偏见数据集的问题。此外,大多数生成模型都是基于英语训练数据的,严重限制了这些模型的文化和社会多样性。

要完全克服生成模型中的偏见,需要建立一个正式的框架和基准来测试和评估跨多种语言的模型。这将允许检测在多样化的AI模型中以微妙方式存在的偏见。

参考文献

- 亚马逊放弃了一项显示对女性偏见的秘密AI招聘工具,杰弗里·达斯汀,https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

- 理解和评估图像字幕中的种族偏见,Dora Zhao,Angelina Wang,Olga Russakovsky,https://arxiv.org/pdf/2106.08503.pdf

关注我的VoAGI,获取更多有关数据科学的内容!

如果您喜欢阅读这样的故事并想支持我作为作家,请考虑注册成为VoAGI会员。每月5美元,您将无限制地访问VoAGI上的故事。如果您使用我的链接注册,我将获得一小笔佣金。

使用我的推荐链接加入VoAGI – Kevin Berlemont, 博士

作为VoAGI会员,您的会费的一部分将用于支持您所阅读的作家,您将获得对每个故事的完全访问权限…

VoAGI.com