随着生成技术的迅猛发展,机器学习正处于其历史上非常令人兴奋的阶段。推动这一发展的模型需要更多的数据来产生有影响力的结果,因此,探索新的方法以在确保数据隐私和安全的前提下合规地收集数据变得越来越重要。

在许多涉及敏感信息领域,例如医疗保健,往往没有足够高质量的数据可用于训练这些需要大量数据的模型。数据集被隔离在不同的学术中心和医疗机构中,并且由于涉及患者和专有信息的隐私问题,很难公开共享。保护患者数据的法规,如HIPAA,对于保护个人的私密健康信息至关重要,但它们可能限制机器学习研究的进展,因为数据科学家无法获取有效训练模型所需的大量数据。能够与现有法规一起工作,积极保护患者数据的技术将对解决这些隔离问题、加速机器学习研究和在这些领域部署的速度至关重要。

这就是联邦学习的用武之地。查看我们与Substra合作创建的空间,以了解更多信息!

什么是联邦学习?

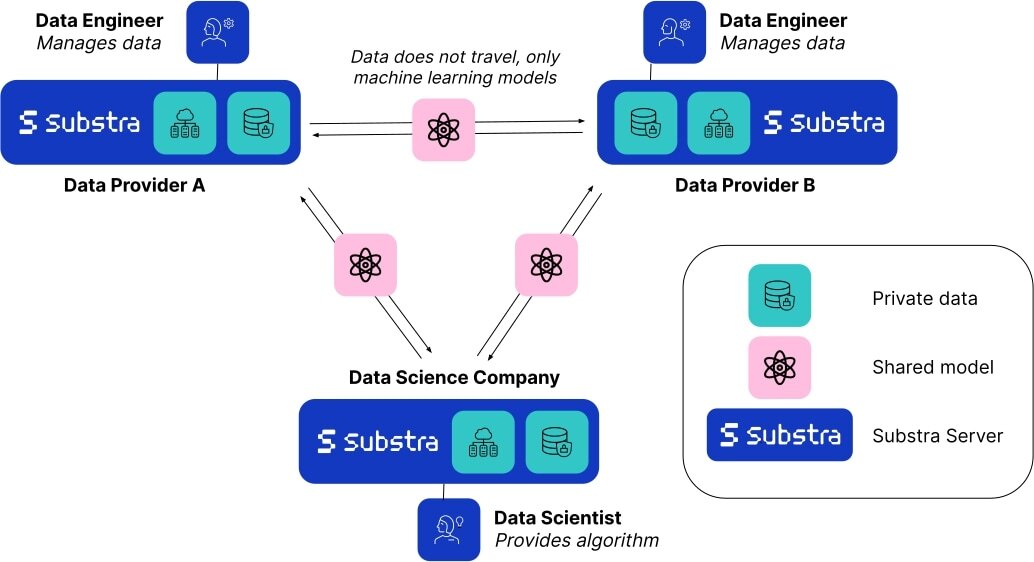

联邦学习(FL)是一种分散式机器学习技术,允许您使用多个数据提供者训练模型。数据不需要从所有来源收集到单个服务器上,而是可以保留在本地服务器上,只有最终模型的权重在服务器之间传输。

由于数据从不离开其来源,联邦学习自然是一种以隐私为先的方法。这种技术不仅改善了数据安全和隐私,还使数据科学家能够使用来自不同来源的数据构建更好的模型,增加了模型的鲁棒性,并提供了更好的表示,与仅使用单一来源数据训练的模型相比。这不仅因为数据数量的增加,还因为减少了由数据采集技术和设备引起的数据捕获技术和设备引起的微小差异,或患者群体的人口统计学分布差异等造成的偏差风险。有了多个数据源,我们可以构建更具一般化能力的模型,最终在真实世界环境中表现更好。有关联邦学习的更多信息,我们建议查看谷歌的这本解释漫画。

Substra是一个专为真实生产环境而构建的开源联邦学习框架。虽然联邦学习是一个相对较新的领域,并且在过去的十年中才开始发展,但它已经使机器学习研究能够以前所未有的方式取得进展。例如,10家竞争的生物制药公司传统上从不与对方共享数据,但是他们在MELLODDY项目中建立了合作关系,共享了世界上最大的已知生化或细胞活性的小分子集合。这最终使所有参与公司能够为药物研究建立更准确的预测模型,这是医学研究的一个重大里程碑。

Substra x HF

联邦学习能力的研究正在迅速增长,但大部分最近的工作仍然局限于模拟环境。由于部署和构建联邦网络的困难,真实世界的实例和实施仍然有限。作为领先的开源联邦学习平台,Substra在许多复杂的安全环境和IT基础设施中经过了实战测试,并在乳腺癌研究中取得了医学突破。

Hugging Face与管理Substra的团队合作创建了这个空间,目的是让您了解研究人员和科学家面临的现实挑战,主要是缺乏集中的高质量数据,这些数据对AI‘准备好’。由于您可以控制这些样本的分发,您将能够看到一个简单模型对数据变化的反应。然后,您可以观察使用联邦学习训练的模型与使用单一来源数据训练的模型相比,几乎总是在验证数据上表现更好。

结论

尽管联邦学习一直领先于其他各种增强隐私的技术(PETs),如安全飞地和多方计算,但这些技术仍然可以与联邦学习相结合,创建多层次的隐私保护环境。如果您对这些技术如何在医学中促进合作感兴趣,可以在这里了解更多信息。

无论使用何种方法,重要的是要警惕数据隐私是我们所有人的权利。在这个人工智能的繁荣中,保护隐私和伦理至关重要。

如果你想在项目中尝试Substra并实现联邦学习,你可以在这里查看文档。