领先的项目,通过可访问的大型语言模型赋能社区

近年来,大型语言模型或LLM已经占据了世界。随着ChatGPT的推出,每个人都能够从文本生成模型中受益。但是,许多强大的模型仅在商业上可用,留下了许多伟大的研究和定制。

当然,现在有许多项目正在尝试完全开源许多LLMs。 Pythia、Dolly、DLite和许多其他项目都是其中的一些例子。但是为什么要尝试使LLMs开源呢?这是社区的情感,推动所有这些项目弥合封闭模型带来的限制。然而,开源模型是否与封闭模型相比较劣呢?当然不是。许多模型可以与商业模型匹敌,并在许多领域显示出有前途的结果。

为了跟进这一运动,开源项目之一以民主化LLM为目标的是RedPajama。这个项目是什么,它如何使社区受益呢?让我们进一步探讨。

RedPajama

RedPajama是Ontocord.ai、ETH DS3Lab、Stanford CRFM和Hazy Research之间的协作项目,旨在开发可重复的开源LLMs。 RedPajama项目包含三个里程碑,包括:

- 预训练数据

- 基本模型

- 指令调整数据和模型

当撰写本文时,RedPajama项目已经开发了包括基础、指导和聊天版本在内的预训练数据和模型。

RedPajama预训练数据

在第一步中,RedPajama试图复制半开放模型的LLaMa数据集。这意味着RedPajama试图构建包含12万亿令牌的预训练数据,并将其完全开源给社区。目前,完整数据和样本数据可以在HuggingFace上下载。

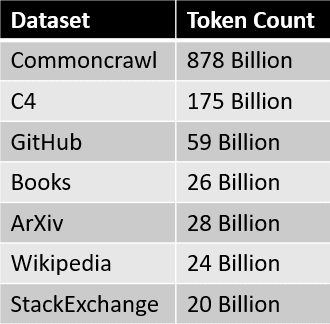

RedPajama数据集的数据来源总结在下表中。  每个数据片段都经过仔细处理和过滤,令牌数量也大致与LLaMa论文中报告的数量相匹配。

每个数据片段都经过仔细处理和过滤,令牌数量也大致与LLaMa论文中报告的数量相匹配。

数据集创建后的下一步是开发基本模型。

RedPajama模型

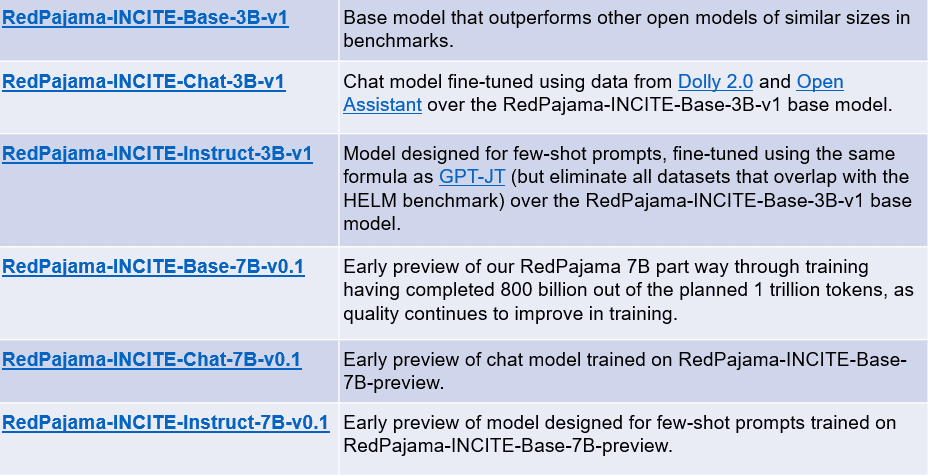

在RedPajama数据集创建后的几周内,发布了第一个在数据集上训练的模型。基本模型有两个版本:3亿和70亿个参数的模型。 RedPajama项目还发布了每个基础模型的两个变体:指令调整和聊天模型。

每个模型的摘要如下表所示。

您可以使用以下链接访问上述模型:

- RedPajama-INCITE-Base-3B-v1

- RedPajama-INCITE-Chat-3B-v1

- RedPajama-INCITE-Instruct-3B-v1

- RedPajama-INCITE-Base-7B-v0.1

- RedPajama-INCITE-Chat-7B-v0.1

- RedPajama-INCITE-Instruct-7B-v0.1

让我们尝试RedPajama基本模型。例如,我们将尝试使用从HuggingFace调整的代码的RedPajama 3B基础模型。

import torch

import transformers

from transformers import AutoTokenizer, AutoModelForCausalLM

# init

tokenizer = AutoTokenizer.from_pretrained(

"togethercomputer/RedPajama-INCITE-Base-3B-v1"

)

model = AutoModelForCausalLM.from_pretrained(

"togethercomputer/RedPajama-INCITE-Base-3B-v1", torch_dtype=torch.bfloat16

)

# infer

prompt = "Mother Teresa is"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

input_length = inputs.input_ids.shape[1]

outputs = model.generate(

**inputs,

max_new_tokens=128,

do_sample=True,

temperature=0.7,

top_p=0.7,

top_k=50,

return_dict_in_generate=True

)

token = outputs.sequences[0, input_length:]

output_str = tokenizer.decode(token)

print(output_str)

a Catholic saint and is known for her work with the poor and dying in Calcutta, India.

Born in Skopje, Macedonia, in 1910, she was the youngest of thirteen children. Her parents died when she was only eight years old, and she was raised by her older brother, who was a priest.

In 1928, she entered the Order of the Sisters of Loreto in Ireland. She became a teacher and then a nun, and she devoted herself to caring for the poor and sick.

She was known for her work with the poor and dying in Calcutta, India.3B基础模型的结果令人鼓舞,如果使用7B基础模型可能会更好。由于开发仍在进行中,该项目将来可能会有更好的模型。

结论

生成式人工智能正在崛起,但不幸的是,许多优秀的模型仍被锁定在公司的档案中。RedPajama是试图复制半开放LLaMA模型以民主化LLMs的领先项目之一。通过开发类似于Llama的数据集,RedPajama成功创建了一个开源的1.2万亿令牌数据集,许多开源项目都在使用。

RedPajama还发布了两种模型;3B和7B参数基础模型,每个基础模型都包含指令调整和聊天模型。Cornellius Yudha Wijaya是数据科学助理经理和数据作者。在全职工作于Allianz Indonesia的同时,他喜欢通过社交媒体和写作媒体分享Python和数据技巧。