在商业领域,你所需要的数据已经不再只存在于你的“小黑簿”之中。在这个数字革命的时代,即使是传统数据库也不再足够。

处理大数据已经成为企业和数据科学家的关键技能。大数据以其数据量、速度和多样性而闻名,为我们提供了前所未有的对模式和趋势的洞察。

要有效处理这样的数据,需要使用专门的工具和技术。

什么是大数据?

不,它不仅仅是大量的数据。

大数据最常被三个V所描述:

- 数据量:是的,生成和存储的数据规模是其特征之一。要被归类为大数据,数据的规模必须以拍字节(1,024 TB)和艾字节(1,024 PB)来衡量。

- 数据多样性:大数据不仅包括结构化数据,还包括半结构化数据(JSON、XML、YAML、电子邮件、日志文件、电子表格)和非结构化数据(文本文件、图像和视频、音频文件、社交媒体帖子、网页、科学数据,如卫星图像、地震波形数据或原始实验数据),并且重点是非结构化数据。

- 数据速度:数据的生成和处理速度。

大数据工具和技术

所有提到的大数据特征都会影响我们处理大数据所使用的工具和技术。

当我们谈论大数据技术时,它们只是我们处理、分析和管理大数据时使用的方法、算法和方法。从表面上看,它们与常规数据的处理方式相同。然而,我们讨论的大数据特征需要不同的方法和工具。

以下是大数据领域中使用的一些著名工具和技术。

1. 大数据处理

是什么?数据处理是指将原始数据转化为有意义的信息的操作和活动。它涉及从数据清洗和结构化到运行复杂算法和分析的各种任务。

大数据有时会进行批处理,但更常见的是数据流处理。

主要特点:

- 并行处理:将任务分布在多个节点或服务器上并行处理数据,加快计算速度。

- 实时处理与批处理:数据可以实时处理(随着数据的生成)或批处理(定期处理数据块)。

- 可扩展性:大数据工具通过扩展,添加更多资源或节点来处理海量数据。

- 容错性:如果节点发生故障,系统将继续处理,确保数据的完整性和可用性。

- 多样化的数据来源:大数据来自许多来源,包括结构化数据库、日志、流数据或非结构化数据存储库。

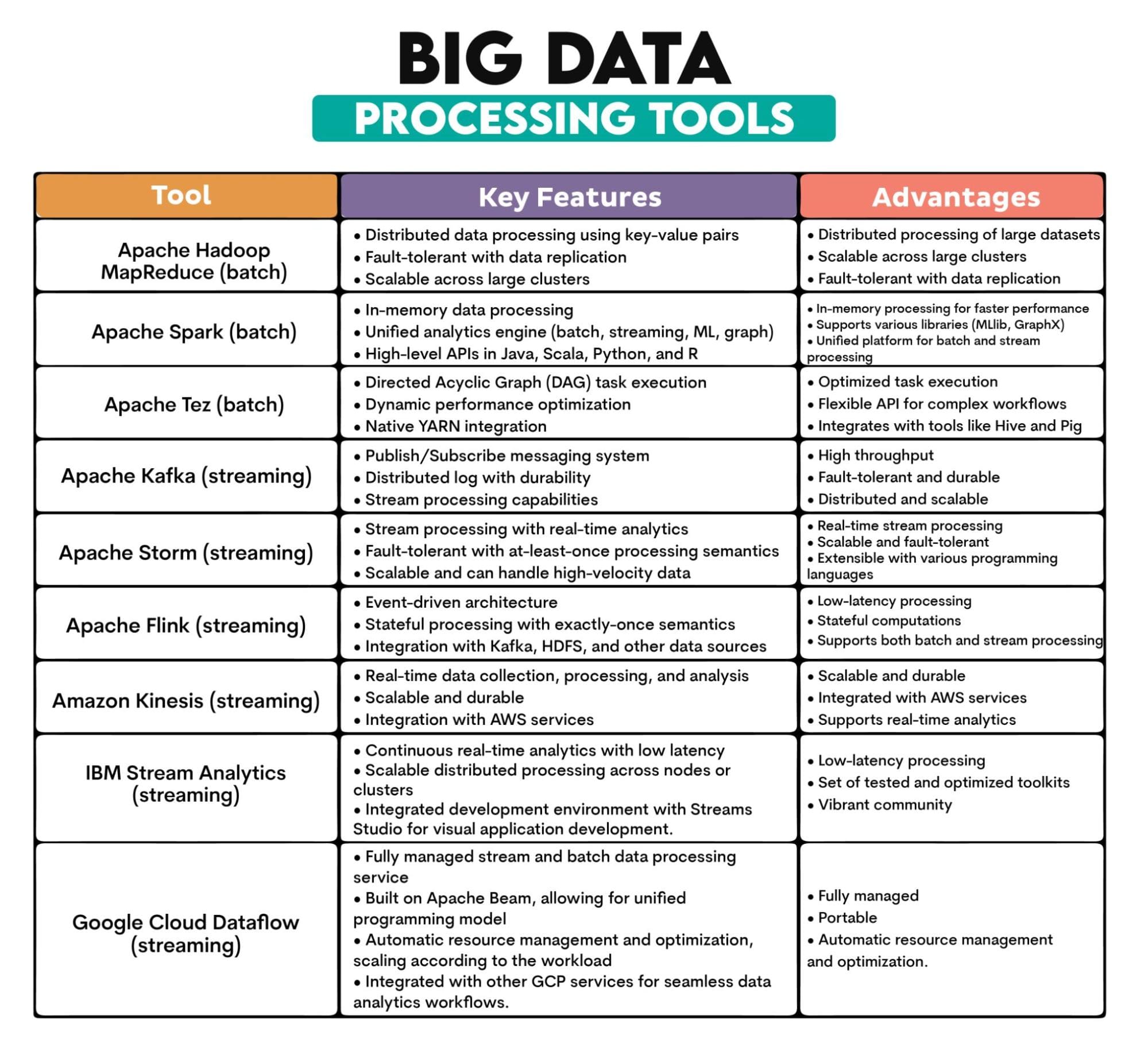

使用的大数据工具:Apache Hadoop MapReduce、Apache Spark、Apache Tez、Apache Kafka、Apache Storm、Apache Flink、Amazon Kinesis、IBM Streams、Google Cloud Dataflow

工具概述:

2. 大数据ETL

是什么?ETL指的是从各种来源提取数据,将其转化为结构化和可用的格式,并将其加载到数据存储系统中以进行分析或其他目的。

大数据的特点意味着ETL过程需要处理来自更多来源的更多数据。数据通常是半结构化或非结构化的,与结构化数据不同,它们的转换和存储方式也不同。

大数据的ETL通常需要实时处理数据。

关键特征:

- 数据提取:从各种异构源(包括数据库、日志、API和平面文件)检索数据。

- 数据转换:将提取的数据转换为适合查询、分析或报告的格式。包括数据清理、增强、聚合和重新格式化。

- 数据加载:将转换后的数据存储到目标系统,如数据仓库、数据湖或数据库。

- 批处理或实时:实时ETL过程在大数据中比批处理更普遍。

- 数据集成:ETL从不同的源集成数据,确保组织内数据的统一视图。

使用的大数据工具:Apache NiFi、Apache Sqoop、Apache Flume、Talend

工具概述:

| 大数据ETL工具 | ||

| 工具 | 主要特点 | 优势 |

| Apache NiFi |

• 通过基于Web的用户界面设计数据流 • 数据溯源追踪 • 支持处理器的可扩展架构 |

• 可视化界面:设计数据流程简单 • 支持数据溯源 • 可以使用各种处理器进行扩展 |

| Apache Sqoop |

• 在Hadoop和数据库之间进行大规模数据传输 • 并行导入/导出 • 压缩和直接导入功能 |

• 在Hadoop和关系数据库之间进行高效数据传输 • 并行导入/导出 • 增量数据传输能力 |

| Apache Flume |

• 事件驱动和可配置的架构 • 可靠和持久的数据传输 • 与Hadoop生态系统的本地集成 |

• 可扩展和分布式 • 容错架构 • 可以通过自定义源、通道和接收器进行扩展 |

| Talend |

• 可视化设计界面 • 对数据库、应用程序等的广泛连接 • 数据质量和分析工具 |

• 针对各种数据源的广泛连接器 • 图形化界面用于设计数据集成流程 • 支持数据质量和主数据管理 |

3. 大数据存储

是什么:大数据存储必须存储大量以高速度和各种格式生成的数据。

存储大数据的三种最显著的方式是NoSQL数据库、数据湖和数据仓库。

NoSQL数据库专为处理大量结构化和非结构化数据而设计,没有固定的模式(NoSQL – Not Only SQL)。这使它们能够适应不断演变的数据结构。

与传统的垂直可扩展数据库不同,NoSQL数据库是水平可扩展的,意味着它们可以将数据分布在多个服务器上。通过向系统添加更多机器,扩展变得更容易。它们具有容错能力,具有低延迟(在需要实时数据访问的应用程序中受到欢迎),并且在规模上具有成本效益。

数据湖是存储库,以其原始格式存储大量原始数据。这简化了数据访问和分析,因为所有数据都位于一个地方。

数据湖具有可扩展性和成本效益。它们提供灵活性(数据以原始形式摄取,并在读取数据进行分析时定义结构),支持批处理和实时数据处理,并可以与数据质量工具集成,从而实现更高级的分析和更丰富的洞察。

数据仓库是一个优化了分析处理的中央存储库,它存储来自多个来源的数据,将其转换为适合分析和报告的格式。

它旨在存储大量数据,从各种来源集成数据,并允许历史分析,因为数据是带有时间维度存储的。

关键特点:

- 可扩展性:通过添加更多节点或单元进行扩展设计。

- 分布式架构:数据通常存储在多个节点或服务器上,确保高可用性和容错性。

- 多种数据格式:可以处理结构化、半结构化和非结构化数据。

- 持久性:一旦存储,数据保持完整和可用,即使在硬件故障的情况下也是如此。

- 成本效益:许多大数据存储解决方案设计为在商品硬件上运行,使它们在规模上更具可负担性。

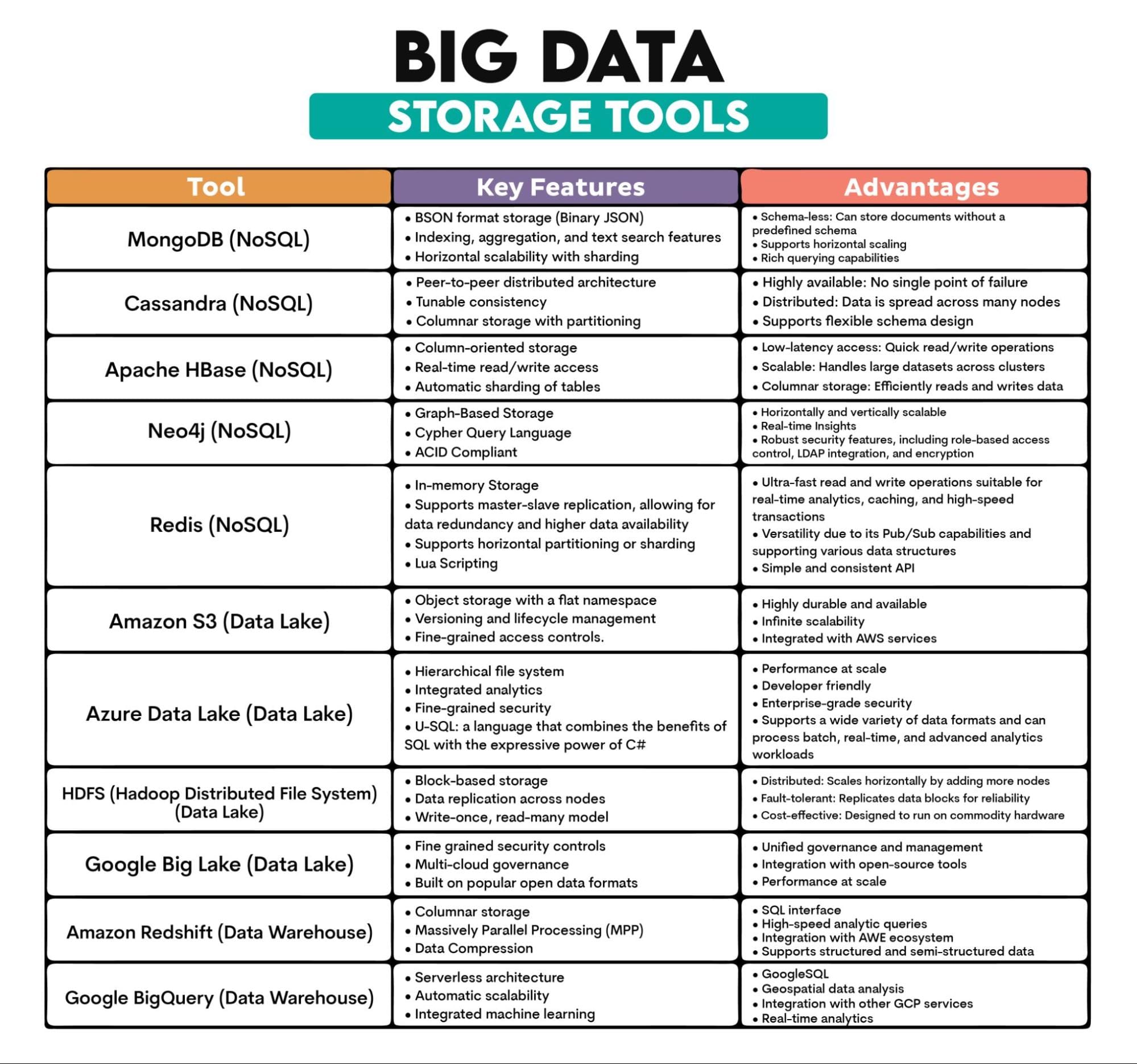

使用的大数据工具:MongoDB(文档型),Cassandra(列型),Apache HBase(列型),Neo4j(图形型),Redis(键值存储),Amazon S3,Azure Data Lake,Hadoop分布式文件系统(HDFS),Google Big Lake,Amazon Redshift,BigQuery

工具概述:

4. 大数据挖掘

是什么:它是在大型数据集中发现模式、相关性、异常和统计关系的过程。它涉及机器学习、统计学以及使用数据库系统从数据中提取洞见的学科。

挖掘的数据量庞大,庞大的数据量可以揭示在较小的数据集中可能不明显的模式。大数据通常来自各种来源,通常是半结构化或非结构化的。这就需要更复杂的预处理和集成技术。与常规数据不同,大数据通常是实时处理的。

用于大数据挖掘的工具必须处理所有这些。为此,它们应用分布式计算,即数据处理分布在多台计算机上。

一些算法可能不适用于大数据挖掘,因为它需要可扩展的并行处理算法,例如支持向量机(SVM),随机梯度下降(SGD)或梯度提升(Gradient Boosting)。

大数据挖掘还采用了探索性数据分析(EDA)技术。EDA分析数据集以总结其主要特征,通常使用统计图形、图表和信息表。因此,我们将讨论大数据挖掘和EDA工具。

关键特点:

- 模式识别:在大型数据集中识别规律或趋势。

- 聚类和分类:根据相似性或预定义的标准对数据点进行分组。

- 关联分析:发现大型数据库中变量之间的关系。

- 回归分析:理解和建模变量之间的关系。

- 异常检测:识别异常模式。

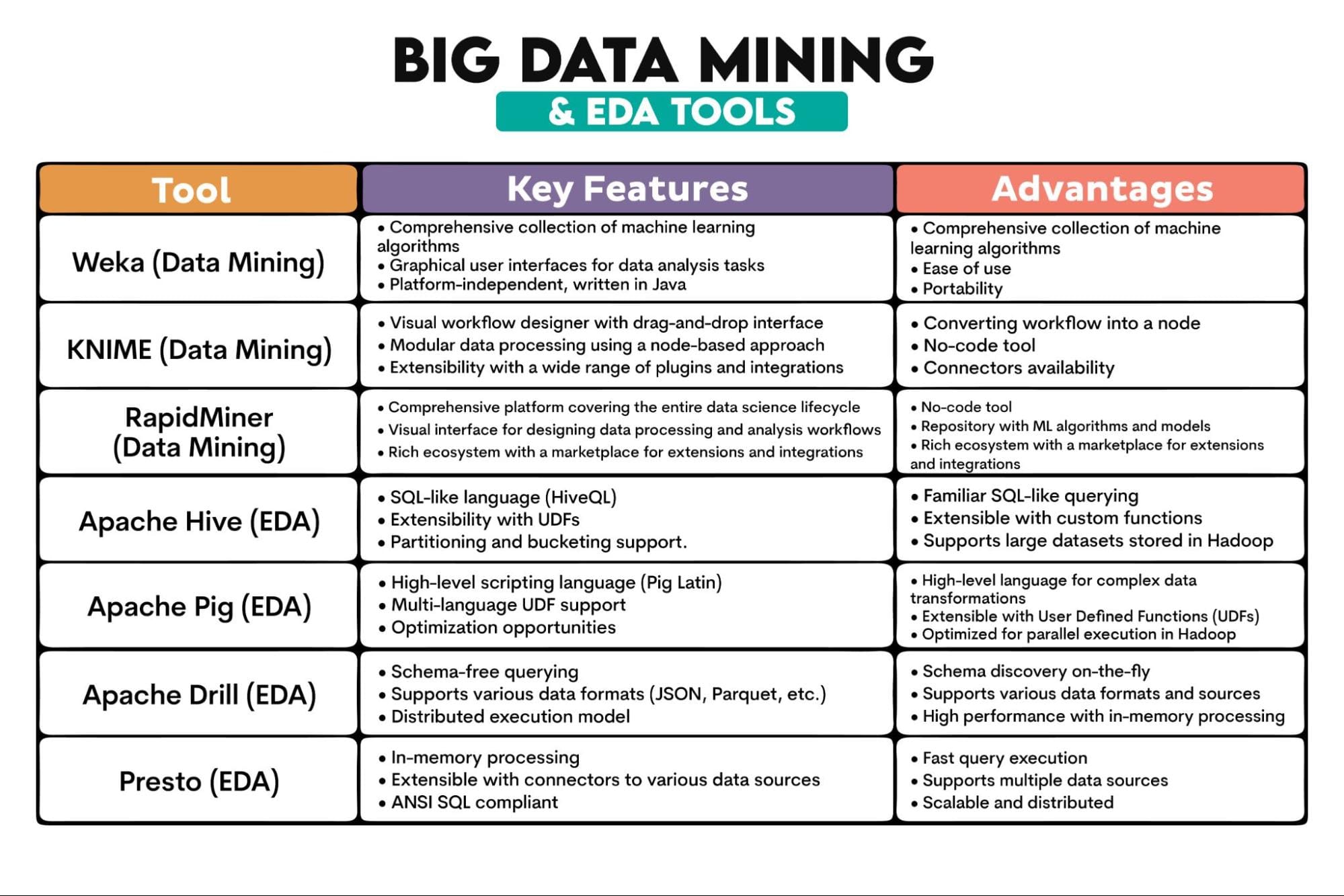

使用的大数据工具:Weka,KNIME,RapidMiner,Apache Hive,Apache Pig,Apache Drill,Presto

工具概述:

5. 大数据可视化

是什么:它是从大型数据集中提取的信息和数据的图形表示。使用图表、图形和地图等可视元素,数据可视化工具提供了一种便于理解数据中的模式、异常值和趋势的方法。

同样,大数据的特征,如大小和复杂性,使其与常规数据可视化不同。

关键特点:

- 交互性:大数据可视化需要交互式仪表板和报告,允许用户深入研究特定信息并动态探索数据。

- 可扩展性:需要高效处理大型数据集,而不损害性能。

- 多样化的可视化类型:例如热力图、地理空间可视化和复杂网络图。

- 实时可视化:许多大数据应用需要实时数据流和可视化,以监控和对实时数据做出反应。

- 与大数据平台的集成:可视化工具通常与大数据平台无缝集成。

使用的大数据工具:Tableau,PowerBI,D3.js,Kibana

工具概述:

结论

大数据与常规数据非常相似,但也完全不同。它们共享处理数据的技术。但由于大数据的特性,这些技术仅仅在名称上相同。否则,它们需要完全不同的方法和工具。

如果你想进入大数据领域,你将不得不使用各种大数据工具。我们对这些工具的概述应该是一个很好的起点。Nate Rosidi是一位数据科学家和产品策略师。他还是一名兼职教授,教授分析学,并且是StrataScratch的创始人,这是一个帮助数据科学家准备面试的平台,提供来自顶级公司的真实面试问题。你可以在Twitter上与他联系:StrataScratch或LinkedIn。